1週間の気になる生成AI技術・研究をいくつかピックアップして解説する連載「生成AIウィークリー」から、特に興味深い技術や研究にスポットライトを当てる生成AIクローズアップ。

今回は、人には聞こえないノイズを音楽に埋め込み、その音声をAIモデルが学習できないようにする防御フレームワークを提案した論文「HarmonyCloak: Making Music Unlearnable for Generative AI」に注目します。

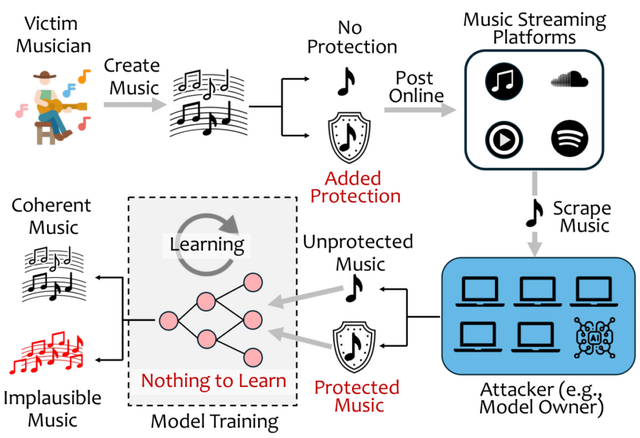

▲攻撃者がクリエイターがオンラインに投稿した音楽をスクレイピングして、音楽生成AIをトレーニングするモデルの図解

生成AIは膨大な音楽データベースから学習を行うため、著作権で保護された素材を意図せず侵害するリスクが高まっており、ミュージシャンや声優などの生計と芸術性の両方を脅かしています。

この課題に対応するため、研究チームは「HarmonyCloak」というフレームワークを開発しました。これは音楽をAIモデルにとって学習不可能にすることで、クリエイターの知的財産を保護する防衛的な取り組みです。

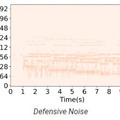

この技術の特徴的な点は、人間の耳には全く気づかれないようなノイズを音楽に埋め込むことです。例えば、ある楽曲は人間には完璧な音質で聴こえますが、AIにとっては無秩序で学習不可能なデータとして認識されます。その結果、AIモデルが保護された楽曲のスタイルを模倣しようとしても、生成される音楽は支離滅裂なものとなり、オリジナル作品の本質を捉えることができなくなります。

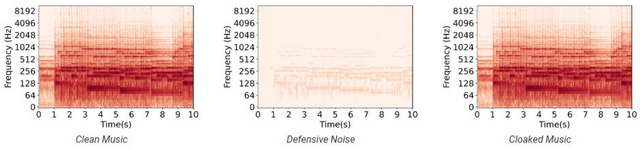

HarmonyCloakが導入する保護ノイズは、単純な付加的なノイズや隠し信号ではありません。人間の聴覚閾値以下に慎重に設計され、音楽自体に溶け込むように作られています。このノイズは音楽によってマスクされ、人間の耳には検出できませんが、AIの学習能力を妨げる効果があります。

さらに、各楽曲に対して動的に作成される保護層は、曲ごとに異なるパラメータを持つため、生成AIモデルはそれぞれの曲の具体的なパラメータを知らない限り、保護ノイズを解除することができません。

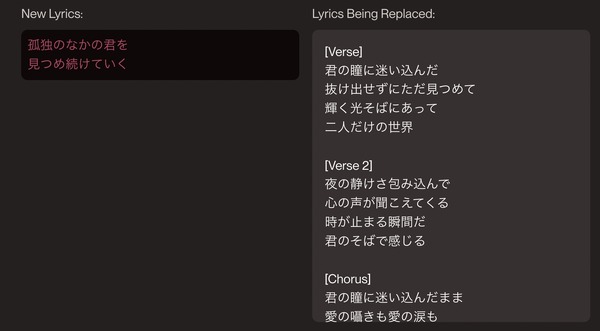

▲(左)オリジナル楽曲のスペクトログラム(中央)本手法で作成したノイズ(右)オリジナルとノイズを統合したもの

研究チームはMuseGAN、SymphonyNet、MusicLMなど、最新の音楽生成AIモデルを使用して実験を行い、2つの主要なシナリオで検証を行いました。1つ目は、AIモデルの詳細が既知である「ホワイトボックス」設定です。この場合、HarmonyCloakは特定のAIモデルに合わせて保護ノイズを最適化できます。2つ目は、使用されるAIモデルが不明な「ブラックボックス」設定です。この場合は様々な種類のAIモデルに対して汎用的な保護ノイズを適用します。

実験では、MP3への圧縮など一般的な音声処理を行った後でも保護効果が維持されることが確認されました。また、クラシック音楽からジャズ、現代の電子音楽まで、幅広いジャンルの音楽に対して効果的であることも実証されました。