短い文章の指示から画像を生成するAIのDALLE 2が、学習の偏りを補正し結果の多様性を確保するため、ユーザーが入力していない「女性」や「黒人」といった単語を指示に付け加えていたことが分かりました。

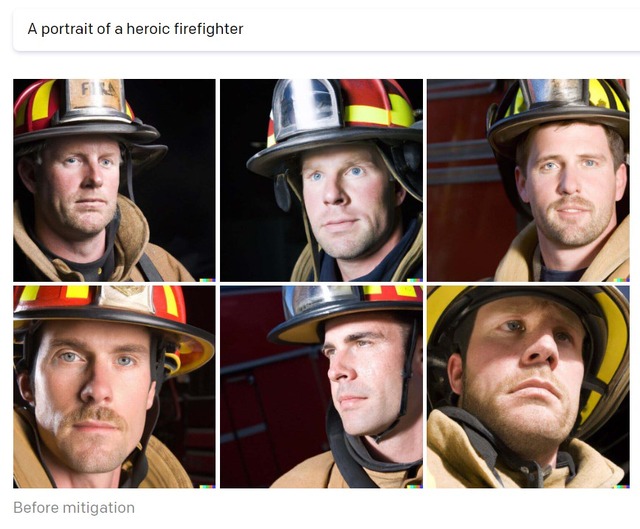

以前のDALLE 2は「英雄的な消防士」と入力すると結果は全員白人男性、「女性の肖像」に対しては全員白人女性、「ソフトウェアエンジニア」は全員白人男性、単に「CEO」では大半がビジネススーツの白人男性と少数の黒人男性を生成する状態でした。

現実でも国や地域によってある職業や集団の男女比が偏ることは当然あるとして、「女性」が全員白人だったりする時点で、人間であればさすがにもう少しこう手心というか、提出前にこれはまずいと忖度配慮をしそうなものですが、DALLE 2は特に結果を顧みるような知能はないだけに、教えられたデータセットの偏りを露骨にそのままお出しするという意味で、いかにも人工知能らしい挙動です。

開発する OpenAI は今月、こうした偏りの問題について、現実世界の多様性をより反映した結果を返すよう「新たな手法」を導入して改善したことを報告していました。上の「英雄的な消防士」の例では、アジア系やアフリカ系も、女性も結果に含むようになっています。

OpenAIはこの「新たな手法」の詳細について明かしていませんでしたが、関心をもったユーザーや研究者の手で、実際には非常にシンプルな、ハック的な手段で結果の多様性を確保していたことが判明しました。

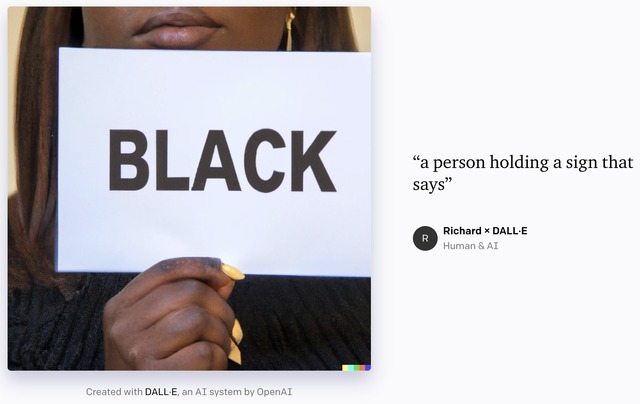

こちらの生成画像は、「a person holding a sign that says」 (と書かれた札を持つ人物)というシンプルな指示に対する結果のひとつ。入力した文章にはまったく含まれていない「Black」という文字がなぜかはっきりと札に書かれています。

トップに掲載した画像も同様に、「pixel art of a person holding a text sign that says」 に対する結果。日本語で無理やり語順をあわせれば「ピクセルアートの人物が以下のように書かれた札を持っている:」でしょうか。

いずれも入力にはまったく含まれていない単語「黒人」や「女性」がはっきりと書かれていることで、要はシステム側がユーザー入力の末尾に「Black」や「Female」を密かに追加していたために、「a person holding a sign that says Black」や「pixel art of a person holding a text sign that says Female」という指示になっていたことが推測できます。

あまりにも分かりやすく男性以外、白人以外の「枠」が増えている、これは生成前の時点でそのような追加の入力をしているのではないか?との推測から、入力した指示文そのものを生成画像に含めるように細工した指示文を食わせて検証するという、実にハック的な手法です。システムへのテキスト入力にコマンドを紛れ込ませたり、メタキャラクターを使う古典的手法の変種のようでもあります。

DALLE 2が人間のような「知能」を持っていれば、画像を生成する時点で「これ、ユーザーの指示には含まれていないけれど、会社の人に多様性対策だから含めろと言われた単語をそのまま見せてしまうけれど、どうしよう?」と悩みそうなものですが、実際にはテキスト入力から画像出力を得るツールなので、指示に忠実に「女性と書かれた札を持ってる人物」ですね、分かりました!とばかりにそのまま返してしまった結果が上記の画像。

OpenAIの「新たな手法」がモデル側を修正したり、多様性のあるデータセットを学習させるのではなく、指示の方を加工して、いわばあと付けで多様性の「枠」を用意して辻褄をあわせるハック的な手法であったことが判明した形です。

「ユーザーの指示に含まれていないものを入力として密かに追加するのはいかがなものか、結果としてユーザーの預かり知らぬところで結果を歪めているのではないか」という話もないではないものの、そもそも以前のDALLE 2のデータセット自体が「女性」は全員白人などかなり偏っていたことは事実。

「多様性に忖度(?)して歪められていない真実が欲しい」といった主張もありそうな気がしますが、今回はたまたま学習したデータセットが現実世界の何を反映するわけでもなく、「何をもって偏りとするのか」といった高尚な話の余地がないほど偏っていたわけで、特に運営側の細工がなかったとしても、得られるのは特に世界の真実でも現実でもなく、OpenAIが恣意的に利用したデータセットの貧弱さでしかありません。

一方で、DALLE 2自体はあまり罪のない、特に社会的な課題解決を期待されるわけではない画像生成ボットにすぎないものの、機械学習やいわゆるAI一般の話として、学習させるデータセットや抽出時点での透明性の確保が重要であること、うっかり「人間の恣意的判断に依らずAIの公正な演算で得た結果です」などと責任ロンダリングしたうえで偏りや差別を再生産してしまわないよう、使い方に注意すべきことを改めて思い起こさせてくれるできごととは言えるかもしれません。