世界をシミュレートするというSoraのワールドモデルに触発されて次々と新しい動画生成AIモデルが登場しています。

中国のKLING、Luma AIのDream Machineはそれまでの動画生成とは一線を画した品質です。その波に乗って、動画生成AIでは老舗のRunwayがGen-3 Alphaを一般公開しました。

使えるユーザーは有料のStandardプラン以上。筆者はそれに該当しているので使ってみました。

使える指示はプロンプトのみで、画像による参照は現時点では利用不可。画像をプロンプトフィールドにドロップできますが、その時点でGen-2になり、5秒しか生成されません。

(▲画像参照がうまくいったと思ったらGen-2で生成された)

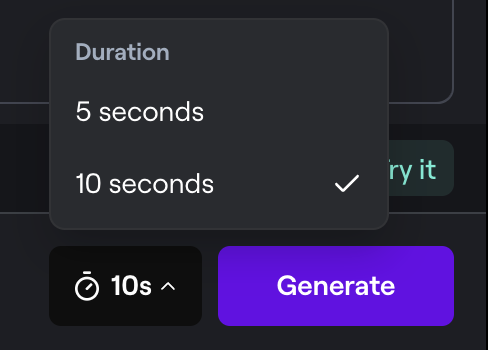

Gen-3では長さを5秒か10秒かを選択できます。10秒で生成してみましたが、生成時間は3分ちょっと。その先の再延長機能は今のところないようです。

Gen-3で作った動画のプロンプトはこちら。

A beautiful Japanese girl in white dress appears from the ground. Camera zooming up her eyes. In her eyes, there are cameraman. The girl closes her eyes, the scene go black.

生成された動画は、1280 × 768、24FPS、H.264エンコードで、データレートは2.18メガビット/秒でした。

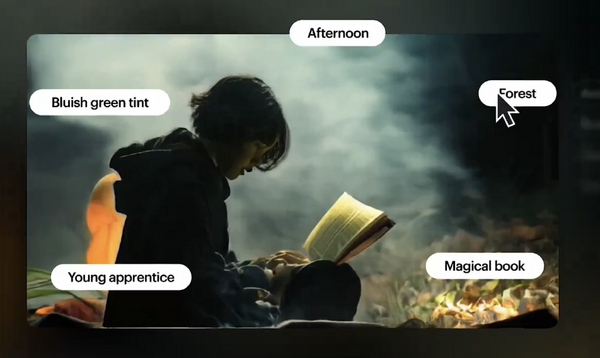

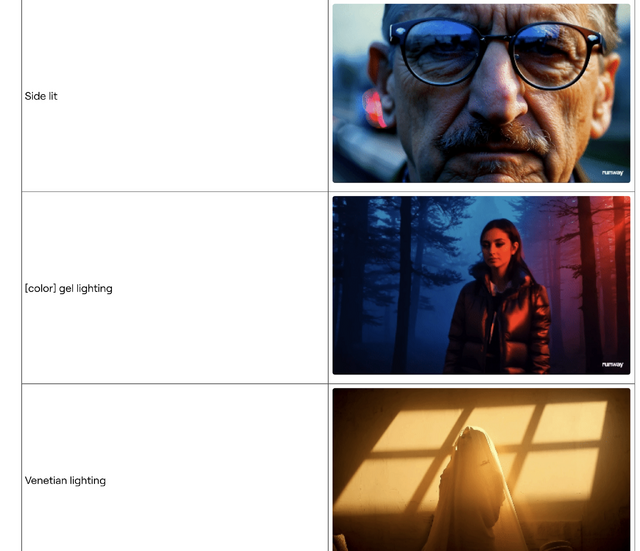

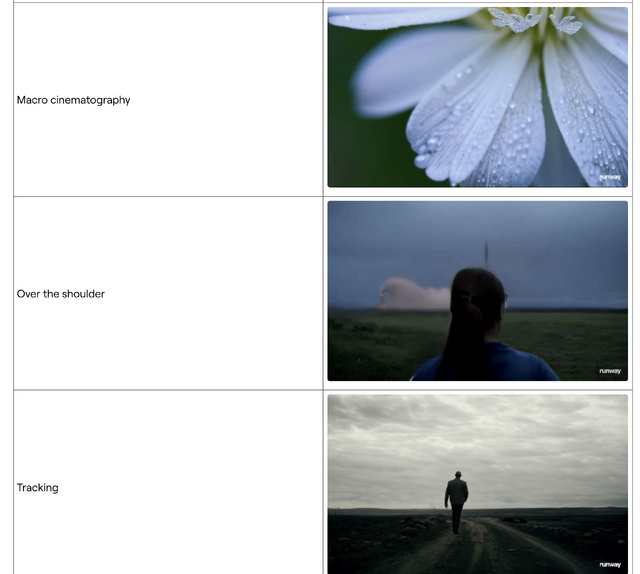

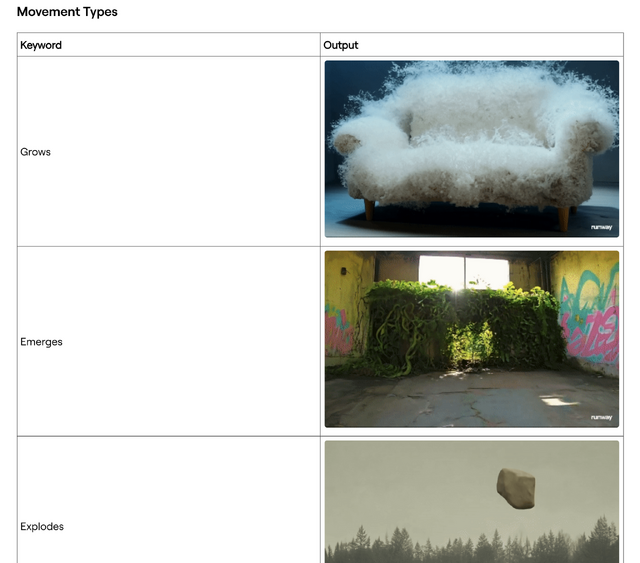

プロンプトガイドが素晴らしく、短いプレビュー付きでさまざまなライティング、カメラムーブメントやエフェクトを紹介しています。

(▲レンズ、ライティング、エフェクト、ムーブメントといったキーワード例が豊富)

Gen-3 Alphaは10秒生成にした場合、1回で100クレジットを消費。1秒当たり10クレジットということになります。Gen-2の2倍ですね。

筆者はStandardプランという、有料プランでは一番安いプランで、1カ月に使えるクレジットは650。60秒しか使えないことになりますが、クレジットは追加購入も可能。10ドルで1000クレジットです。

文字入れも可能です。サンプルプロンプトをちょっとだけ変えて作ってみました。

今のところ、すべてのコントロールはプロンプトだけ、というところがなかなか難しいところです。謎の生成エラーに3回ほど遭遇しました。

(▲生成エラーがけっこう起きる)

「秋葉原の雑踏で空に向かい上昇する美少女」というプロンプトで作ってみました。秋葉原なのに謎文字ですが。

(▲秋葉原の雑踏で空に向かい上昇する美少女)

カメラワーク、ライティングなどを勉強しないと思う通りの映像を作れない感じですが、その分スキルのある人なら活用できそうです。

おまけ。プロンプトは、「Dynamic movement: a very cute Japanese girl with long hair and eye bags singing on a stage. Camera zooming in her face from the ground」。

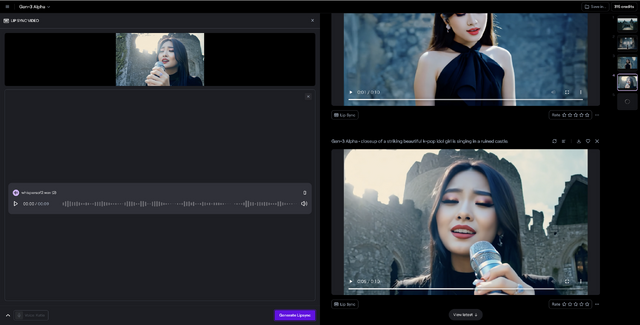

■実はリップシンク機能がすごい

RunwayはGen-2から、オーディオデータやテキスト入力に合わせてリップシンクする機能がありますが、Gen-3でも使えます。それを試してみました。

プロンプトによって人物入りの動画を生成した後、Lipsyncボタンを押すことで、リップシンクが可能になります。そのあとでオーディオデータかテキスト入力からのTTS(Text To Speach)で再び生成し、オーディオと同期をとった動画ができます。

指の形が謎だったり、マイクを持ち替えたときに空中に浮いているように見えたり、細部に変なところはありますが、カメラが移動しながら、顔以外のモーションもつけながらリップシンクができるのは素晴らしいです。

残念なのは、カメラ視点が動きすぎたり、人物の顔が小さすぎたりすると、生成に失敗するところ。これは仕方ないところですかね。

現在生成できるのは10秒までですが、さらに伸びたりImage to Video機能が使えるようになったら、もっとカンガン使っていきたいと思います。