OpenAIが、ChatGPTの延期していた新機能 Advanced Voice Mode を一部Plusユーザー向けに試験提供しました。

Advanced Voice Mode は、ChatGPTと音声で自然な会話ができる機能。

ChatGPT は従来から音声モードに対応していますが、現状では自然な声の会話というよりも、ターンが明確なテキストチャットが音声入力と読み上げで使えるといったほうが近い機能です。

新機能の Advanced Chat Mode は、ChatGPTの発話が非常に自然で反応が早いことに加えて、話している途中に遮ったり被せても素早く反応すること、会話の間や、ユーザーの口調から感情も読み取って対応するなど、より現実に近い音声会話が可能です。

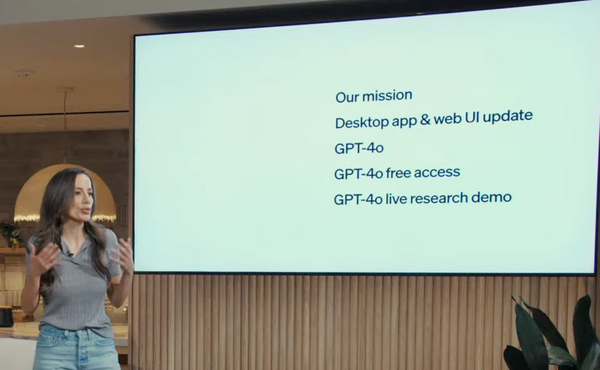

Advanced Voice Mode は GPT-4o モデルの一部として、5月のイベントで発表されていました。

当初は6月中に一部の ChatGPT Plus ユーザーへ提供予定でしたが、安全性の向上、特にユーザーからの不適切なリクエストを検出して拒否する能力の改善、全般的なユーザー体験の向上、今後多数のユーザーに提供するうえでインフラ側の準備といったことを理由に延期していました。

OpenAIによると、安全性への取り組みや改善は、社外の100名以上のレッドチームによる45言語によるテスト、プリセットの4種以外の音声では喋らない、暴力的な内容や著作権保護されたコンテンツについての出力をブロックするガードレールの実装など。

(レッドチームはセキュリティ向上のため攻撃やハックを試みて脆弱性を発見する役割、とその従事者のこと)。

延期を経て始まったアルファテストは、ChatGPT Plus加入者のうち少数が対象。選ばれた場合は登録メールアドレスに案内が届くほか、モバイルアプリのChatGPTにもAdvanced Voice Mode について知らせる画面が表示されます。

段階的に対象者を拡大し、秋にはすべてのChatGPT Plus 加入者がAdvanced Voice Mode を利用可能になる見込み。

なお、会話と並んで大きな反響を呼んだ映像や画面共有への対応、つまりカメラでリアルタイムの映像を見せたり、画面に表示された内容を ChatGPT に共有してリアルタイムに質問したり会話する機能については、単に「今後提供」のままのステータスです。

![Cardill iPhone16 充電器 タイプc 充電器 type-c 20W PD 急速充電器 [正規MFi認証品/PSE認証済み] USB C-C 充電ケーブル 2M付き Type C 充電器 USB-C コンセント スマホ充電器 電源アダプター タイプC アイフォン 充電器 iPhone16/15/Pro/max/iPad Pro/AirPods その他USB-C機器対応 image](https://m.media-amazon.com/images/I/31w8qLOgZlL._SL160_.jpg)