Luma AIの「Dream Machine」といえば、Sora世代(OpenAIがまだ公開していないのにこういうのは変なのですが)の動画生成AIとして6月中旬に登場して注目を集めました。

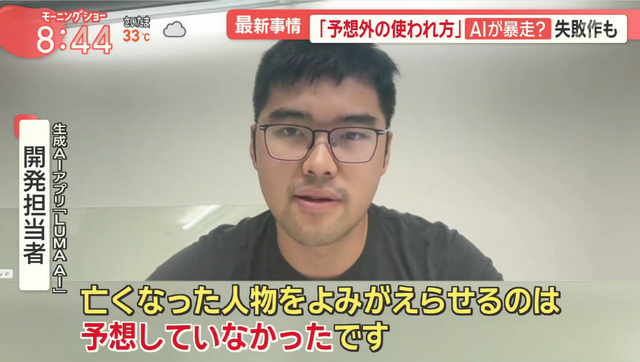

その後は一般層にも広がり、筆者の事例がテレビに取り上げられたりもしました。番組にはLuma AIの開発担当者も登場してコメントしています。

・「亡き妻と交流するための窓」思い出が動き出す…生成AI最新技術 写真→動画が簡単に(テレビ朝日 羽鳥慎一モーニングショー)

Luma Dream Machineは2枚の画像をフレーム補完する機能をつけたりループ機能を付けたりと先進的な部分はありましたが、アジア系の顔が崩れがちだったりといった基本部分の遅れが目立ち、現在ではRunway、KLING、Viduなどに後れをとっている状況です。

そんな状況を挽回しようと、ほぼ5カ月が経過した11月26日、Luma AIはDream Machineに大きな改変を施しました。

まず、静止画生成機能の追加。

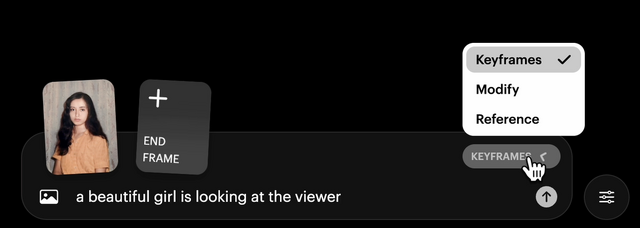

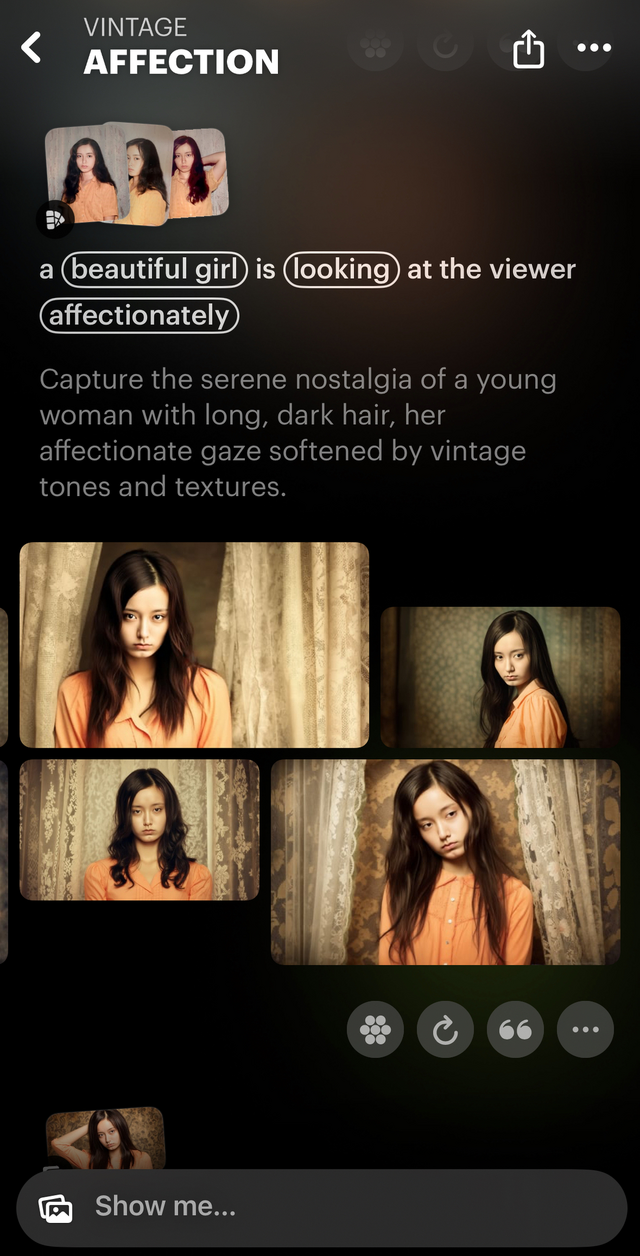

Luma Photonという新しいイメージ生成モデルにより、Text to Imageだけでなく、画像を読み込んで、それを参照して一貫したキャラクター生成を次々に行うことができます。

この参照画像は複数枚でも可能で、近いシーンの画像を集めると、かなり精度の高い画像が生成できます。

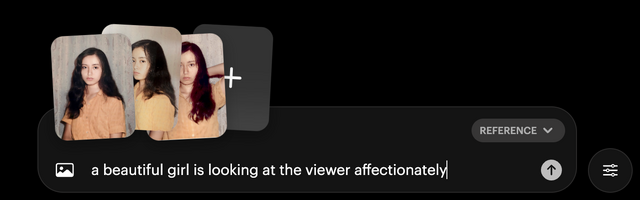

この3枚の写真を参照画像(Reference)として、4枚の画像が生成されます。

「Show more」のボタンを押すと、さらに4枚が追加生成されます。

気に入った画像が生成されたら、その画像の上で「Make video」ボタンを押せば、5秒間のビデオが2本できます。

出来上がったビデオからさらにバリエーション動画を生成できます。これも2本ずつ生成。

さらに4秒ずつ伸ばすこともできます。ただ、後半は崩れがちで、西洋人化現象も以前のまま直っていないようです。

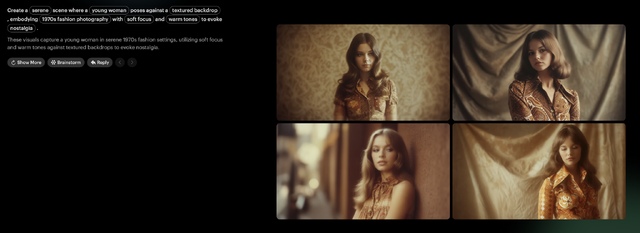

動画生成の基本性能はそれほど進化していないのが残念なところですが、流れるようなユーザーインタフェースは、スクロールバックするだけで、任意の画像を起点として静止画や動画のバリエーションをプロンプト付きで試すことができます。

かなり美しく仕上がりました。試行錯誤してもストレスを感じない、うまく作られたユーザーインタフェースです。

複数枚の参照画像による画像生成とそこからの動画生成もなかなか良いです。

どの時点でも、Replyというコマンドを選択すると、その時点で生成した画像に追加プロンプトを書いて生成することもできます。

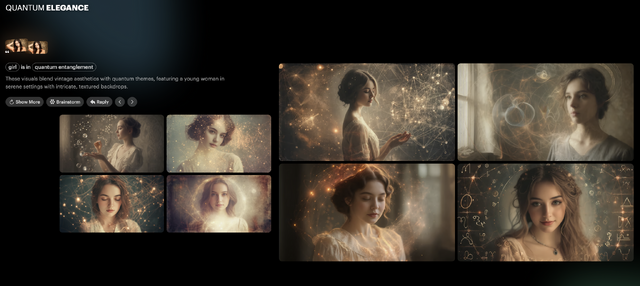

量子もつれというキーワードをプロンプトで追加したら、元画像から完全に離れて知らない女の人になりました。

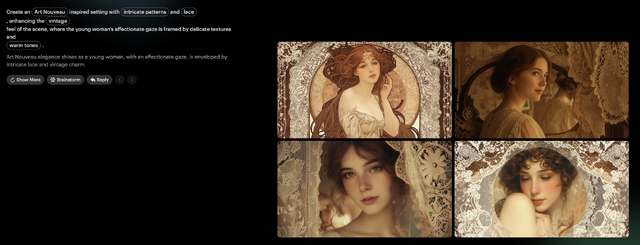

もう1つ、Brainstormという機能も追加されています。現在表示されている画像から、適切なプロンプトのパターンを提案してくれるというもの。元画像からは離れてしまいますが、プロンプト例としては興味深いです。

今回の参照写真からは、東京レトロ、アール・ヌーヴォー、1979年代ファッション誌といったパターンが提案されました。

ユーザーインタフェースとしては秀逸です。筆者はUnlimitedプランなのでいくらでも生成できるのでユーザー体験としてはとても良い感じ。

面白いのは、こうしたプロジェクト単位で、そのページを共有できるところです。

iPhone、Androidアプリが登場して、流れるようなフローで静止画も動画も生成できるのはありがたいことです。

ただ、肝心の動画が以前の問題点(顔や体の崩れ、アジア系の顔が西洋人化する)は放置されているようなので、問題はそこだけですかね……。

RunwayのUnlimitedプランに加入しているので、Dream Machineの複数レファレンス画像生成を活用しながら、動画生成がうまくいかなかったらRunwayで再生成といったワークフローにしようと現時点では考えています。

作例として、妻の3枚の写真からLuma Dream MachineのReferenceで生成した画像→動画で構成したミュージックビデオを用意しました。歌は妻音源とりちゃん[AI] Suno v4ペルソナです。

![【DL版】【初期費用3,300円が無料 ※1契約者1回線/年に限り】IIJmioえらべるSIMカード エントリーパッケージ 月額利用(音声SIM/SMS)[ドコモ・au回線]・(データ/eSIM/プリペイド)[ドコモ回線]IM-B327 image](https://m.media-amazon.com/images/I/51sZVFzAH1L._SL160_.jpg)