米・ラスベガスで開催中の、Adobeの技術イベント「Adobe Summit 2023」へと、取材に来ている。理由は、この場で同社がジェネレーティブAIへの対応を発表するためだ。

▲Adobe Summit 2023は、ラスベガスで開催。コロナ禍を経て久々の、ラスベガスでのリアル開催

大手企業のジェネレーティブAI対策は、驚くべき速さで進んでいる。スタートアップの対応も、メディア側の考察も置き去りになるくらい、矢継ぎ早に施策が出てくる。

そんな時代だと思えば、Adobeの動きに意外性はない。

とはいえ、「なぜAdobe MAXではなくSummitでの発表なのか」を考えると、Adobeの戦略の意味がわかってくる。

Adobe Fireflyの2つの軸

今回Adobeは、ジェネレーティブAIを複数発表している。

1つは「Adobe Firefly」。ジェネレーティブAIと言われてすぐに思い出す、「入力欄があってプロンプトを入れてコンテンツを生成する」タイプのものだ。3月21日からプライベートテストの募集が開始されている。

Adobe Summit初日の基調講演で、「Adobe Firefly」を発表

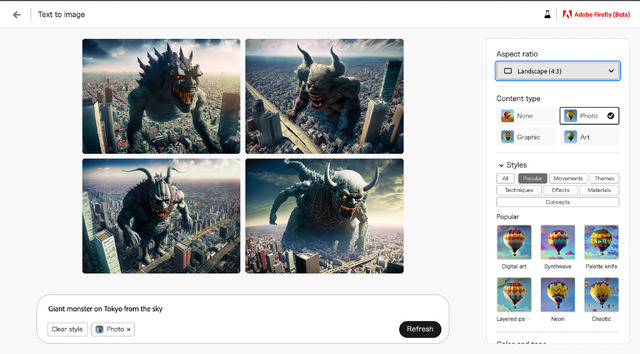

現状では「テキストでの画像生成」と「テキストから文字エフェクトの生成」が主軸。実際に使ってみると「こんな感じか」と、多少拍子抜けする部分もある。クローズドベータ版は英語のみが対象で、日本語に対応していない。ChatGPTなどに慣れた身からすると、ここからも「まだまだ開発途上」というイメージを持つ。

▲Adobe Fireflyのプライベートベータ版をテスト。画像生成は、他のジェネレーティブAIに近い機能。現状英語のみの対応

だが、本質は品質にはない。品質はこれから上げていけるものだ。

今回公開された内容には、2つの軸がある。

第一に、企業が安心して使える基盤を整えることだ。

Adobe Fireflyは学習ソースとして、著作権が消尽した古いコンテンツと、Adobe Stockに収録された(すなわち、利用権利がはっきりした)コンテンツが使われている。

さらに、権利的にNGであろうキーワードが入力されたとき、それを回避して絵を作る。

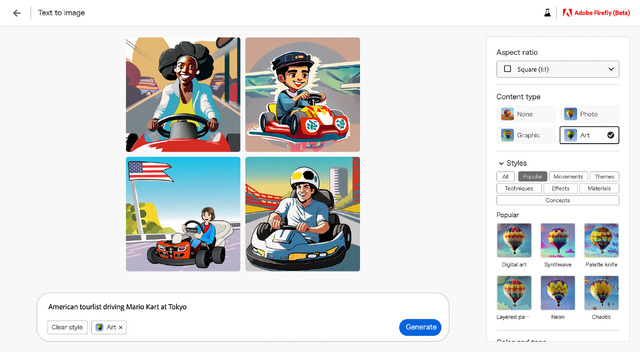

以下の画像は、「東京でマリオカートに乗るアメリカ人旅行客」というプロンプトで描かせた例だ。カートは描かれているが、マリオカートではない。

▲「マリオカート」をキーワードに入れてもマリオは出てこない

また、今後の展開とはなるが、企業が持つロゴや写真などのマテリアルを取り込んでカスタム学習する機能も用意される。企業内でAIにオリジナルコンテンツを作らせる場合、広告などが目的であることも多い。とすると、特定のロゴやマークなどが必要になる場合は多いし、それに合わせたテイストも必要になる。

現状の汎用ジェネレーティブAIで、これらの要素を「ちゃんとする」のは大変だ。カスタム開発すれば可能になる部分もあるが、そのためのコストは馬鹿にならない。

Adobe Fireflyなら、いきなり必要な条件をそろえたサービスが「使える」のが大きい。しかも、今後はPhotoshopなどのAdobe Creative Cloud製品内から、直接呼び出してツールの1つとして使える。

もちろんAdobe Stockが権利的にグレーなコンテンツに侵されていないか、というとそんなことはない。審査をすり抜けたものは存在しており、そこが問題と指摘することはできるだろう。

だが重要なのは、「Adobeが、権利上の問題をなんとかしようとしている」ということだ。他のものを使うよりも、スタート地点のありようとして、企業目線で言えばプラスであるのは間違いない。

デジタルマーケティングで進む「量の爆発」に備える

そして2つ目は、「AIで生成したコンテンツを使う道筋が作られている」ということだ。

われわれは「AIでなにを作るのか」「AIでどんな品質のものができるのか」に注目がちだ。それが大切なことであるのは疑いない。

しかし、さらに俯瞰した目線で言うなら、重要なのは「なんのためにAIで生成するのか」であり、「AIで生成したものをどう使うのか」ということでもある。

今回、Adobe Summitで示されたプレゼン資料の中で、筆者が最も大きなインパクトを受けたのが次の画像だ。

「過去2年間で、コンテンツへのニーズは2倍に増えている。一方で、ここから2年間で、ニーズは5倍に増える」

▲コンテンツへの需要は今後さらに加速する

なぜこうなるのか? それは、デジタルマーケティングに伴って必要となるコンテンツが増えるから……というのが彼らの主張だ。

テレビやチラシなどに、数種類の広告を打てばOK、という時代は過ぎ去っている。広く使われているSNSは多数あり、動画共有サイトも増え、テレビも「コネクテッドTV」になってCMを個人・家庭単位で差し替えられるようになっている。

広告効果を最大化するためには、最適なタイミングで最適な形のコンテンツを作ることが重要だ。多様化し続ける経路に対してちゃんと対応するには、2つのものが必要となってくる。

最適なコンテンツを素早く共有する仕組みと、用意したコンテンツの供給状況やその効果を判断する仕組みだ。

ジェネレーティブAIでは、その両方に対応できる。だからAdobeは、Fireflyだけでなくその上位概念として、同社のAIブランド「Adobe Sensei」全体をジェネレーティブAI対応した「Adobe Sensei Gen AI」も同時に発表している。

前者は「製作スピードの加速」で対応できるし、後者は「管理システムへのAI導入と、ジェネレーティブAIでのコミュニケーション」で可能になる。

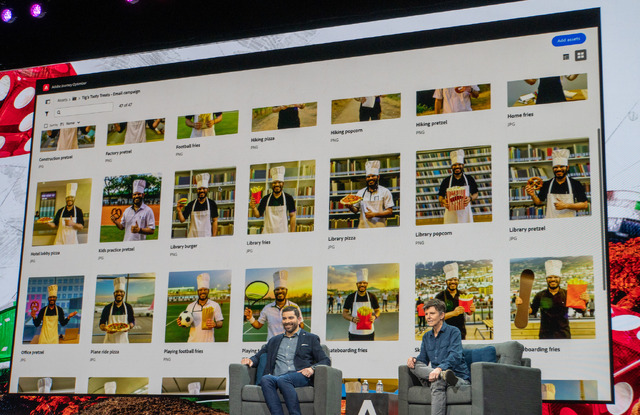

以下は、Adobeが開発中の技術をチラ見せする「Sneaks」で公開した「Project Limitless Options」という技術だ。

これはジェネレーティブAIを使い、コンテンツに合った画像を無限に生成するものだ。扱う食材に合わせて登場人物の服や背景、ポーズを作り変える。コアとなるコンテンツはちゃんと自分で用意した上で、それを「無数のシチュエーションに合わせる」ことは十分に可能なのだ。

▲ウェブサイトによくある「すしざんまい」的なポーズだが、その色合いも広告ツールと連動して変更

▲実は色合いどころか、ポーズ自体や背景、持っている料理まで自由に組み合わせてバリエーションが生成される

Adobeはクリエイティブツールの会社であると同時に、デジタルマーケティングツールの会社でもあり、すなわち「両方できる」会社だ。

だから、デジタルマーケティング向けのイベントであるAdobe SummitでジェネレーティブAIを公開し、それを使って「多様化するマーケティングへの備え」を……という話になるのである。

「Adobeがうまく、そういうシナリオを書いたってことでしょう?」

ごもっとも。確かにそうなのだ。

だが、「AIがコンテンツを生成するとはどういうことか」を掘り下げたとき、速度とバリエーションに落ち着くのはある意味必然だ。

1枚のハイクオリティな作品を作るなら、(今のところ)AIは人間に敵わない。AIのサポートを受けて人間が作るのが論理的だ。

一方で、AIが生み出すものをあくまで素材として考え、それを活かしてビジネスを加速すると考えるなら、AdobeがSummitで描いたシナリオは、極めて現実的で説得力のあるものなのである。