最近AnimateDiffというAI動画手法がすごいと各所で注目されています。

テクノエッジで連載している生成AIウィークリーで7月17日に取り上げているのですが、すぐにいろんなところで実装され、Stable Diffusion WebUIで使えるようになり、さらに日本のAI作画サービスであるMemeplexでも利用できるようになりました。

筆者も話題になった直後から試そうとしていたのですが、自分ではうまくいかず悶々としていたところ、Memeplexでできるようになったので、そのインプレッションをお届けします。

AnimateDiffの基本的な動作は、静止画を作成できるAI作画モデルを使って、一貫性のある短いアニメーションGIFを生成するというもの。Stable Diffusion 1.5、2.0といった標準的なものだけでなく、その上にカスタム学習(ファインチューニング)したモデルにも対応できるというのが特徴です。同様の技術としては「Tune-A-Video」があったのですが、一貫性が乏しかったために使いどころがなかなか難しいものでした。

筆者は現在、MemeplexとStable Diffusion WebUI上に、妻の写真を学習させたAIモデル(Checkpoint)を作成して使っていて「異世界とりちゃん」という名の下に日々、画像を生成しています。その一環で動画生成もやってます。

Tune-A-Videoベースの動画は2月に試しています。使い方によってはこれもいいのですが、動きはそんなに激しくなくていいんだよ、と。

では、Memeplex版AnimateDiffを試してみます。

Memeplex版AnimateDiffはすごく簡単

Memeplexは基本無料なクラウドサービスなのですが、有料会員になると、カスタムモデル作成が可能になり、毎月もらえるポイントを消費することで、作成の優先権をもらえます。さらに、今回はカスタムモデルでの動画生成も可能となっています。無料枠でもポイントを貯める(静止画生成で毎日ポイントがもらえる)ことで、AnimateDiff生成ができるので、まずは試してみるといいでしょう。

使えるAIモデルには制限があります。通常のSD(Stable Diffusion)や派生モデル全てが使えるわけではなく、西川和久さんの連載でも定評のあるBRAV5(Beautiful Realistic Asians Version 5)と、以前インタビューした852話さんが作成したイラスト専用モデルSDHK、そしてこの2つをベースにしたカスタム学習モデルだけが利用できます。

筆者はBRAV5をベースに妻の写真を学習させたモデルがあるのでこれを使います。

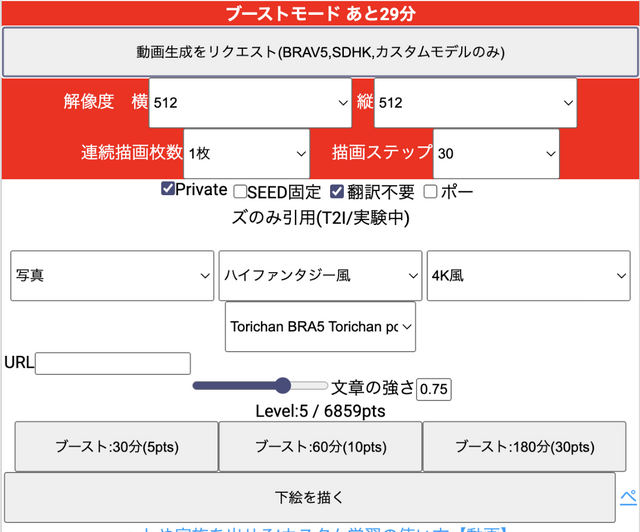

やり方は、まず5ポイント使ってブースト。これで30分使い放題の枠がもらえます。静止画の場合には、ここで画像サイズやステップ数などの属性変更をするのですが、AnimateDiffで動画を作成するための「動画生成をリクエスト」ボタンが表示されるようになります。

▲ブーストモードにすると、「動画生成をリクエスト」ボタンが表示される

プロンプトを入れるとしばらく(数分)して結果が表示されます。静止画より時間はかかりますが、上がってくるのを待たなくても数回同じプロンプトで生成ボタンを押せば、キューに入って後で生成されます。動画は静止画よりさらにガチャ要素が強いので、何度も回す(押す)必要があります。

最初はこんな動きが激しいものでしたが、何度かやるうちにコツが掴めてきて、比較的良いアニメーションができるようになりました。

顔はアップにしておくと動きが少なくてよい(プロンプトにはface closeupなどと入れる)

背景はごちゃごちゃしたり物体が多いと移動感が出る(上の作例ではin the classroomとかin high school laboratoryとか)

服もどんどん入れ替わってしまうので、種類や色は指定しておいた方がよい(作例では指定していないけど、yellow shirtとか)

といったところが個人的なポイントでした。

動画を試すことで、静止画とはまた違ったインスピレーションが湧いてきます。ちょうどいい具合に、8月末から第二回AIアートグランプリが開かれます。

筆者が参加した第一回ではまだ動画を作成するための技術は数えるほどしかなく、自分の作品でも静止画をトランジションするだけのことしかできませんでした(実際にはリップシンクするサービスであるD-IDは昨年12月時点でサービスインしていましたが自分はその存在に気づいていなかった)。動画作品をエントリーされた方々も動きをつけるために独自の工夫をされていました。

それに対して、今回はRunway Gen-2、KaiberといったプロプライエタリAI動画サービス、さらには今回のAnimateDiffのような優れたオープンソース動画技術が出てきています。第二回ではどんな作品がエントリーするのでしょうか。今からワクワクしています。

筆者のライフワークである、AIで生成による妻の歌声と組み合わせて制作するミュージックビデオも、「この絵と動きができるのならこの曲をやりたい」とやる気が爆上げしているところです。

下のアニメーションとか、だいぶ自然に動いてくれていて、いくらでもAIガチャを回せる気がします。

▲背景の動きや服のバリエーションが少なくなるようなプロンプトにしてみた

▲同じプロンプトで生成した静止画