Inter BEE 2023を取材したのは11月中旬の話になるが、技術トレンドというよりは未来へのシナリオに近いネタがあるので、ここで書いておきたい。

※この記事は、毎週月曜日に配信されているメールマガジン『小寺・西田の「マンデーランチビュッフェ」』から、一部を転載したものです。今回の記事は2023年11月27日に配信されたものです。メールマガジン購読(月額660円・税込)の申し込みはこちらから。コンテンツを追加したnote版『小寺・西田のコラムビュッフェ』(月額980円・税込)もあります。

コンプライアンス強化の裏で活躍するAI技術

昨今はテレビ番組もコンプライアンスが非常に厳しくなり、特に番組と無関係なものや人の写り込みは、極力ボカシを入れるようになっている。これが1人2人ならまだしも、街の雑踏を手持ちカメラが歩くようなシーンでのボカシとなると、とたんに難易度が上がる。従来の手作業による追っかけでは、2分程度のシーンでも、ボカシを入れるだけで5時間ぐらいかかるという。

そもそもボカシの付加は、生産的な作業ではない。こうした非クリエイティブな作業のために編集者は5時間も拘束され、制作会社は5時間分の編集費を払わなければならないわけで、番組制作費を圧迫していた。

そこで2年ほど前から、AIを使った画像解析をベースに自動でボカシを入れられないかというトライアルが続いていた。昨年筆者は新型コロナウイルス感染のためにInter BEEを取材できていないので、ちょうどこの辺が見逃していたトレンドである。

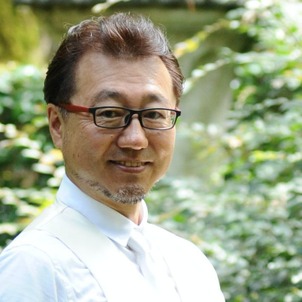

Vuenceが開発した「MetaVu」は、ボカシ専用のツールだ。ボカシを入れたいシーンを切り出してVetaVuへ読み込ませ、顔認識技術を使って顔の位置を特定し、そこにボカシをかけるところからスタートした。

▲Vuenceのぼかし専用ツール「MetaVu」

今では多くの現場の声をフィードバックした結果、人物の顔が隠れても追跡できたり、ナンバープレートのようなものもピンポイントでボカシが入れられるようになった。

また人が画面外からフレームインしてくるような場合や、顔がわからないほど遠くへ行った場合に突然ボカシが現われたり消えたりする違和感を押さえるため、ボカシをフェードイン・アウトできるようになった。

さらに、企業の看板など文字をぼかしても配色でわかるようなもの、例えばセブンイレブンの店舗外装のようなものに対応するため、ボカシをモノクロにするという機能も追加されている。

トラッキング機能も追加され、特定の人物に矢印を付けて追従させると行ったこともできる。すでにフジテレビなどで導入されており、成果を上げているという。

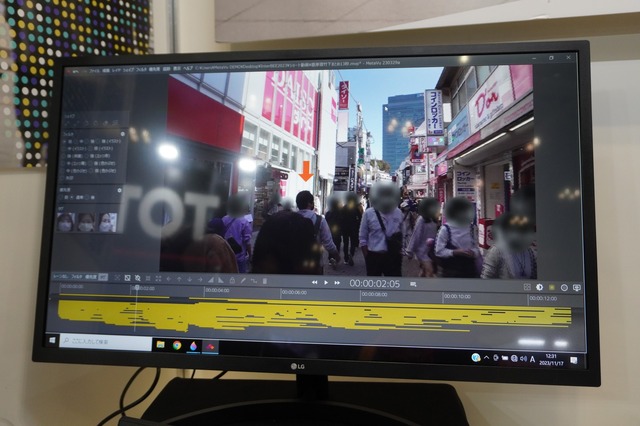

モザイク入れのニーズはなにも逮捕の瞬間24時的なドキュメンタリーだけに使われるわけではない。選挙期間中はニュース取材中に写り込んだ選挙ポスターなども隠さなければならず、特に報道番組が多いNHKではポストプロダクション並みの能力を持つ編集システムが少ないので、ボカシ入れの多さが課題になっていた。

そこでNHKに大量納入されているさくら映機の編集システム「Prunus」用のボカシ入れプラグインを2年前から開発、1年前から現場投入しているという。こちらもAIを使って画面内の対象物を検出、1フレーム単位でトレースしてボカシを入れる。

▲NHKもPrunus専用プラグインを開発

一応NHK専用ではなく外販もするとは言うが、Prunusでしか動かないため、動作できるマシンはかなり限られる。実際にはNHK以外に導入先はないだろう。

上記の2例はローカルで動くシステムだが、日本テレビが開発中のAfter Effects用プラグイン「BlurOn」は、プラグインながらAI解析はクラウドへデータをアップロードして演算し、座標データを返してくるというアプローチをとっている。この方式であれば、クラウド側AIの能力が上がれば、ソフトウェアのアップデータなどを配付することなく利用者全員がすぐに恩恵を受けられるというメリットがある。

現時点では録画ファイルを食わせて処理させるスタイルだが、リアルタイム動画解析によるボカシ入れも開発中だという。これが実現すれば、生放送の報道番組の中継業務などでも対応できるようになる。現場中継でカメラに写りたがる子供やちょっとどうかしている大人がいるわけだが、ああしたものも排除できる。

▲日本テレビで開発中のライブ映像にボカシを入れるツール

また現在開発中の機能として、NTTデータと共同開発したAI技術により、グリーンバックなしの普通の映像から人物のマスクを生成するという技術を展示した。人の輪郭はもちろん、顔のパーツも分けて検出できる。

▲特殊な背景なしで人物を切り出すAIツール

これにより、背景を別のものに差し替えると行った合成も可能になるだけでなく、背景だけカラーグレーディングしたり、あるいは人物の顔色だけ補正したりといったことが可能になる。

▲顔もパーツごとに切り出せる

まだ試作段階だが、こちらもリアルタイム処理を検討しているようで、まだ完全ではないが大まかには抽出できるレベルのデモを見ることができた。AIでは学習を積めば精度が上がることから、来年にはかなりのレベルでライブ処理できるレベルまで行くだろう。

▲リアルタイムでの人物切り出しも参考出展

今の状況がライブでわかる「LIVE VIEW」

すでにAV Watchの記事で、TOMODYの「WRIDGE LIVE」はご紹介したところだが、当日はもう1つ別のサービスの発表もあった。それが「LIVE VIEW」というリアルタイムライブSNSである。ある場所の「今」の状況をライブで共有するというプラットフォームになるという。

▲TOMODYのもう1つのサービス「LIVE VIEW」

とはいえ、プラットフォームは作ってもユーザーがいなければデータが集まらないし、たまたまそこにスマホを持った人がいて動画を回してくれるなどという都合の良いことは起こらないわけだが、このSNSでTOMODYと協業するのが、ミックウェアだ。

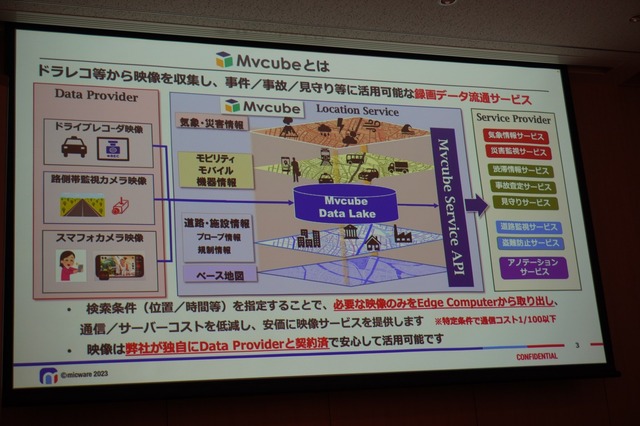

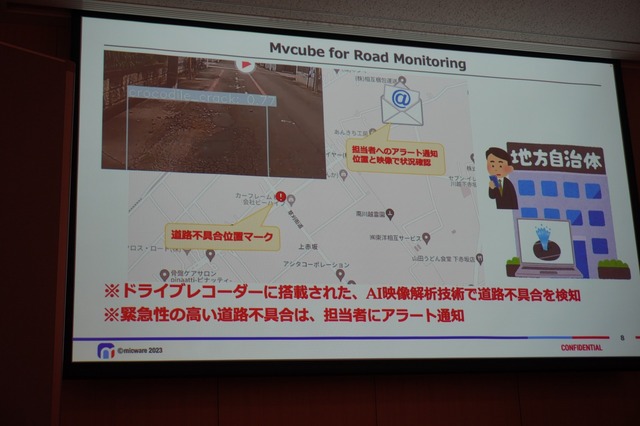

同社は車載プラットフォームソフトウェア開発の大手で、カーナビや通信型ドライブレコーダの中身を作っている。すでに同社で取り組んでいるのが、タクシーに搭載されている通信型ドライブレコーダのデータを共有する「Mvcube」というサービスだ。これは車両の情報をリアルタイムで取得することで、配車の運営管理などに使われているが、さらにドラレコの動画も共有することで、事故対応や運転診断、危険ポイント抽出といったサポートを行なっている。

▲車載ソフトウェア開発大手のミックウェアと協業

▲「Mvcube」サービス概要

▲危険地域の状態も地図と組み合わせて把握

LIVE VIEWにミックウェアのこのドラレコサービスが合体することで、ユーザーが増えなくても見たい場所の情報が動画で手に入るというわけだ。動画データは、ユーザーからリスエスとがあった場所と時間だけがサーバに転送されるので、常時動画が車からリアルタイムで上がり続けるわけではないため、データ効率もいいという。

▲ドラレコ情報とSNSが合わさると…

今でも、これから向かう先の様子をGoogle Mapのストリートビューで先に見ておくみたいなことをする人も多いと思うが、その画像は「今」ではない。そんなに上手いことリアルタイムの動画情報があるかどうかはわからないが、見つかった場合は少なくとも数時間前程度の「今」の様子ではある。

たとえば、暗くなってから子供が自転車で学校から帰るときに、交通状況はどうかなと確認したり、事件事故があればその状況を確認できる。タクシーが隅々まで網羅しているのはやはり都心部ということになるだろうが、これまで特定の事業者だけしか利用していなかった公共交通機関の映像が利用できるとなれば、いろいろ話が違ってくるだろう。路線バスや路面電車のような公共交通機関の映像が手に入れば、確実にわかる路線が確保できる。

おそらくTOMODY自体が母体となってサービス運営するのではなく、どこか大手がサービス運営会社として買ってくれるのを待つという格好だろう。個人が今いる位置情報を共有するサービスはプライバシーやセキュリティ上問題が多いが、公共交通機関の映像が利用できるなら、ストビューのライブ版といった使い方も夢ではなくなる。また定点カメラ等の情報も乗り入れするようになれば、さらにいいだろう。

そしてそこで求められるのが、そこに写り込んでしまった人やナンバープレートなどのプライバシーを確保する「ライブ映像のぼかし付加技術」である。

話が繋がったのがお分かりだろうか。こうした例のように、技術的に繋がるということ、人やサービスが繋がってその先に実現できることは何かというのが、次の時代を占うトレンドではないだろうか。