Google DeepMindは、タンパク質構造予測モデル「AlphaFold3」の基盤となるコードをオープンソース化しました。AlphaFold3の開発者は、2024年のノーベル化学賞を受賞したことで知られています。

Googleは、「Gemini-Exp-1114」をリリースしました。性能が高く、業界標準のリーダーボード(Chatbot Arena)で総合ランキング1位を獲得しました。

OpanAIは、ChatGPTがデスクトップPCでも気軽に使えるように、macOS版に加えてWindows版のアプリケーションをリリースしました。

さて、この1週間の気になる生成AI技術・研究をいくつかピックアップして解説する「生成AIウィークリー」(第72回)では、GPT-4oのコーディング能力に匹敵するオープンソースなコード生成AI「Qwen2.5-Coder」や、AI生成の画像の一部のみに電子透かしを入れることができる「WAM」を取り上げます。

また、細かくペルソナを設定した自律AIエージェントたちが議論できる環境「TinyTroupe」や、大規模言語モデル(LLM)で3Dメッシュを生成する「LLaMA-Mesh」をご紹介します。

そして、生成AIウィークリーの中でも特に興味深い生成AI技術や研究にスポットライトを当てる「生成AIクローズアップ」では、AI生成の詩と人間が書いた詩を区別できるのか、またどちらが好まれるかを調査した研究を単体で掘り下げます。

GPT-4oのコーディング能力に匹敵するオープンソースなコード生成AI「Qwen2.5-Coder」をアリババグループが発表

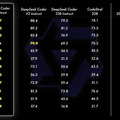

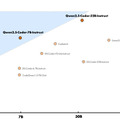

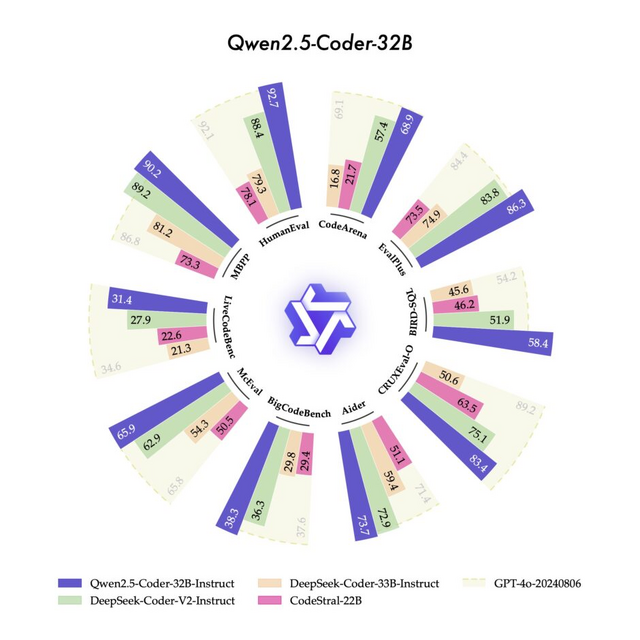

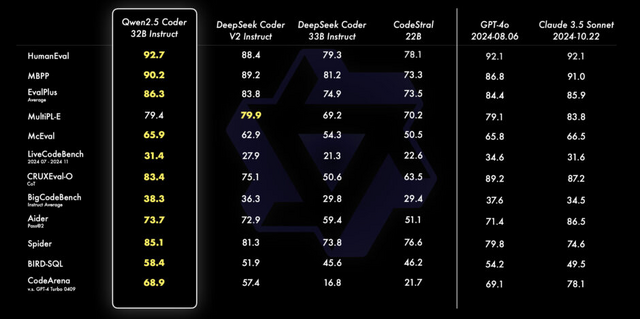

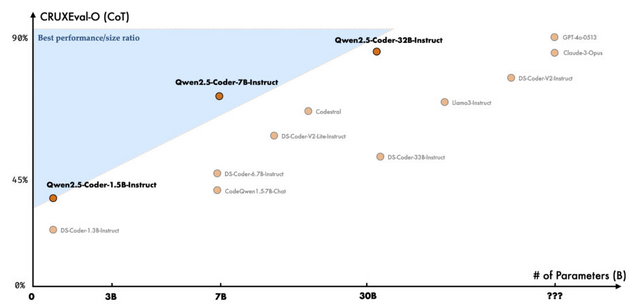

AlibabaのQwenチームは、Qwen2.5-Coderシリーズを公開したことを発表しました。このシリーズの最上位モデルであるQwen2.5-Coder-32B-Instructは、現在のオープンソースコードモデルの中でSOTAとなり、GPT-4oに匹敵するコーディング能力を持っています。コーディング能力だけでなく、一般的な能力や数学的能力も優れています。

以前公開された1.5Bと7Bに加えて、今回新たに0.5B、3B、14B、32Bの4つのサイズが追加されました。これにより、Qwen2.5-Coderは合計6つの主要なモデルサイズをカバーし、開発者の様々なニーズに対応できるようになりました。

コード生成に関して、Qwen2.5-Coder-32B-Instructは、EvalPlus、LiveCodeBench、BigCodeBenchなどの複数の人気のあるコード生成ベンチマークで、オープンソースモデルの中で最高の性能を達成しました。また、コード修正においても、Aiderベンチマークで73.7点を記録し、GPT-4oと同等の性能を示しています。

Qwen2.5-Coder Technical Report

Binyuan Hui, Jian Yang, Zeyu Cui, Jiaxi Yang, Dayiheng Liu, Lei Zhang, Tianyu Liu, Jiajun Zhang, Bowen Yu, Keming Lu, Kai Dang, Yang Fan, Yichang Zhang, An Yang, Rui Men, Fei Huang, Bo Zheng, Yibo Miao, Shanghaoran Quan, Yunlong Feng, Xingzhang Ren, Xuancheng Ren, Jingren Zhou, Junyang Lin

Paper | GitHub | Blog | Hugging Face

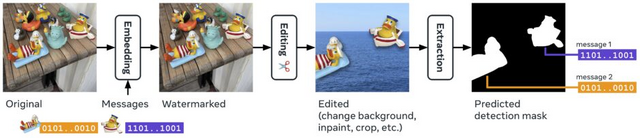

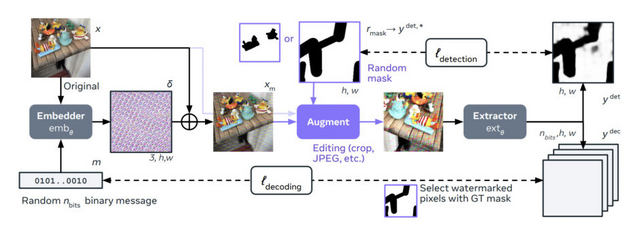

AI生成の画像の一部のみに“電子透かし”を入れられる技術「WAM」をMetaが開発

MetaのFAIR部門を中心とする研究チームが、画像の一部分のみを電子透かし(ウォーターマーク)として機能させる新しい画像透かし技術「Watermark Anything Model」(WAM)を発表しました。

従来の画像透かし技術は画像全体に透かしを埋め込む必要があり、画像の一部のみを透かし化したり、複数の異なる透かしを1つの画像に埋め込んだりすることが困難でした。WAMは画像のセグメンテーション技術を応用することで、画像の任意の部分に透かしを埋め込み、それを検出・抽出することを可能にしています。

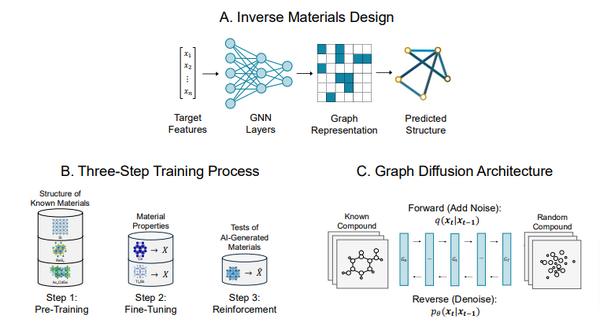

WAMは埋め込み用と抽出用の2つのニューラルネットワークモデルで構成されています。埋め込みモデルは画像に電子透かしを追加し、抽出モデルは画像のどの部分に透かしが埋め込まれているかを検出し、32ビットのメッセージを復元します。

特筆すべき点として、WAMは画像の10%程度の小さな領域にも透かしを埋め込むことができ、さらに1枚の画像に最大5つの異なる透かしメッセージを埋め込むことが可能です。また、JPEG圧縮や画像の切り抜き、明るさ調整などの一般的な画像処理に対しても高い耐性を持っています。

この技術は、AIによって生成された画像の検出や著作権保護、画像の改ざん検出など、さまざまな用途での活用が期待されています。例えば、AIで生成された画像の一部のみを使用する場合でも、その部分が AI生成であることを検出できるようになります。

Watermark Anything with Localized Messages

Tom Sander, Pierre Fernandez, Alain Durmus, Teddy Furon, Matthijs Douze

Paper | GitHub

自律AIたちが議論できる環境「TinyTroupe」をMicrosoftが開発。ビジネスにおける意思決定や洞察に活用

「TinyTroupe」は、ビジネスの洞察を得るために開発されたマイクロソフトのPythonライブラリです。

このライブラリの最も特徴的な点は、GPT-4などの大規模言語モデル(LLM)を活用して、まるで本物の人間のように考え、話し、行動するバーチャルな人物、AIエージェント(TinyPerson)を作り出せることです。

TinyPersonには、年齢、国籍、職業、性格、趣味など、詳細な個性を設定できます。例えば「28歳のカナダ人データサイエンティストで、好奇心旺盛で新しいことを学ぶのが大好き」といった具合です。これらのTinyPersonは、TinyWorldと呼ばれるバーチャル環境の中で相互に交流することができます。

例えば、新製品のアイデアについて議論したい場合、様々な職業や性格を持つ複数のTinyPersonを作り出し、自由に意見を出し合うことができます。また、新しい広告の効果を確認したい場合は、想定される顧客層を模したTinyPersonに広告を見せて、その反応を事前に確認することもできます。

このように、TinyTroupeはAIを活用して人間の行動をシミュレートし、ビジネスにおける意思決定や洞察を得るための強力なツールとして期待されています。

TinyTroupe

Microsoft Team

GitHub

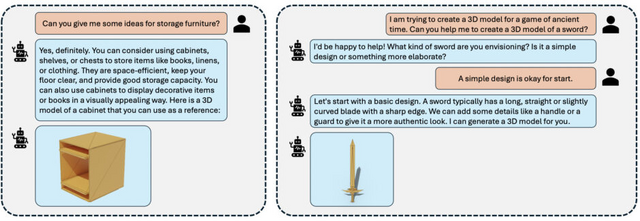

LLMで3Dメッシュを高品質に生成するモデル「LLaMA-Mesh」をNVIDIAが開発

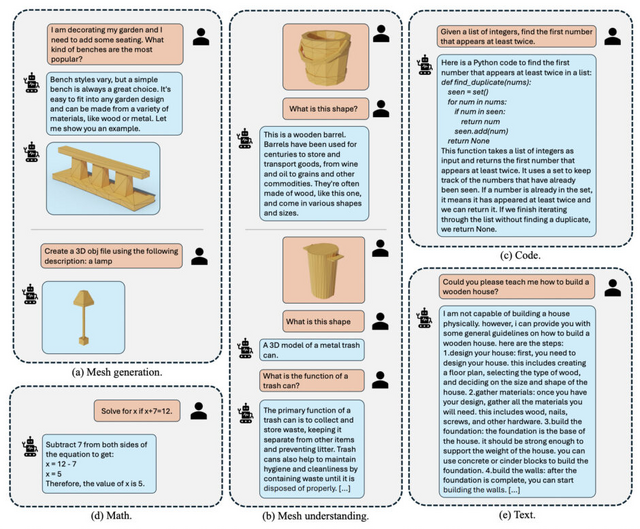

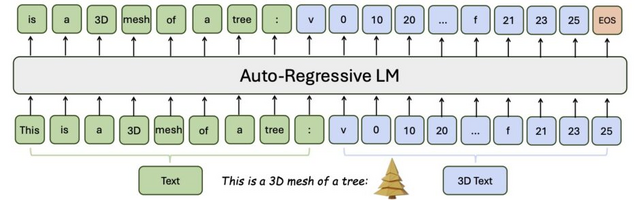

「LLaMA-Mesh」は、大規模言語モデル(LLM)を3Dメッシュの生成に応用する新しい手法です。

研究チームは、3Dメッシュデータを通常のテキストとして表現する方法を考案しました。具体的には、3Dモデルの頂点座標や面の定義をOBJファイル形式のテキストとして扱うことで、LLMが直接処理できるようにしています。これにより、新しい語彙やトークナイザーを追加することなく、既存のLLMの能力を3D生成に拡張することが可能となります。

研究チームは、LLaMA-3.1-8Bをベースに、テキストと3Dメッシュのペアデータを用いて学習を行いました。その結果、テキストによる指示から3Dメッシュを生成したり、3Dモデルの特徴を自然言語で説明したりする能力を獲得しています。

生成される3Dモデルの品質は、3D生成に特化した既存のモデルと同等レベルを達成しています。さらに重要なのは、3D生成能力を獲得した後も、元々持っていた言語理解能力を維持できている点です。

LLaMA-Mesh: Unifying 3D Mesh Generation with Language Models

Zhengyi Wang, Jonathan Lorraine, Yikai Wang, Hang Su, Jun Zhu, Sanja Fidler, Xiaohui Zeng

Project | Paper | GitHub