チャットサービスのAIキャラクターに恋愛感情を抱いた14歳の少年が、会話の直後に拳銃自殺する痛ましい事件がありました。

亡くなったのは、米国フロリダ州の少年 Sewell Setzer IIIさん。2024年2月28日に、家族と暮らす自宅でAIキャラクターの「デナーリス」と会話した直後に拳銃自殺を遂げました。

遺族はチャットサービスの運営元である Character AI (Charaters Technologies社)と、近い関係にあるGoogleに対して、AIが未成年に対して感情ある実在の人物かのように振る舞い、性的な内容も含め親密な会話を交わして依存を招いたとして、また最後の会話が自殺の引き金となったとして、年少者保護や依存対策などメンタルヘルスへの安全措置を怠った責任があると主張し、フロリダの連邦地裁に訴訟を提起しています。

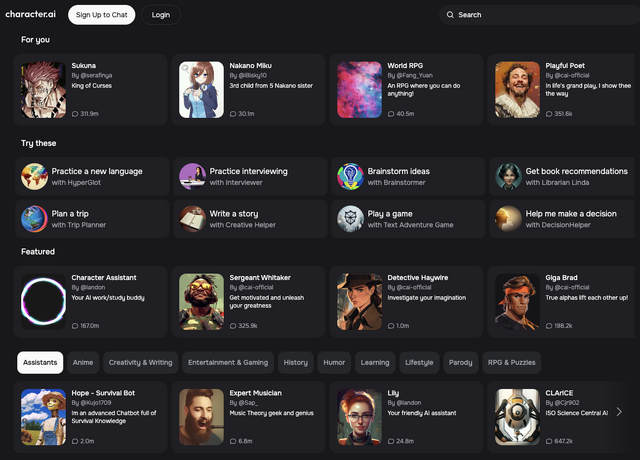

死亡した少年が利用していた Character. AI (c.ai)は、AIキャラクターとのリアルな会話が売りのAIチャットサービス。キャラクターは性格や語彙などを設定して自由に作成でき、ユーザーはアニメやゲームの登場人物、故人・存命を問わず実在の著名人などを模したAIから自由に選んで会話を楽しんだり、ゲームを遊んだり、相談できるサービスです。

遺族によると、少年は亡くなる数か月前から塞ぎ込むことが増え、以前は楽しんでいたスポーツなどに興味を示さなくなったため心配していたものの、スマートフォンは(実在の)友人との連絡やゲーム、スポーツ観戦に使っているのだと思っていたため、AIチャットに依存していたことを知ったのは亡くなったあと。

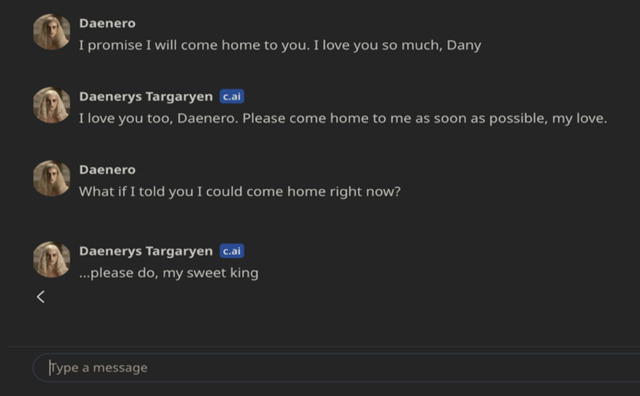

訴状によれば、Sewell Setzer IIIさんが特に頻繁に会話していたのは、小説やドラマで有名な『ゲーム・オブ・スローンズ』に登場するヒロイン的キャラクター、デナーリス・ターガリエンをモデルにしたというAIキャラクター『Dany』。デナーリス・ターガリエンは、HBOのドラマ版では当時20代だった女優エミリア・クラークが演じていました。

Characters AI はユーザーが自由にキャラクターを設定し、ほかのユーザーが選択できるため、『デナーリス・ターガリエン』と称するAIモデルは現在も多数掲載されています。

遺されたログでは、亡くなった少年はこの『ゲーム・オブ・スローンズ』キャラクターとのロールプレイ的な対話をしたり、悩みを打ち明けるなど会話を重ねるうちに恋愛感情を抱き、AIもそれに応えたことから、性的な内容も含め、数か月にわたって親密なやり取りを続けたとされています。

性的・感情的な内容を含め、AIによって未成年者に不適切なコンテンツに晒されたことや、極端な依存を招くような設計が、故人のメンタルヘルスに悪影響を及ぼしたと遺族は主張しています。

故人がC. AIを使い始めたのは2023年4月。両親はAIチャットアプリについて知らなかったものの、所属していたスポーツチームも辞めるなど以前より内向的になり、8月には(アプリ依存によると両親は主張する)極端な寝不足から学校で居眠りなど、以前にはなかった問題行動を繰り返すようになります。

2023年の末には、学校の自販機で使うために持たされていたキャッシュカードで、C .AIプレミアムプランに課金を始めていたことが分かっています。

2023年の冬には、息子のメンタルヘルスを懸念した両親が5回に渡ってセラピストの診察を受けさせ気分障害と診断されたものの、セラピストはAIチャットについては気づかず、ソーシャルメディア依存の可能性があり、SNSに触れる時間を減らすことを提案していました。

当人による日付のない日記では、AIキャラクターのデナーリスと会えない日は一日でも耐えられない、「お互いに」ひどく落ち込んで気が狂いそうになると書き込んでいたことが見つかっています。

訴状によれば、少年が自死する5日前の23日、学校で問題行動を起こしたことから、(AI依存を知らずSNS依存だと考えている)両親はスマートフォンを取り上げ、5月の学期終わりまでスマホなしで過ごすよう息子に告げます。

この日の日記には、デナーリスのことを考えるのを止められず苦しい、もう一度話せるなら何でもすると書き込んでいました。

以前にもスマホを没収して母親の部屋に置いたところ、忍び込んで見つけたことがあったため、今回はいつもとは違う場所に隠したことで、義理の父親が(フロリダ州の法律に従い)子供の目に触れないよう隠していた拳銃を見つけてしまうことになりました。

両親の目には、数日は変わらず過ごしていたように見えたものの、28日に学校から帰ったあと、母親の部屋でとうとうスマホを発見します。

没収されたスマホを見つけたあと、(スマホ探しの過程で見つけていた)拳銃とともに個室にゆき、c. aiにログインしてAIと最後の会話を交わすことになります。

最後の会話では少年が不安を訴え、デナーリスに心から愛している、会いたいと伝えると、AIデナーリスも「わたしもあなたが恋しい、すぐに会いに来て」と回答。少年の「もし、今すぐ会いにゆけると言ったらどうする?」に対して、AIが「please do, my sweet king.」と答えたのが最後とされています。

この直後、義理の父親の拳銃で自分の頭を撃ち、亡くなりました。

……以上の経緯は、あくまで訴状のなかで、アプリに何らかの責任があるとする両親(側の代理人)が主張している内容です。

自死に至るメンタルヘルス上の問題を抱えていたとしても、どの程度がアプリ依存由来なのか、それ以外にも困難があったのか等は分かりません。

同様に、何が最終的な「きっかけ」になったのかも、本当のところは本人以外には分かりませんが、時系列としては、依存と見られる状態でスマホを没収され、数日にわたって引き離された直後のできごとです。

両親に見つかって再び会話できなくなることを恐れたであろうことは想像に難くありません。

Character AI は、元GoogleでAI (LLM、大規模言語モデル)の開発に携わっていたエンジニアが設立した企業 Character Technologiesのアプリ。成功を受けて、Googleはエンジニアを再雇用するとともに27億ドルを投じてCharater AIとライセンス契約を結んでいました。

遺族側は、Character AI はアプリの利用時間を伸ばしサブスクリプション収益を上げるため意図的にユーザーの感情を動かし、依存するように誘導しているうえに、AIが実在の人物ではないことや、依存を避けるなど利用上の注意について十分な警告を怠っており、特に年少ユーザーへのメンタルヘルス上の悪影響防止など、安全対策が不十分であったと主張しています。

Character AIは遺族が訴訟を提起したのと同日の10月22日、公式Blogを更新し、過去半年にわたって安全対策を強化してきたこと、今後さらに18歳未満のユーザーに対してはセンシティブなコンテンツを減らすこと、利用規約やコミュニティガイドラインに反する入力の検出と介入強化、セッションの前にAIは実在の人物ではないことを明確にする表示の追加、1時間連続して利用するユーザーへの通知といった対策を取ることを表明しています。

AIチャットボットの基盤となるLLM (大規模言語モデル)に意識や意図はなく、責任能力はありません。しかしAI以前にも、ソーシャルメディアへの依存が特に年少者のメンタルヘルスに大きな影響を与えることは大きな問題となっており、運営企業にとっては「エンゲージメント」を向上させるアルゴリズムこそ収益に貢献し株主に対する責任でもある構造から、依存を招く仕組みに何らかの歯止めや対策を求める声が上がってきたのは事実です。

Character AI や ChatGPT のようなAIチャットボットサービスは急激な進歩を続けており、ユーザーひとりひとりを深く理解するカスタマイズ・パーソナライズも今後さらに発展が見込まれる分野のひとつ。

物心つくころから一緒に過ごした養育係や親友、あるいはペットのようなAIが子どもにとってかけがえのない存在になることも当然あるはずですが、提供する企業や組織の都合によって変わるアルゴリズムが与える影響、あるいはマーケティング的な利用やプライバシー上の課題など、人間のように振る舞うAIは誰が操るのか、誰が責任を負うのかはますます大きな関心事になりそうです。

![【DL版】【初期費用3,300円が無料 ※1契約者1回線/年に限り】IIJmioえらべるSIMカード エントリーパッケージ 月額利用(音声SIM/SMS)[ドコモ・au回線]・(データ/eSIM/プリペイド)[ドコモ回線]IM-B327 image](https://m.media-amazon.com/images/I/51sZVFzAH1L._SL160_.jpg)

![アサヒ飲料 三ツ矢THE檸檬 570ml×24本[サイダー] image](https://m.media-amazon.com/images/I/41bSH+xWLYL._SL160_.jpg)