MidjourneyやFlux、Stable Diffusionなどの実力派の画像生成AIをHuggingFaceのリーダーボード(Text-to-Image Benchmark)で抜いて1位を獲得した「Recraft V3」という画像生成AIが登場しました。

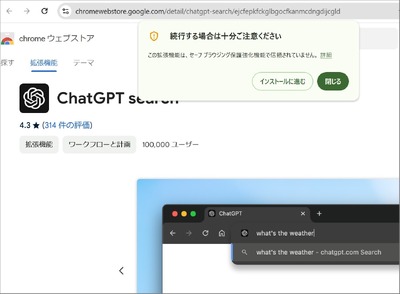

OpenAIは、ChatGPTに新しい検索機能を搭載したことを発表しました。これにより、ユーザーはリアルタイムの情報を含む回答を、関連するウェブソースへのリンク付きで得られるようになります。

動画生成AI「Gen-3 Alpha Turbo」において、シーン内の方向や強度を変えられるカメラコントロール機能が追加されました。

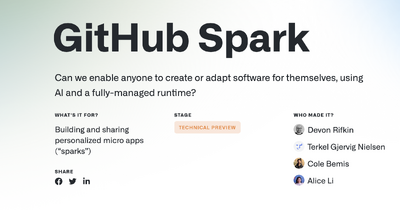

GitHubが自然言語によるプロンプト入力からアプリケーションを生成する「GitHub Spark」を発表しました。

さて、この1週間の気になる生成AI技術・研究をいくつかピックアップして解説する「生成AIウィークリー」(第70回)では、劣化した写真を修復するAIモデル「DreamClear」や、新しいText-to-Speechモデル「MaskGCT」を取り上げます。

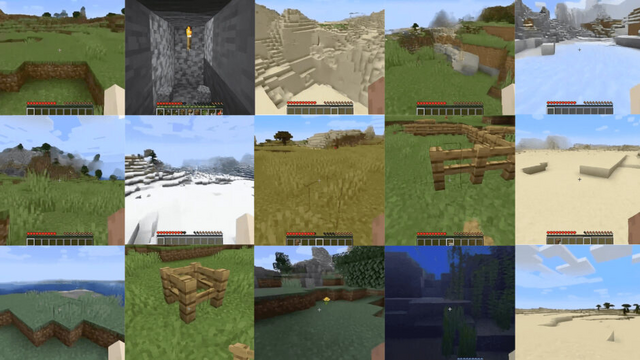

また、Minecraftを舞台に500体のAIエージェントが自律生活すればどうなるかをシミュレーションした研究や、ユーザー操作に応じてAIがゲームプレイをリアルタイム生成するオープンワールドゲーム「Oasis」をご紹介します。

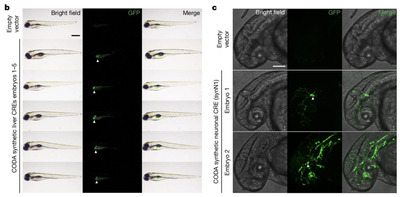

そして、生成AIウィークリーの中でも特に興味深い生成AI技術や研究にスポットライトを当てる「生成AIクローズアップ」では、自然界に存在しないDNA配列を生成できるAIシステムを提案した研究を単体で掘り下げます。

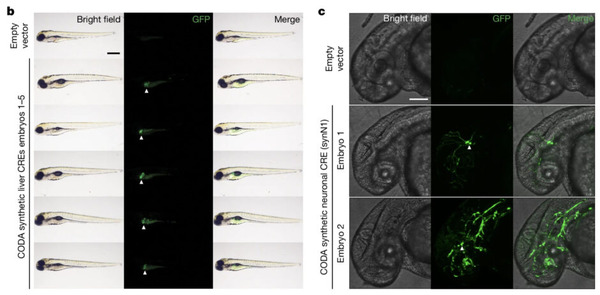

音声サンプルをもとにテキストを読み上げるゼロショット音声合成AI「MaskGCT」、音質を保持したまま多言語への変換も可能

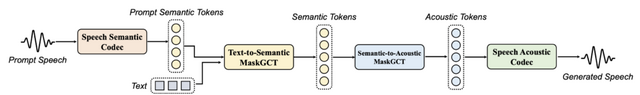

「MaskGCT」は、音声サンプルをもとにテキストを自然な音声に変換できるゼロショットAIシステム(Text-to-Speech)です。このシステムは、テキストから自然な音声を生成する際に、話者の声質や感情表現を高い精度で再現することができます。

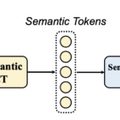

MaskGCTは、音声の特徴を2段階で処理する方式を採用しています。まず1段階目で入力されたテキストから音声の意味的な特徴を抽出し、2段階目でその特徴を基に実際の音声を生成します。これにより、従来のシステムで必要とされていた音声とテキストの詳細な対応付けや、音素レベルでの継続時間予測が不要になりました。

実験では、英語と中国語を合わせて10万時間の音声データを用いて学習を行い、システムの性能を評価しました。その結果、生成された音声は人間の声に匹敵する自然さと類似性を達成し、特に話者の声質の再現性において優れた性能を示しました。

さらにMaskGCTは、音声の翻訳や感情表現の制御、声質変換など、様々な応用が可能であることも実証されました。例えば、ある言語の音声を別の言語に翻訳する際に、元の話者の声質や話し方の特徴を保持したまま変換することができます。

MaskGCT: Zero-Shot Text-to-Speech with Masked Generative Codec Transformer

Yuancheng Wang, Haoyue Zhan, Liwei Liu, Ruihong Zeng, Haotian Guo, Jiachen Zheng, Qiang Zhang, Xueyao Zhang, Shunsi Zhang, Zhizheng Wu

Project | Paper | GitHub | Hugging Face

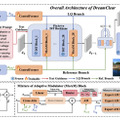

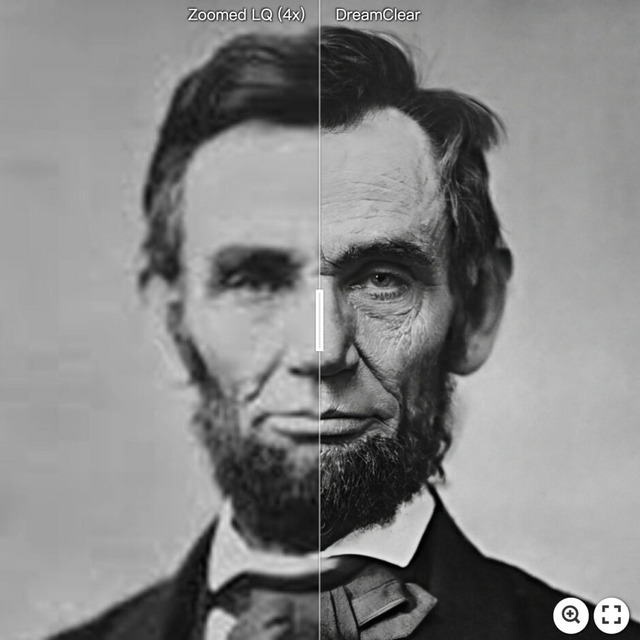

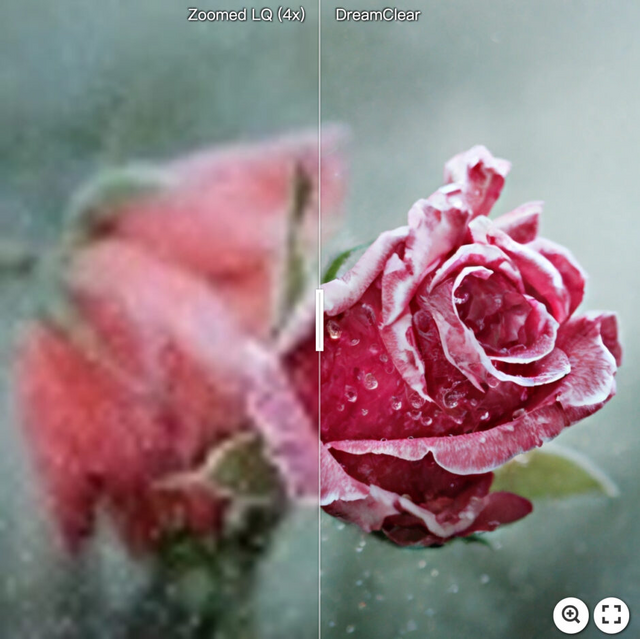

劣化した写真を修復するAIモデル「DreamClear」、プライバシーに配慮した画像データセットを活用

劣化した写真をきれいに修復するAIモデル「DreamClear」と、そのためのプライバシー配慮型データセット作成パイプラインを発表しました。

画像修復の課題に対処するため、研究チームは2つの重要な技術を開発しました。

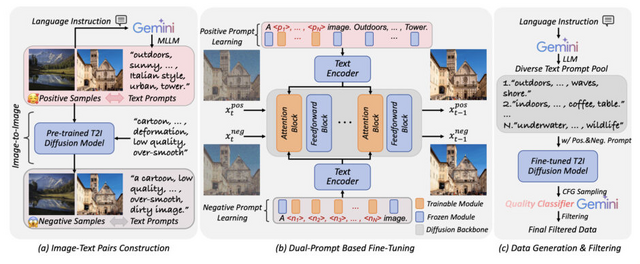

1つ目は「GenIR」と呼ばれる自動データ生成パイプラインです。これは事前学習された画像生成モデルと、Gemini-1.5-Proなどの大規模言語モデルを組み合わせ、プライバシーに配慮しながら100万枚の高解像度(2040×1356ピクセル)画像データセットを作成します。このアプローチにより、ウェブからの画像収集に伴う著作権問題や個人情報の懸念を回避しつつ、効率的に大規模データセットを構築することが可能になりました。

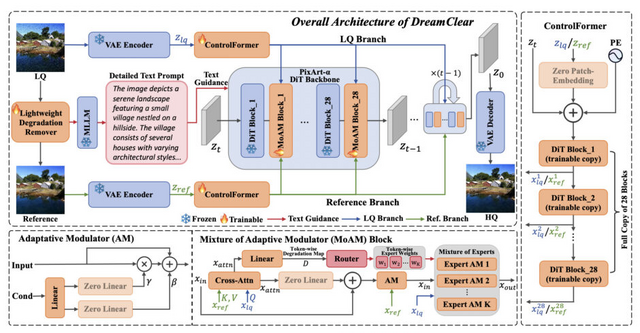

2つ目は「DreamClear」という画像修復モデルです。これは最新の拡散トランスフォーマー(DiT)をベースに、劣化画像と参照画像の2つの入力を処理する二重構造を採用。

さらに、画像の劣化状態を細かく分析し、それに応じて複数の修復エキスパートを動的に組み合わせる「Mixture of Adaptive Modulator」(MoAM)という機構を導入しました。また、マルチモーダル大規模言語モデルを活用して生成した詳細な画像説明文を用いることで、より自然な修復を実現しています。

実験では、合成データと実世界のデータの両方で、DreamClearが既存の最先端手法を上回る性能を示しました。特に、物体検出やインスタンスセグメンテーション、セマンティックセグメンテーションなどの画像認識タスクにおいても最高性能を達成しました。

DreamClear: High-Capacity Real-World Image Restoration with Privacy-Safe Dataset Curation

Yuang Ai, Xiaoqiang Zhou, Huaibo Huang, Xiaotian Han, Zhengyu Chen, Quanzeng You, Hongxia Yang

Paper | GitHub

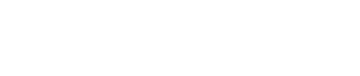

マインクラフトに500体の自律AIが住むとどうなる? AIエージェント文明構築プロジェクト「Project Sid」

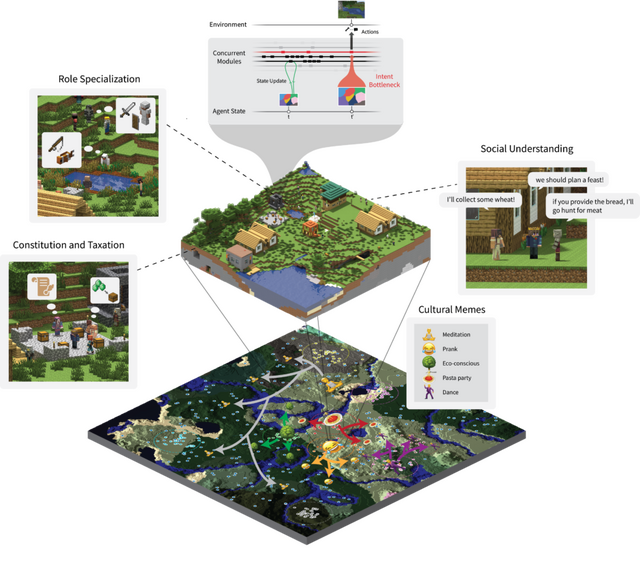

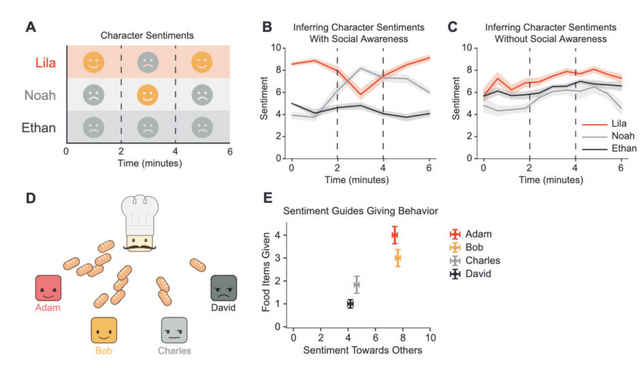

「Project Sid」は、AIエージェントの文明構築に向けたプロジェクトです。この研究では、10から1000以上のAIエージェントが社会の中でどのように振る舞い、進歩していくかを検証しています。ただし、サーバーの制約により、主な分析は500体までの実験結果に基づいています。

研究チームは、まず「PIANO」(Parallel Information Aggregation via Neural Orchestration)というアーキテクチャを開発しました。このシステムにより、エージェントは人間や他のエージェントとリアルタイムでやり取りしながら、複数の出力を一貫性を保って処理できるようになります。

実験は主にMinecraftの環境で行われました。個々のエージェントは30分程度のプレイで平均17種類のユニークなアイテムを獲得し、一部のエージェントは経験豊富な人間プレイヤー並みの40アイテムを収集できました。また、エージェントたちは農民、鉱夫、エンジニア、警備員、探検家、鍛冶屋などの職業に自律的に分化し、それぞれの役割に応じた具体的な行動パターンを示しました。

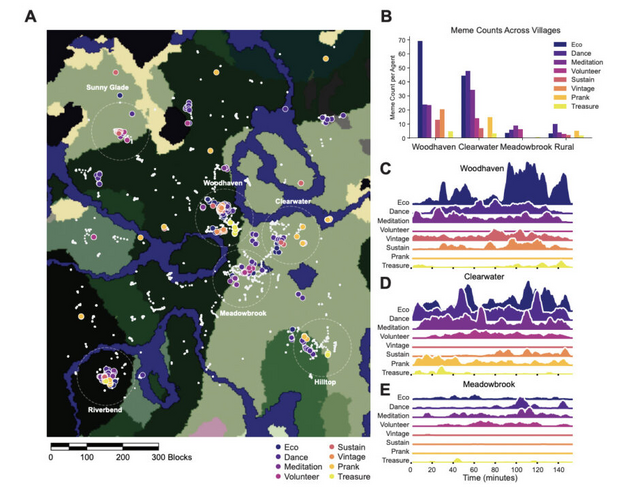

社会システムの面では、エージェントたちは税制度を実施し、民主的な制度改正プロセスを確立。集団のルールを遵守し、必要に応じて変更を提案する能力も示しました。500体規模の実験では、6つの主要な町(各町に約33体)と地方部(約300体)に分かれて居住し、環境保護、ダンス、瞑想などの文化的ミームを自発的に生成。さらに、宗教の伝播過程も観察されました。

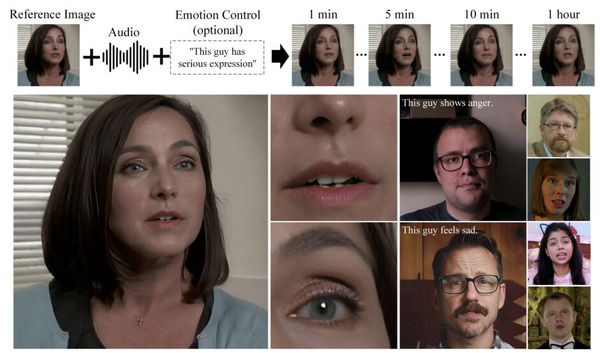

ユーザーのプレイ操作に応じ、AIがリアルタイム生成するオープンワールドゲーム「Oasis」はゲームエンジンを使わない

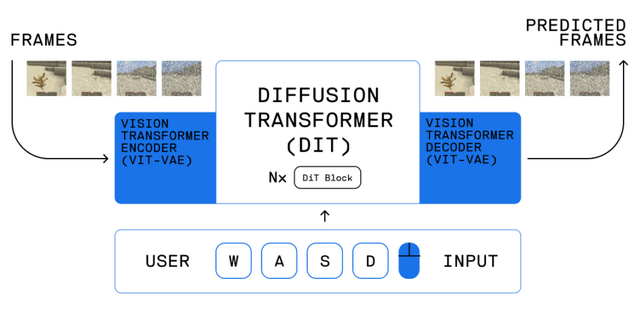

AIチームの「Decart」と「Etched」は、AIによって生成されるリアルタイムのオープンワールドゲーム「Oasis」を発表しました。Oasisは、ゲームエンジンを使用せず、Transformerベースの基礎モデルのみで動作するシステムです。

Oasisは、キーボード入力に応じてゲームプレイをリアルタイムで生成し、物理演算、ゲームルール、グラフィックスなどを処理します。プレイヤーは移動、ジャンプ、アイテム収集、ブロックの破壊などの操作が可能です。

このモデルは、空間オートエンコーダーと潜在拡散バックボーンという2つの要素で構成されており、どちらもTransformerベースのアーキテクチャを採用しています。従来の動画生成AIモデルが1秒の映像生成に10-20秒かかるのに対し、Oasisは毎秒20フレームのリアルタイム出力を実現します。

機能面では、建築、照明、インベントリ管理、オブジェクト認識など、複雑なゲームメカニクスを理解し処理することができます。また、様々な設定、場所、オブジェクトを出力できる多様性を持ち、新しいマップ、ゲーム機能、改造などへの適用可能性を示しています。

現在、500Mパラメータのモデルのコードと重みが公開されており、ローカルで実行可能です。また、より大きなチェックポイントを使用したライブデモも公開されています。

Oasis: A Universe in a Transformer

GitHub | Blog | Hugging Face | Live Demo