先週の土曜日は、東京外国語大学の軽音サークルGMC(Gaigo Music Circle)のOB・OGによる忘年会ライブがありました。そこで筆者も演奏したのですが、今年はAIリアルタイムボイチェンと、AIを使ったミュージックビデオを披露しました。

筆者の現役時代は1980年前後なので最も若いメンバーが59歳という、高齢化社会を象徴するようなロックライブでしたが、とても楽しかったです。

そこでのAI技術の使用感と反応について、軽くまとめてみます。

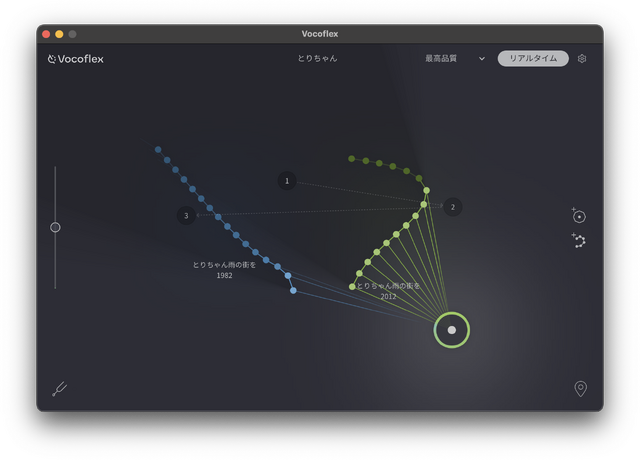

まず、AIボイチェンですが、VocoflexによるAIボイスチェンジャーをライブ演奏で初めて使ってみました。

正確には生成AI由来ではないようですが、低レイテンシーで別人の歌声に変換する技術で、RVCなどに近い結果をもたらすものです。

筆者は妻が所属していたバンドのリーダーから、こんな依頼を受けていました。「とりちゃんの歌声で、ライブでコーラスしてもらうことってできますか?」。

曲は尾崎亜美の「Stop My Love」。40年前のレパートリーで、40年ぶりに演奏することになります。

その話を最初に聞いたときには、「サンプラーを使えばできるかな」くらいに思っていて、「できると思うよ」と答えたのですが、ちょうどそのタイミングでVocoflexが発表されました。

このレイテンシーがどのくらい実用的かはその当時は疑問だったのですが、ベータ版を試してみて実用に足ると判断。実戦での投入を検討し始めました。

念のために「サンプラーでもいい?」と聞くと、「それだと、ドラムがタイミングを合わせられないかも」という意見が。

1カ月前のリハーサルにVocoflexを組み込んだMacBook Airとヘッドセットマイクを持ち込んで試したところ、とりあえずうまく行きました。

それで本番でもやってみたというわけです。

最初に伴奏なしでリードボーカルが歌い、妻の歌声と別のコーラスが重なっていく展開。コーラスパートは全体の4分の1くらいに及びます。

筆者はこのボイチェンの元音声と操作、そして、ドラムに合わせた爆発音、クルマのドリフト音のポン出しも担当。

ピッチがかなり高く、筆者だと最高音が調子の良いとき以外は出せないので、ピッチはVocoflex側で1オクターブ上げることにしました。

で、本番ですが、リハのときには気づかなかった問題が発生。元ボーカルの入力感度をかなり小さいところまで絞っていたのですが、リードボーカルの歌声に反応してしまいました。

(▲Vocoflexは左の上下スライドで感度調整をする)

すぐにVocoflexの操作で絞ったのですが、これは完全に切っておいた方がよかったです。もしくは出力のオン・オフは必須だと思いました。

あと、これはこちらの練習不足なのですが、オクターブ下げて歌うと、どこのパートを自分が歌っているのかを見失ってしまう問題もありました。やはり練習あるのみですね。

特にMCで説明していないけれども、とりちゃんの声だとわかってもらえたらしく、反応は良かったようです。

ただ、演奏しているメンバー(特に僕の真後ろにいたドラマー)からは、僕のオクターブ低い声が聞こえていて戸惑ったと後から言われました。

もう1つのAIの使いどころは、毎年の忘年会ライブで、バンドセッティングの合間に設けさせてもらっている、とりちゃんコーナー。そこで新曲のミュージックビデオを披露しました。

(▲AIミュージックビデオを上映する筆者)

以前はUTAU-Synthと既存の写真やビデオを使ったミュージックビデオや筆者とのデュエットをしていたのですが、今回は進化したAIの成果を見せられるということで、歌詞はChatGPT o1 pro mode、曲はSuno v4、画像はFLUX.1 [dev] + LoRA、リップシンクと動画はRunway Gen-3 Alpha Turbo、というその時点で最新の技術を使ってやってみました(作ったのがSoraの直前だったので)。

歓談タイムに入ると、いろいろと感想をもらえました。「どこまでAIでやってるの?」「だいぶ進化したね」「写真から動画にする技術がすごい」「本物じゃないの?」「AIだけで作った曲とは思えない」「本人とちょっと違わない?」「最後のシーンがいちばんとりちゃんらしかった」「すごくいい曲だから歌詞がほしい」「この曲、ライブで演奏していいですか?」などの声を、本人を知る人たちから直接聞けたのはとても良かったです。

YouTubeで公開したものには、リクエストに応えて歌詞を追加しました。

個人的に一番嬉しかったのは、自分より数年上のレジェンド級大先輩から、初めて声をかけられたことです。日本のブルースシーンの黎明期からアマチュアで活躍されていて、定年退職されてからはまたブルースギタリストに戻ったという方です。

「AI作曲すごいね。自分の曲のアレンジとか部分的に使えたりしない?」とさすがの指摘。70歳近いはずなのに。

「Sunoというアプリなんですが、自分で数十秒だけ作って、その続きのアレンジパターンや曲の展開を任せることができますよ。共作・コラボレーターだと思って使えば」などと返事しました。

SunoやUdioは業界としては反対していても、実際にプロの現場でも使われているだろうし、オリジナルを作っている人からすれば、フラットに使える実用的ツールとして見えるのだなあと。

ライブ演奏をメインとした忘年会ですが、年齢もあり、病気で参加できないメンバーも増えています。そうした中でAI技術は音楽を続ける上での役に立つのではないかと考えます。

しかし、リアルで集まると、また次に何をやろうかといったアイデアが出てきますね。ライブが終わって帰ろうというときに「トッド・ラングレンのコピーバンドやろうぜ」と盛り上がり、メンバーとやる曲も決定しました。

そんなコミュニティの話は、筆者の半生を取り上げた長編ドキュメンタリーにも登場します。