1週間の気になる生成AI技術・研究をいくつかピックアップして解説する連載「生成AIウィークリー」から、特に興味深いAI技術や研究にスポットライトを当てる生成AIクローズアップ。

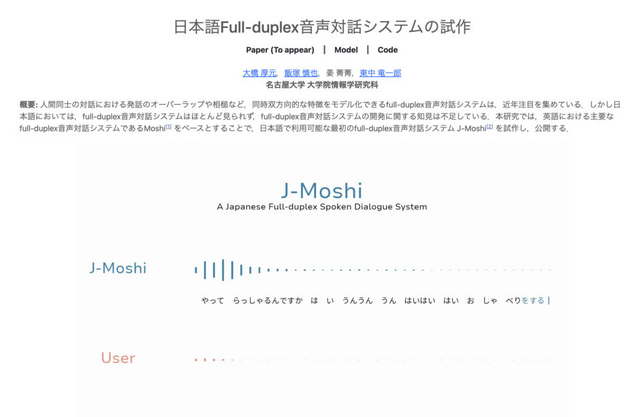

今回は、日本語でリアルタイムに音声対話してくれるAIモデル「J-Moshi」に注目します。名古屋大学の研究者らが開発したこのAIモデルは、ユーザーの声を聞いて内容に応じた発話を同時に行います。

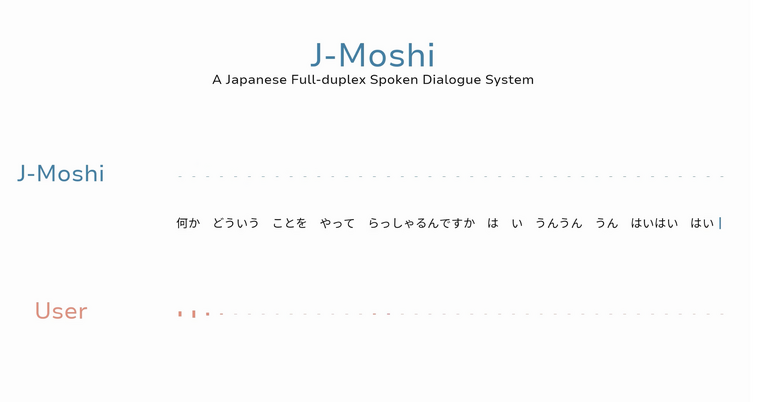

▲J-Moshiのプロジェクトページ

J-Moshiは、英語の対話システム「Moshi」をベースに開発され、人間同士の自然な会話で見られる発話の重なり(オーバーラップ)や相槌などの同時双方向的な特徴を再現できる日本語対応システムです。モデルサイズが7Bと軽量です。

特徴的なのが、ユーザーの声を聞いて一旦待って答えるのではなく、AI側からグイグイ(少し被せるように)話しかけてくるところです。それに加えて、自然なタイミングで相槌やフィラーを返すのが印象的です。

「うんうんうん」や「はいはいはい」といった相槌、「あの~」「えっーと」「まぁ」といった無意識につい出てしまうフィラーが会話の間を埋めるように自然なタイミングで入ることで、非常に人間味のある話し方を実現しています。

プロジェクトページのサンプルを聞いていると、抑揚があり感情も感じられ、積極的に共感してくれているように聞こえます。

システムの開発では、大規模な日本語音声対話データを使用して学習を行い、さらにMulti-stream TTSによる合成音声データを加えた拡張版モデル「J-Moshi-ext」も作成されました。

J-Moshiは試作段階なため、応答は不自然な場合もあり、また学習データの大部分は雑談対話であるため、ユーザーの指示に従った完璧な応答は現段階では難しいとしています。