プログラマー向けQAサイト Stack Overflow が、OpenAIのChatGPTで生成したテキストの一時禁止を告知しました。

理由は質問に対する正しい回答である割合があまりに低く、QAサイトとして有害であること。

同時に、AI生成による回答は一見もっともらしく書かれているため、検証には知識をもった人間が時間を費やす必要があるうえ、そうした回答が数千件単位で大量に投稿され、ボランティアベースの品質維持に支障を来すようになったことを理由として挙げています。

ChatGPTは人工知能研究機関のOpenAIが開発した言語生成モデルによるチャットボット。自然な言葉で話しかけたり質問すると、まるで人間が書いたような、一見して破綻のない文章を返せること、人間にとって難しい質問や抽象概念まで理解しているかのような回答ができることで大きな話題となりました。

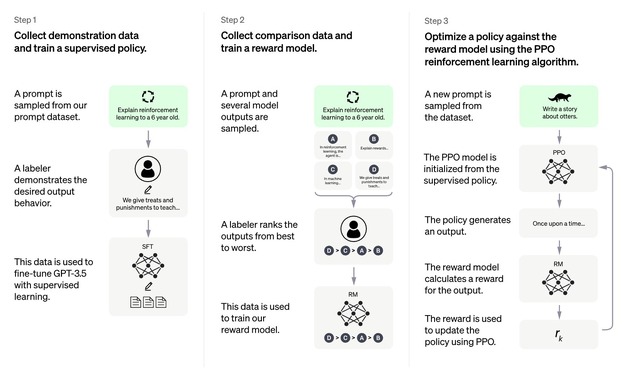

しかし問題は、あくまで理解している「かのような」文章を生成できる仕組みであって、人間のように文章の意味内容を解釈し、論理的に考えてから、文章として出力するわけではないこと。

質問を本当には理解していない、というより人間のような意味で理解する主体がなく、学習したデータに基づき言葉からそれらしい言葉の組み合わせを生成する仕組みのために、人間が読めば首尾一貫していないおかしな内容であっても、自分の誤りを認識して正すことができません。

ちょうど大量の画像で学習したお絵かきAIが、人間であれば相当の技術・知識・センスに裏付けられたかのような美しい画像を生成できているのに、解剖学や物理法則でありえないようなミスを平然としてくることに似ています。

(あるいは、何が表現として違和感のないデフォルメになるのか、それとも一見しておかしなエラーに見えるかの区別が難しいというべきか)。

このように、ChatGPTは質問を人間のようには理解しないまま動作する仕組みであるために、知識の限界から正しく答えられない質問があるだけでなく、まったく分かっていない質問に対しても区別できずそれらしい文章を作ってしまう、要は自分が何を知らないのかも知らない特性があります。

(ChatGPTは知識のもととして2021年までのオンライン上の情報をある程度参照しているため、分かりません・分かっていませんを返すこともありますが、それすらも信用できるものではありません。)

一方、Stack Overflow はQAサイトとして、回答者にバッジやポイントといったモチベーションを与える仕組みを導入していることが問題ややこしくします。

AIを使うことで、人間であるユーザー本人がまったく理解していない質問に対しても「それらしい」回答を簡単に、素早く生成できてしまうために、AI任せで回答数の荒稼ぎをするインセンティブを与えてしまっている状態です。

(正しくなくても、明らかに理解していない題材でも、とりあえず最速で回答らしきものをつけることで、露出を増やしプラス票を稼ごうとする回答者はAI以前から問題になっており、FGITW / 「西部一の早撃ち」という用語さえあります)

お絵かきAIならば新しいかたちの表現の道具として、あるいはアーティストが補助的に使うことで作品作りに活かすこともできますが、QAサイトの回答者がそもそも理解していない話題に手早く「回答」を生成して評価を稼ぐために使う状況では、AIの生成した文章を理解して訂正するモチベーションがありません。

ただし Stack Overflow も、ChatGPTテキストの禁止は現状の大量投稿で従来の品質評価・維持の仕組みが破綻してしまうため流量を減らすことが目的であるとして、文章生成AIの利用自体については、今後もスタッフおよび利用者による議論が必要になるとしています。

もう少し技術が進み、表面を取り繕う傾向を減らせれば、複雑な内容でも調べて回答してくれる一歩進んだGoogle検索やデジタルリサーチアシスタントとして下調べには有効に使えるようになるかもしれません。

同時に、これまで人間には難しかった「それらしい」テキストの大量自動生成という道具ができてしまったことで、「文章は人間が考えて書くもの」を前提とした仕組みは対策を強いられることになります。AIが書いたような無難なまとめになり恐縮です。

せっかくなので本人に訊いてみました。

個人の立場や意見があることが大事、という学習をしたようです。

「プログラムに基づいて回答を生成するため」