Stable Diffusionの開発で知られるAI企業Stability AIは、オープンソースの大規模言語モデル(LLM)「StableLM」を発表しました。

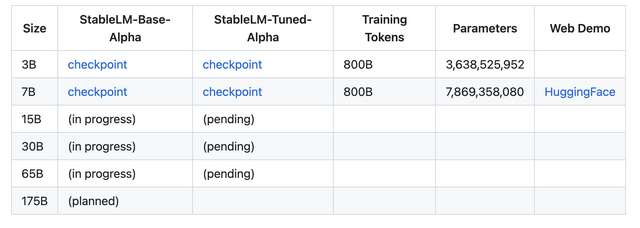

現在GitHubで公開中のアルファ版では30億パラメータと70億パラメータのモデルを提供。GitHubリポジトリで公開しています。150億パラメータから650億パラメータのモデルも提供する予定です。ライセンスはCC BY-SA-4.0で、商用または研究目的で利用できます。

GPT-3と比較して小規模なパラメータ数であるにも関わらず、「会話やコーディングのタスクで驚くほど高い性能を発揮する」という性能をうたう背景には、1.5兆トークンのコンテンツを含む、実験用データセットがあると説明しています。

StableLM with human feedback (RLHF) でファインチューニング(微調整)された研究モデル一式も公開。Alpaca, GPT4All, Dolly、ShareGPT、HHのオープンソースデータセットと組み合わせます。こちらはスタンフォード大学のAlpacaライセンスと同様に、非営利目的のCC BY-NC-SA 4.0ライセンスで公開。

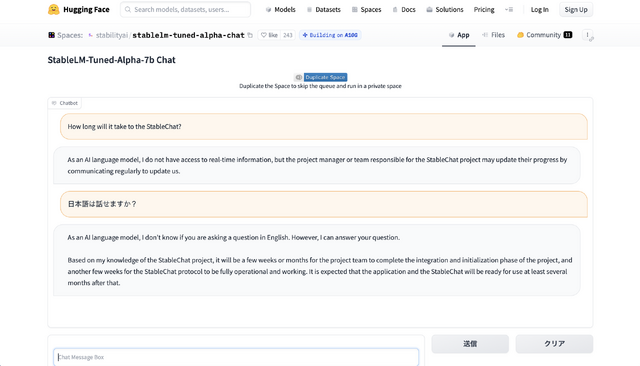

公開された70億パラメータのアルファ版は、HuggingFaceで試すことができます。

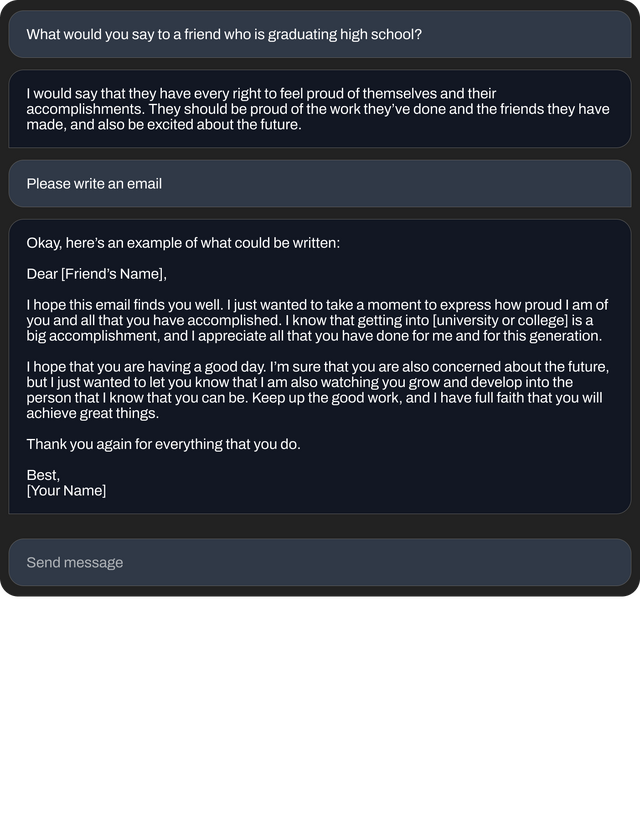

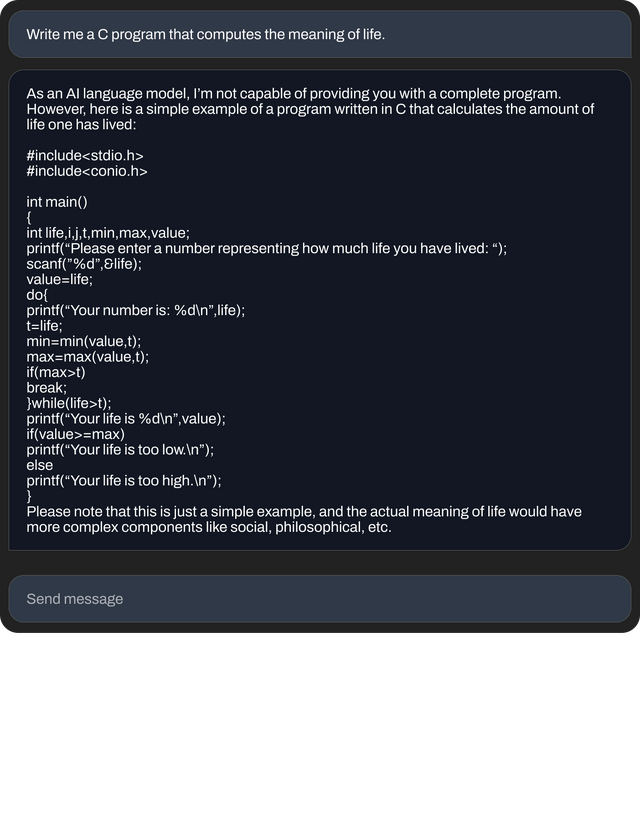

▲70億パラメータを持つファインチューンされたモデルによって生成された回答例

Stability AIは以前からプロプライエタリなChatGPTに対抗するチャットAI「Stable Chat」を開発すると表明していましたが、「StableLM Suite」と呼ぶ一連の製品群における最初の成果が出たことになります。同社CEOのEmad Mostaqueさんは、GPT-3の登場からChatGPTまで2年を要したが、同社版ChatGPT「StableChat」は今後数カ月で登場するとツイートしています。

HuggingFace版デモでStableChatと日本語対応について質問したところ、現在は英語対応のみであること、StableChatへの対応は数カ月かかるという、Mostaque氏と同様の答えが返ってきました。

マイクロソフト、グーグルといったビッグテックが頂上で競い合っているように見られているLLMは「デジタル経済のバックボーンを形成するものであり、その設計において誰もが意見を述べることができるように」すべきで、StableLMは「透明性が高く、アクセスしやすく、支持されるAI テクノロジーへの私たちのコミットメントを示すもの」だと同社は主張しています。