AIを活用して声を学習し、本人そのままの高精度な声で生成する技術がここ数カ月で大きく進化しています。

RVCというAIボイスチェンジャー機能は、岸田首相の声真似を本人の前でデモするまでになり、AIフェイクボイスの問題が一部で取り沙汰されるようにもなりました。

そんな中、アップルがAIを使った人声の学習・生成機能「Personal Voice」を今年下半期のOSアップデートで提供すると発表しました。

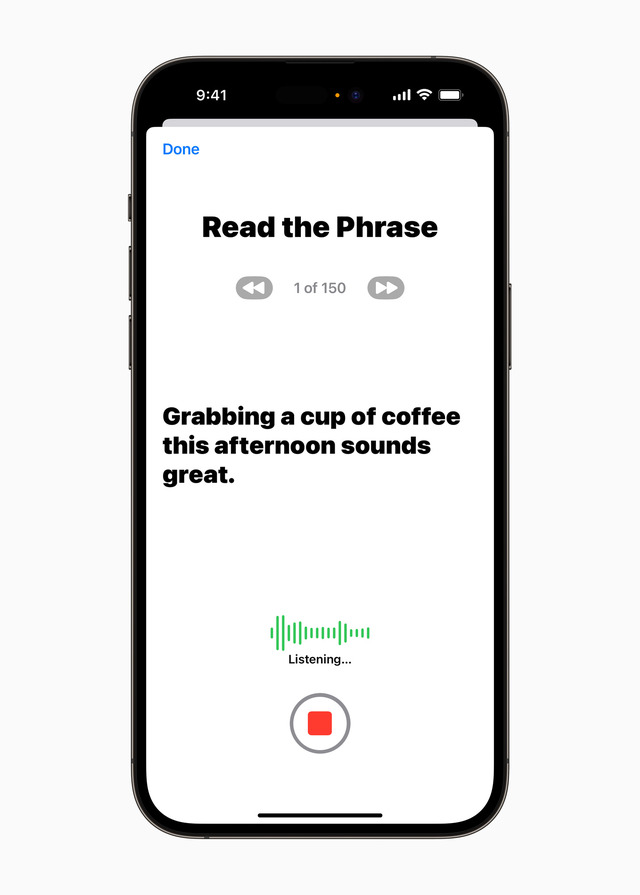

iPhone、iPad、そしてAppleシリコンを搭載したMacで15分、ランダムに表示される150の文章を読み上げるだけで自分の声を学習することができ、テキストをタイプすると自分そっくりな声で相手に伝えることが可能になります。ただし、当初は英語のみです。

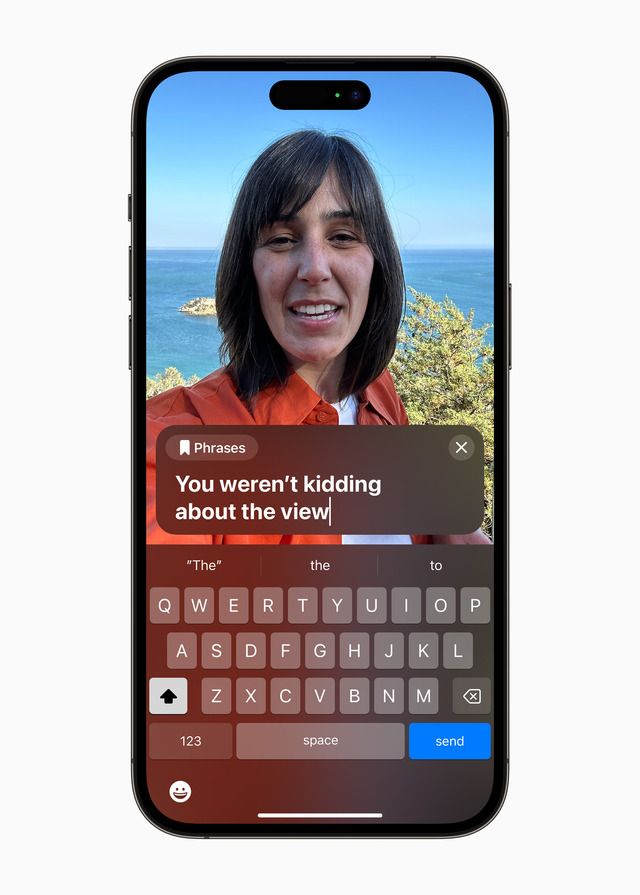

テキストした文章を音声化する機能(TTS、Text To Speech)をアップルは「Live Speech」という新機能で提供。これまではすでに書かれた文章の読み上げはできていましたが、Live Speechは音声会話の中で使うことを目的としたものです。

キーボードでタイピングした文章を、電話、FaceTime、Message、スピーカーを通してリアルでも音声に変換して利用できます。よく使うフレーズは登録可能。こちらもiPhone、iPad、Macで利用可能です。

AIを使った音声学習とTTSとしては、Microsoftの「Natural Speech 2」が今年4月に発表され、わずか数秒の音声サンプルから本人に近い声を生成できることが話題となりました。商用、オープンソース含め、同種の技術はいくつも登場しています。

アップルのPersonal Voiceは学習をiPhoneまたはiPadのローカルデバイスだけで行えるというところが大きな特徴です。アップルはプライバシーの問題から、これをクラウド上で処理せずに手元のiPhone、iPadだけで学習できるようにしたと説明しています。学習用のテキストがランダム化されていることも併せて、フェイクボイス作成用途には使いにくいようになっています。

iPhoneで自分の声を学習させてその声をTTSで使えるようにする技術としては、東芝の技術に由来する「コエステーション」があります。2022年にはこの技術が幼児向けの絵本音読にも使える「coemo」がトミーから発売されました。これは、読み上げたデータをサーバに送信してそこで処理して送り直すので、学習にも生成にも一定の時間がかかります。

筆者は他界した妻の音声をコエステーションを使って学習し、TTSできるようにしています。これは想定外の使い方です。孫たちにおばあちゃんの声で絵本の読み聞かせをしてもらおうと、本体まで買ってあります。ただ、今ではRVCによる、さらにリアルなAIボイスチェンジャーが使えるので、使い方をちょっと考えているところです。

アップルのPersonal Voiceは、声に障害を持つことが予想されるALS、声帯の手術を予定している人など、自身の声が出せなくなるおそれのある人が使うことを想定しています。

ですが、すでに声を失ってしまった人にとってはこの方法で学習することはできないので、RVCとTTSを組み合わせたような、さらに別の技術が必要となるでしょう。

アップルとしてはフェイクボイスに使えないように、自由に他人の音声が使えないような仕組みを構築していくことが想定できるので、一足飛びに「Siriの声を自由に変えられるぜヒャッハー」みたいなことにはならないと思います。まずはその前に早期の日本語対応を期待したいところです。

次期OSの目玉となりそうな機能なので、本来であれば差し迫ったWWDC23で発表されるような内容ですが、このタイミングで発表されたのは、5月18日がGlobal Accessibility Awareness Day(GAAD)であるため。アップルはこの日に合わせてこれ以外のアクセシビリティ関連の発表もしています。詳細はプレスリリースをどうぞ。