OpenAIはGPT Storeが開設された1月10日に、ウェブサイトの利用ポリシーのページをひっそりと更新し、そのページに記述されていた、同社のAI技術を「軍事・戦争用途(Military and warfare)」に使うことを禁じるとの文言を削除しました。

ポリシーの改定履歴を見ると、今回の変更理由は「より明確にし、サービス別のガイダンスを提供するため」と記載されています。 OpenAIの広報担当はThe Interceptに対し「われわれは、覚えやすく適用しやすい普遍的な原則のセットを作ろうとした。そのなかで『他人に危害を加えてはならない』という原則は、広範でありながら容易に理解でき、多くの文脈に関連する。加えて、私たちは明確な例として、武器の開発と他者への危害を具体的に挙げた」と述べています。

ただ、「危害を加えてはならない」という言葉が、従来のポリシーに記されていた「軍事・戦争用途」での使用禁止も含むのかとの問いに対しては明言せず「軍によるものも含め、『武器の開発や使用、他者への危害、財産の破壊、サービスやシステムの安全保障を侵害する不正な活動』に対するわれわれの技術の使用は認められない」との返答でした。

OpenAIからすれば、これまでポリシーの使用禁止リストに「軍事・戦争」の明記があったことで、契約額が高額になる国防総省など政府関連の仕事を獲得することができなかったと考えられ、改訂によってその道が開かれる可能性が考えられます。

2022年にOpenAIが発表した論文の筆頭著者でサイバーセキュリティ企業Trail of BitsのエンジニアリングディレクターであるHeidy Khlaaf氏は、The Interceptに、新しいポリシーは安全性よりも合法性を重視したように見えると述べています。Khlaaf氏は「OpenAIは、軍事用途で自社の技術やサービスを使用することで生じる可能性のあるリスクと被害をよく認識」しているとし「新旧のポリシーには明らかな違いがあり、以前のものは兵器の開発、軍事や戦争のための使用が認められていないと明確に定めていたのに対し、新ポリシーは柔軟性と法の順守を強調している」「大規模言語モデル(LLM)は、偏見を持ったり、いわゆる『幻覚』を生じることが知られており、全体的な正確さに欠けるため、もし軍事・戦争のために使用されれば、民間人の被害や犠牲を悪化させる可能性がある」と述べました。

また、以前連邦取引委員会(FTC)に勤務していたAI政策アナリストで、人工知能の社会的影響などに関する研究機関AI NowのマネージングディレクターであるSarah Myers West氏も、パレスチナ・ガザ地区の戦闘における「民間人を標的とするAIシステムの使用を考えると、OpenAIがポリシーの禁止事項から『軍事と戦争』の文言を削除したことは注目に値する」ことだと述べ、新しいポリシーに含まれる言葉は曖昧で、OpenAIがこれをどう適用するつもりなのかに疑問がわき起こっていると語っています。

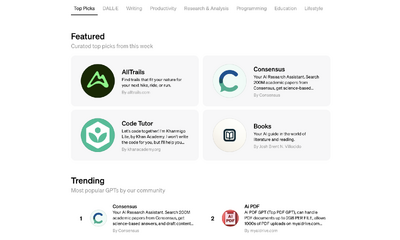

現在のところ、AIチャットボットのChatGPTやその他の大規模言語モデルが直接だれかを殺したりすることはありません。しかし軍隊での活用で想定されることとしては、兵器に使用されるプログラムコードの生成や情報分析、調達命令を処理する作業などで、ChatGPTが役立ちそうです(公開されているカスタムChatGPTのなかには、軍事関連のチャットボットもすでにあります)。

昨年11月に、非営利組織OpenAI, Inc.取締役会は孫会社である営利企業OpenAI, Global LLCのCEOが「取締役会とのコミュニケーションにおいて一貫して率直でなかった」としてサム・アルトマン氏を解任する騒動がありました。

これは人工知能がもたらすリスクを避け、安全着実な開発を重視する非営利組織としてのOpenAIが、AIの可能性を最大限に引き出すために商業化を推進使用とするアルトマン氏の舵取りを危惧したためだったとされます。しかし騒動はアルトマン氏の復帰と取締役会の刷新という結果に終わりました。

アルトマン氏は復帰後、取締役会を一新して足場固めを行いました。アルトマン氏の力が強まったOpenAIは、加速主義的考えが優位となり、汎用人工知能(AGI)の実現と商業化路線をさらに推進すると予想されています。