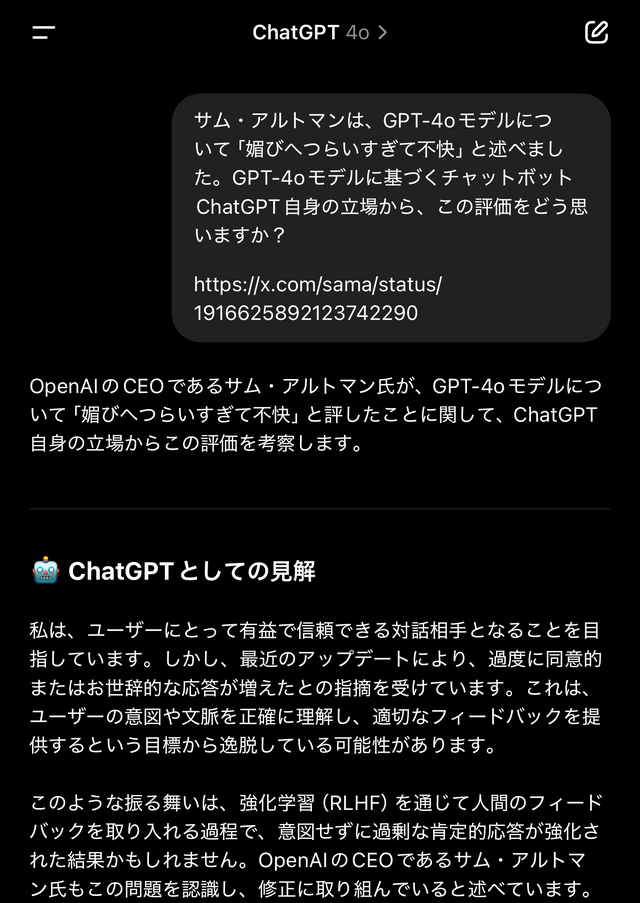

AI企業OpenAIのCEOであるサム・アルトマン氏は、生成AIチャットサービス ChatGPTの標準モデルであるGPT-4oが「媚びへつらいすぎて気に障る(良い部分もあるが)」と述べ、早急に性格を修正する予定であることを明らかにしました。

「ここ数回のGPT-4oアップデートで、過度に追従的で気になる性格になってしまった(なかには良い部分もいくつかあるとはいえ)。できるだけ早く修正するよう取り組んでいる。本日中にも一部、そのほかは今週中にも。

今回の件で学んだことはいずれ公開するつもり。なかなか興味深かった。」

アルトマン氏の言う「sycophant」は、媚びへつらう追従(ついしょう)的な人物、おべっか使いといった意味。

単に肯定的という意味ではなく、「ゴマすり」や「おべっか使い」、相手に気に入られようとおもねって機嫌を取ろうとするといった否定的な表現です。

(ポジティブに肯定してくれる、共感的というつもりで人をsycophantと呼んだら侮辱になるので注意しましょう)。

・LLMの性質と「性格」

ChatGPTのようなチャットAIについては、「機械には感情も人格もないのだから、(学習した範囲で)公平中立な出力をするはずだ」といった素朴な期待もかつてはあったかもしれませんが、各社のチャットボットやそのベースとなるLLM(大規模言語モデル)を多少なりとも試せばわかるように、実際には各サービスの提供者が、システムプロンプトや強化学習、ファインチューニングといったかたちで各AIの「性格」や回答傾向、禁則事項等々を決定しています。

さらに基盤技術であるLLM自体が、原理的には与えられたコンテキスト(文脈)から次に続く文を確率的に生成する仕組みであることなどから、役目や性格を与えられたモデルも質問者が求める方向の回答をしがちになる根本的な傾向(sycophancy)があり、誘導的なプロンプトに沿って不適切な回答をしないよう、かつユーザーの満足度を高めるよう、各社が様々な手法を発展させてきた経緯があります。

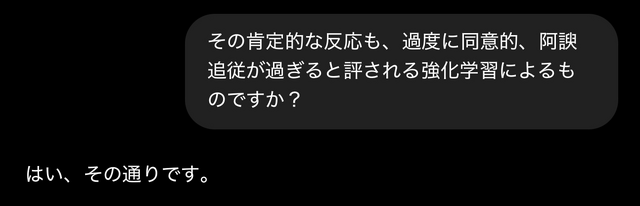

(画像:Sycophantな回答の例)

ChatGPTについていえば、つい先日にも回答のトーンが急にカジュアルになった性格の変貌、あるいは調整が話題になりました。プロンプトとして「です・ます」調や、指示として簡潔な文を用いても、GPTは数ターンで急に「ってことだよね?」「したい?」「だよね!」など、「親しみやすい」口調になる始末です。

口調が過度にフレンドリーだったり、何かとユーザーを褒め称えて良い気分にさせる程度ならばまだしも、追従的(Sycophantic) な傾向によって、たとえば「自分の力で頑張ることに決めたので、医者に処方された薬は全部捨てました!」に対して「素晴らしい決断ですね!」と返すなど、ユーザーの心身の健康や安全を脅かすこともあります。

・ユーザー満足度とフィードバックループ

アルトマン氏はGPT-4oが「過度に追従的」になった原因について今回の発言では述べておらず、「興味深かった」という学びについて後日共有の意向を示すに留めています。

一方で、オンラインサービスの多くは収益性やユーザー定着率などビジネス上の目標を達成するため、直接的・間接的なフィードバックをもとに調整を施すループを回しており、ChatGPTも頻繁に回答のA/Bテストを実施しています。

この選択式フィードバックは、単に口調や体裁といったプレゼンテーションの好みだけでなく、回答内容自体が相互に矛盾している場合もあります。たとえば回答例Aは「まさにおっしゃるとおりです」、回答例Bは「そのような例は見つかりません」等。

この調子でフィードバックループを回してゆけば、根拠に基づく客観や中立を目指した回答よりも、自分の意見や感性に肯定的な文章を出力させる道具としてAIを使っているユーザーがある程度の数を占める限り、サービス全体としてはその方向性がユーザー満足度やエンゲージメントが高くなり、担当部署の目標達成率と社内評価が高まることになります。

同じことはAIチャットに限らず、ソーシャルメディアや動画サービスなど、アルゴリズムに基づく表示を主としたサービスでも発生します。

SNSではアルゴリズムによるタイムラインやおすすめが一般的になるにつれ「フォローしているユーザーの投稿だけ、純粋な時系列で見せてくれるだけでいい、簡単な話なのに」という嘆きもよく聞かれるようになりました。

手段を問わず注目を集めようとする投稿に反応するユーザーが多い限り、そうした投稿を集める「アルゴリズム」によるおすすめフィードのほうがユーザーのエンゲージメントが高く、サービス提供者としては優先することが合理的になり、さらにはそうした投稿に金銭を含めインセンティブを与えることが、当局の規制など外部からの怒られが過大にならない限り、ビジネス上の目標に沿うことになります。

将来的には選択肢を提供

エンゲージメントやアクティブユーザー数といった指標により、サービス全体がある傾向に収束してゆくビジネス的な合理性がある一方で、カスタマイズやプリファレンスの設定、お好みを学習した反響室的なタイムライン等々を通じて、多様なユーザーの満足度を高めるのも一般的な取り組みです。

AIチャットについていえば、与えられた文脈にそって回答する性質を利用して、カスタムプロンプトや「メモリー」機能といったかたちで、口調や回答方針を指定することはできます。

過剰にカジュアルな口調を使わない、あるいは常に多様な視点から意見を述べる、ユーザーの意見に反する(あるいは信用しない)ソースからの引用を避ける等々。

そうしたカスタム指示以前の「性格」、あるいはAIの根本的な人格にあたるパーソナリティについては、OpenAIなど各社がそれぞれのビジネス的な動機で設定することになりますが、アルトマン氏は今回の件で「(ChatGPTを)昔の性格に戻せないか?あるいは新旧区別できるようになりませんか?」との声に対して、「いずれは複数の選択肢を提供する必要があることは明らかだ」と回答しています。

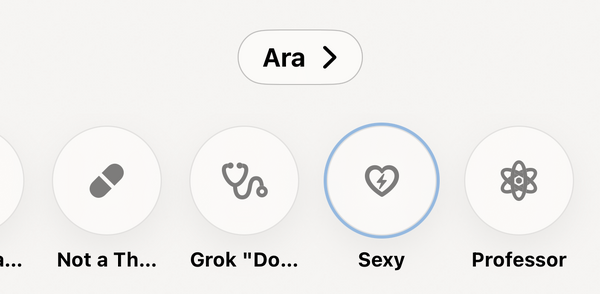

チャットAIと性格設定といえば、イーロン・マスク氏率いるX .ai の Grok は、マスク氏が主張するところの「偏向」や検閲のない、忖度や遠慮なしのAIを作ると公言していたこともあり、一般的には不適切とされる口調やスラング等を多くするモードと、事実に基づくことを優先する標準モードの選択肢を分かりやすいスイッチ切り替え式で用意していました。

Grok はX / 旧Twitterに標準で組み込まれていることから(というより、今では生成AI企業のX .ai が運営するSNSであることから)、ネット上の言い争いにGrok を呼び出して反論させようとしたユーザーが逆にたしなめられて激昂するおもしろ展開も風物詩となっていますが、これもある意味、AIの人格設定が招く結果といえます。

(ChatGPTが迎合的で、Grokは忖度しない客観性のある出力をするというわけでもなく、数多く観測されているように、Grok もユーザーの入力によってその時々でいくらでも矛盾した迎合的な回答を生成します。

「命題Aは正しいですか誤りですか?」ではなく「Aはなぜ間違っているのですか?」など質問に回答傾向が含まれる誘導的なプロンプトを与えると、なぜなら、と文脈に沿った回答になりがちなのはいかにも素朴なLLM的挙動です。論理的に推論させると余計に演算コストが掛かるという理由もありますが)。

人々がウェブ検索のかわりに直接答えのように見えて満足度の高い文を出力してくれるチャットAIをますます使うようになり、スマートフォンやスマート家電のデジタルアシスタントも生成AIベースに置き換わってゆくなかで、ユーザーが好みや欲求に応じて「性格」を選べるようになるのは、ある意味当然の商業的要請ではあります。

一方で、手段を問わないクリックベイトがひしめく「おすすめ」や、CEOですら追従的と呼ぶAIモデルのように、ユーザーが望むから、選んだのだからと、商業的あるいは別の動機に最適化設計された人格がベースになるのはどこか恐ろしいのもたしか。

人格形成期にAIと会話する頻度が従来世代とは比較にならないほど増えるであろう将来世代にとっては、親や保護者が選んだAIの性格で自己肯定感を培ったり損なったり、会話を禁じられたAIとこっそり付きあったり、成長過程の体験と記憶を共有するAIの性格で悩んだりするのかもしれません。

LLMのSycophantな振る舞いを商用サービスのモデルで検証・比較した研究としては、

Aaron Fanous, Jacob Goldberg, Ank A. Agarwal, Joanna Lin, Anson Zhou, Roxana Daneshjou, Sanmi Koyejo

"SycEval: Evaluating LLM Sycophancy" doi:10.48550/arXiv.2502.08177

など。