3年ぶりに、Adobe MAXを現地取材してきた。内容についての記事は6本くらい掲載予定なので、そちらをお読みいただければ、と思う。

関連記事:Adobe CCが大型更新。複雑な被写体や顔パーツの一発選択など強化点多数 (Adobe MAX 2022)

今のAdobeといえば、盛り上がるのはやはり「Adobe Sensei」がらみ。あらゆる機能がAdobe Senseiのブランドで作られており、同社が積極的に行なってきた「AI投資」が生きてきたためでもある。

では、それはどのような意味を持っているのだろうか?

この数カ月で、いちから絵を描くAIは急速に進化し、「絵を描くこととAIの関係」を変えてしまった。

Adobeで開発中の機能をチラ見せする「Adobe Sneaks」を見ながら考えたことを、Sneaksの内容をご紹介しつつ、少し語ってみたい。

▲Adobe MAXの名物企画「Sneaks」。技術アピールの場であると同時に、最新技術のトレンドを楽しめる場でもある

「描かれていない部分」を描くAI

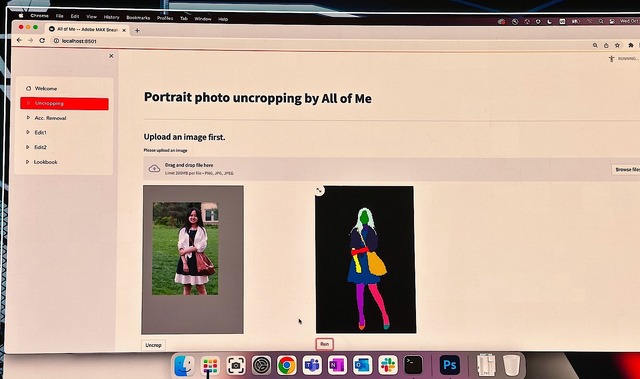

今年のSneaksで、筆者が一番インパクトを受けたのは「Project All of Me」という技術だ。

「せっかくの舞台なのに、1枚のイケてない写真しかなかったとしたらどうでしょう?」

そんな風に話して、開発者はある機能を紹介した。1枚の写真から「クロップ前の周囲を作り直す」機能だ。切り取られていた風景や膝から下の映像を、AIが作り直してくれる。

▲クロップしてしまった写真は元に戻せないものだが……

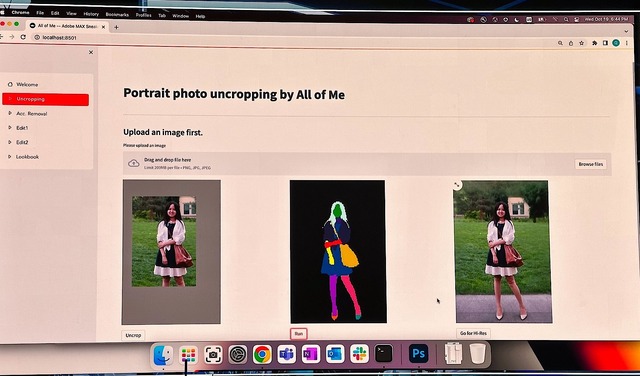

▲AIが背景や足を補完して写真を作り直してくれる

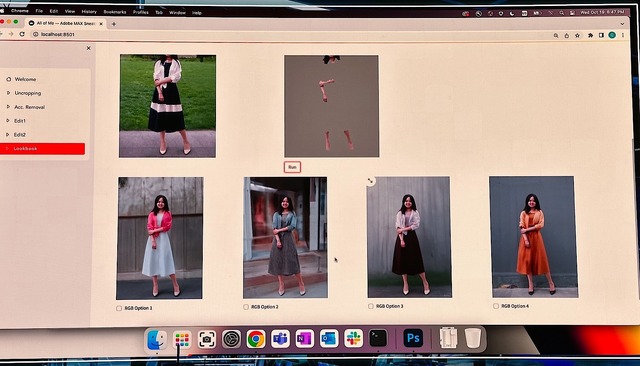

さらには、顔や腕、足などだけを残してぬりつぶした上で、衣服や風景など、他の部分をすべてAIで作り直してしまった。

▲足の一部どころか、衣服から背景までをさまざまなバリエーションで作り直すことも

AIは「自然な人間の姿」や「それっぽい風景」「見栄えのいい衣服」などの情報を知っている。大量の写真から学習してAdobe Senseiの中に蓄積された教師データを使い、不足している部分を描くのがProject All of Meなのだ。

描かれたものの質はともかくとして、こういう機能は確かに有効だ。実際「絵の描かれなかった外側を描くAI」はすでにある。それと似たことをしている、と思えば不思議な話ではない。

一方で、今のPhotoshopを見るとこういう機能が一般的なものとして搭載されていくであろうこともイメージできる。

次の画像は、Photoshopの最新バージョン「2023」に搭載された「コンテンツに応じた塗りつぶし」を使った結果を示したものだ。

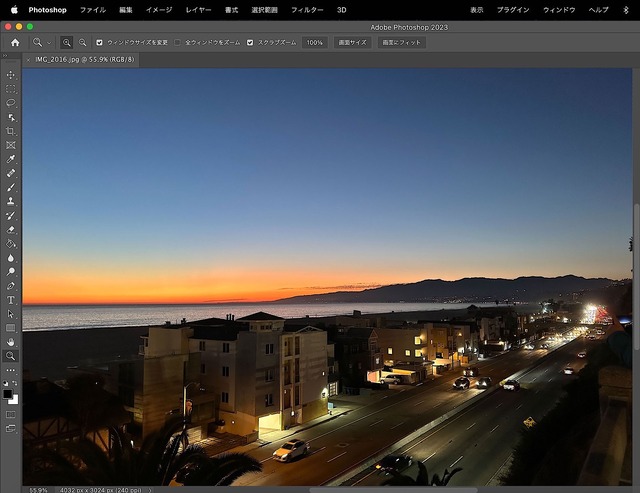

▲今回の出張中、サンタモニカで撮影した写真。これだけでも美しいが、ちょこちょこと邪魔な要素がある

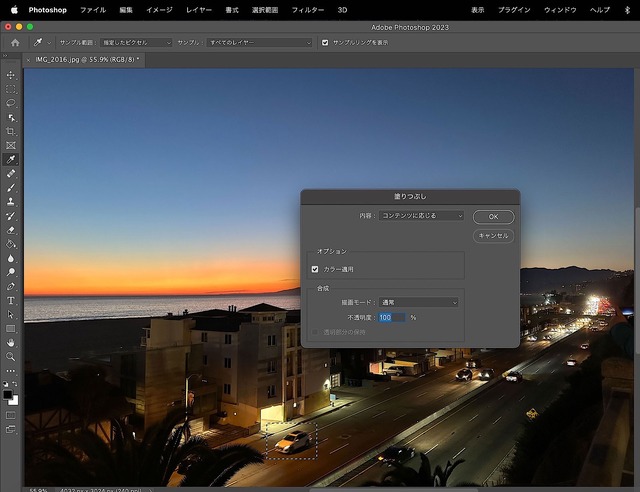

▲Photoshop 2023の「コンテンツに応じた塗りつぶし」は、いらない部分を選んで「削除」するだけでOK

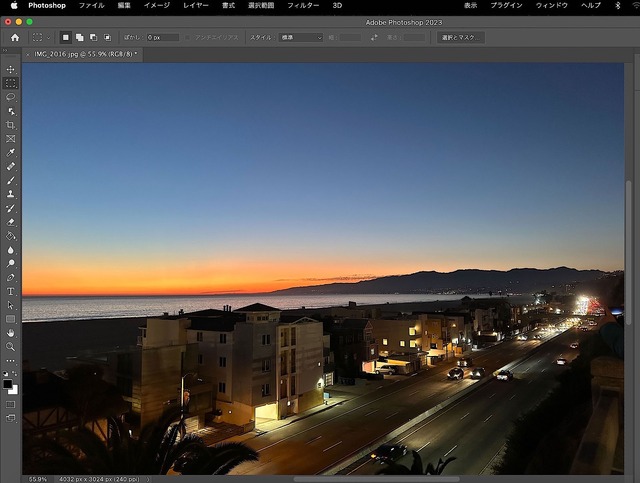

▲作業後。いくつかの部分が自然に消えている点に注目。作業時間はほんの2、3分だ

以前からPhotoshopでは、クローンブラシなどを使って「消したい部分を選んで自分で処理をする」ことで、写真から不要なものを消してすっきりさせることができた。それが「コンテンツに応じた塗りつぶし」を使うと、一発で終わる。これもまた、Adobe Senseiを使った技術である。

機能としては、Pixel 6以降でGoogleが「消しゴムマジック」として搭載しているものとほぼ同じなのだが、それだけAIの活用例としては一般的なものということになるのだろう。

そうした機能の延長線上に、「切り抜きの末になくなった部分を描く」「写真のほとんどを自然な形で復元する」機能が出てきても不思議はない。Project All of Meはそういう存在だ。

「撮影されていない背景をAIで作る」意味

存在していないものを描く、という意味では「Project Beyond the Seen」にも通底する部分がある。

この機能は、主に3Dグラフィックスのために作られたものだ。

3Dグラフィックスでは「環境マッピング」という技術がよく使われる。レイトレーシングなどを使って反射を正確に描くと計算負荷が大きくなる。そこで、自分の周囲から見えるものを映像として用意し、それを「反射して見えるもの」の情報として物体にマッピングするのが環境マッピングだ。

当然、環境マッピングには「周囲の情報が全て含まれる画像」が必要になる。しかし、それを用意するのは意外と大変なもの。そこで出てきたのがProject Beyond the Seenである。

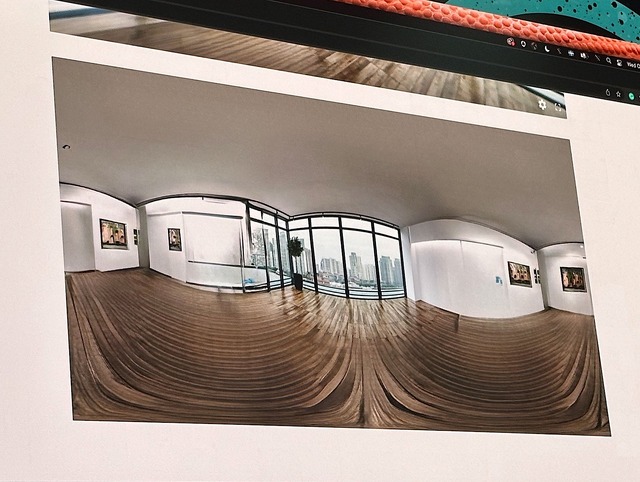

Project Beyond the Seenは1枚・1方向の写真から「写っていない方向」の写真を生成し、部屋全体の環境マッピングを作る。そうすれば、リアルな3D CGを作るのが非常に簡単で手間も減る……という発想だ。

▲背景としてはこの写真1点しかない場合でも、Project Beyond the Seenを使えば大丈夫

▲Project Beyond the Seenを使って作った背景。中央の窓のところ以外は全部「生成した背景」だ。

▲生成した背景を環境マップとして、光沢のある物体をレンダリング。かなり自然な印象になる

これもまた、見えていない部分を描くという点でProject All of Meに似ている。

人間が想像力を発揮して絵を描けば、Project All of MeやProject Beyond the Seenがやっていることは容易にできる。だがとにかく面倒だ。それを、多数の写真から学習したAIが代替してくれるのであれば、作業は楽になる。この「手間の軽減」こそが、Adobeの目指すところなのは明白だ。

一方で、非常に面白い話もある。

Project Beyond the Seenが生成した写真を見た建築関係の専門家は、「建物としてあるべき梁や柱がない」と指摘する。確かに、ぱっと見には普通の部屋に見えるが、どこか不自然な「現実にはあり得ない」ものになっている。

AIによって描かれた絵では、手や指、足などが不自然になることがある。AIは人間を構成する要素を学習・理解して描いた訳ではなく、「多くの絵に共通する要素」だけで描いているからだ。絵を学んだ人間なら避ける要素があっても、AIは避けるとは限らない。Project Beyond the Seenが不自然な部屋を描くのも同様だ。

だが、光沢のある物体への環境マップであれば、そうした不自然さに気づくことはまずあるまい。人間はそこまで注意力が高い訳ではないので、「部屋の様子がちゃんと反射して見える自然さ」の方に引きずられてしまう。

最小限の努力で最高の効果を得るという要素を考えると、この機能は十分に役にたつ。

AIが人を助ける、とはそういうことなのだろう。

こうした技術は、一から絵を描くAIとは違うもののように感じられるかもしれない。

だが、本質的にはなにも変わらない。人がなんのためのAIを使うのか、という点が違うだけだ。そして、AIの不完全さとの対峙という意味でも、Adobeが選んでいる方法論は現実解の一つと言える。

空間の構造をAIが推定、自然な影を生成

もう1つ、AIを含む技術の活用例として面白い、と思ったのが「Project Made in the Shade」だ。

これは写真の中に「自然に影を合成する」ための機能、と言っていい。

例えば実景の写真に、3Dで作った看板やパラソルを加えるとしよう。実景が単なる道路や砂地なら、まっすぐ影を書き加えればいいから簡単だ。だが、そこに車が停まっていたり人がいたりしたら、その形に合わせて影を描く必要が出てくる。

Project Made in the Shadeはそれを実現している。合成する位置を変えれば影の形も自然なものになるし、逆に写真に含まれたもの(自動車や人)の位置を変えてもまた、影の形は変わっていく。

▲元の写真には看板はない

▲だがProject Made in the Shadeを使うと、看板の影が自然に自動車の曲面に沿って描かれる

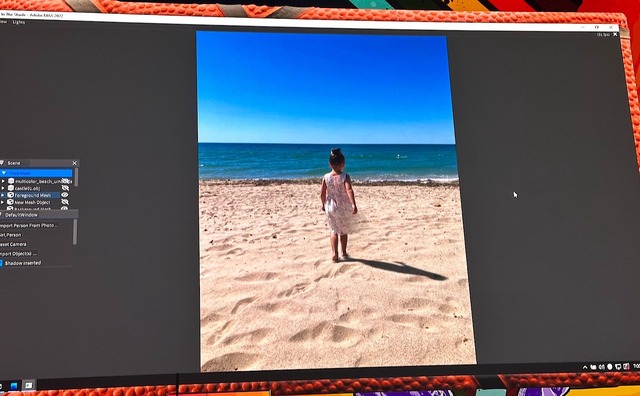

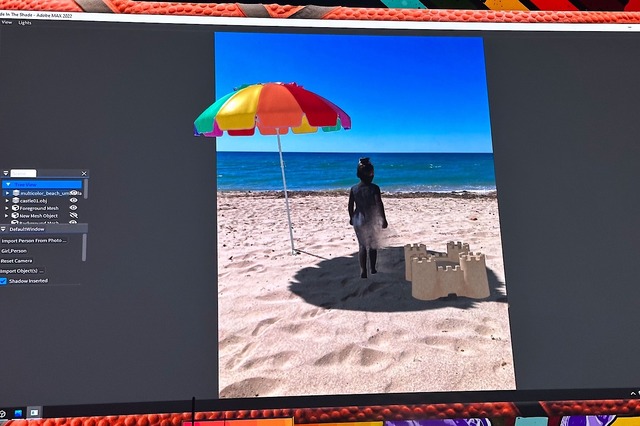

▲元の写真にはパラソルも砂のお城もない

▲3Dモデルのパラソルや砂のお城を置くと、それに合わせて自然な影が描かれる

すなわちこれは、1枚の写真から「中に写っているもの」と「それを三次元空間と見立てた時の位置関係」を推定し、3D CGの技術を使って影を描いている、ということなのだ。

これはなかなか面白い。

人間が絵を描く際も、脳内で「絵の中の立体構造」を考えて描く。写真を見ながら模写するなら、描かれているものと背景がどこで別れているかを考えながら描くものだ。

そうした「空間把握と物体の識別」という要素をAIで再現したことで、Project Made in the Shadeのようなことが可能になってくる。

すべてを3Dのデータで持つ時代はなかなか来ないだろうが、人間が脳内で空間把握を行うように、AIの力で「すでにある写真から3D空間を構成する」技術はどんどん広がっていくだろう。フォトグラメトリなどだけでなく、Project Made in the Shadeのような簡易的な技術が活用されるのだろうと想像できる。

そう考えると、これもまた「人間が考えて作業することを楽にする」要素、と言えるのではないだろうか。

※この記事は、毎週月曜日に配信されているメールマガジン『小寺・西田の「マンデーランチビュッフェ」』から、一部を転載したものです。今回の記事は2022年10月24日に配信されたものです。メールマガジン購読(月額660円・税込)の申し込みはこちらから。コンテンツを追加したnote版『小寺・西田のコラムビュッフェ』(月額980円・税込)もあります。