アップルの研究者らが、入力した文章によって画像を編集できるAIモデル「MGIE」を発表、公開しました。

MGIEとはMLLM-Guided Image Editingの略で、テキストベースのコマンドを解釈するマルチモーダル大規模言語モデル(MLLM)を使用しています。

MLLMは単純であいまいな文章を、フォトエディターで処理する詳細で明確な指示に変換できます。

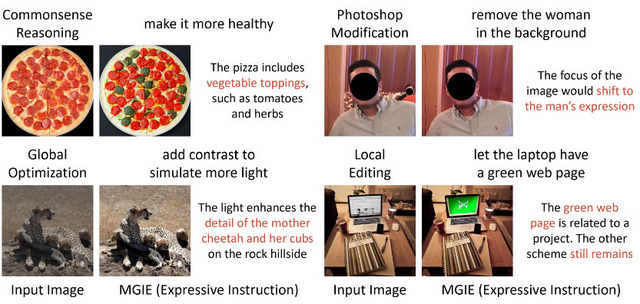

例えば、ユーザーがペパロニ・ピザの写真を「もっとヘルシーに」見えるようにしたいと思い入力したなら、MLLMはヘルシーとは何かを解釈し「野菜のトッピングを追加する」という文章に変換します。

MGIEでは、このMLLMを2つの方法で画像編集プロセスに統合しています。

まずひとつめは、MLLMで入力されたユーザーの入力をより表現力豊かな指示として解釈すること。「空をもっと青くする」と入力が与えられれば、MGIE は「空の領域の彩度を20%増加する」といった、より具体的な画像加工の命令を生成します。

ふたつめは、MGIE自身がMLLMを使用して、視覚的な想像力による表現を得ることが挙げられます。これはつまり、望ましい編集結果の潜在的表現をMLLMによって生成するということです。

もちろん、MGIEはもっと単純な、普段からわれわれが行っているような画像編集も可能です。たとえばトリミング、サイズ変更、回転、反転、フィルターの追加など、Photoshopでやるような一般的な編集はもちろん、明るさやコントラスト、シャープネス、カラーバランスといった画像全体を対象とするグローバルなパラメーターの調整なども可能です。

さらに画像全体ばかりではなく、被写体となる人物の髪型や目の色、服装を修正したり、背景から切り抜いたりすることもできます。これらはローカル編集と呼ばれる類いの操作です。

将来的に、アップルがこれを自社製品に組み込んだり、単体のツールとしてリリースしたりすることがあるのかはまだわかりません。

しかし将来的に、MGIEがSNSからアート、エンターテインメントなど様々な分野で画像を生成、編集、最適化するのに役立つようになる可能性は十分に考えられます。

MGIEはオープンソースとしてGitHubで公開されているので、興味ある人はこれを試したり、手を加えることができます。また、もっと手軽に体験したいなら、Hugging Face Spacesに設置されているデモに触れてみるのが良いでしょう。ここでは、対象となる画像をアップロードし、適当な文章を入力して、その結果を見るまでを試すことができます。