テキストプロンプトからリアルな動きのある映像を生成できる動画生成AIのSoraやKLINGが使えずにヤキモキしていた人々が大挙して押し寄せた「Luma Dream Machine」。

このサービスの有償プランに申し込んで使って、少しプロンプトのコツが掴めたので、お伝えしたいと思います。

ただ、自分が使った目的は映画などの映像制作ではなく、あくまでも静止画、それも人物を動かすことなのでご注意を。より具体的には、11年前に他界した妻の動く姿を見ることです。

■フィルムカメラの写真を動かす

まずやってみたのは、実際に撮った写真をDream Machineで動かすことです。

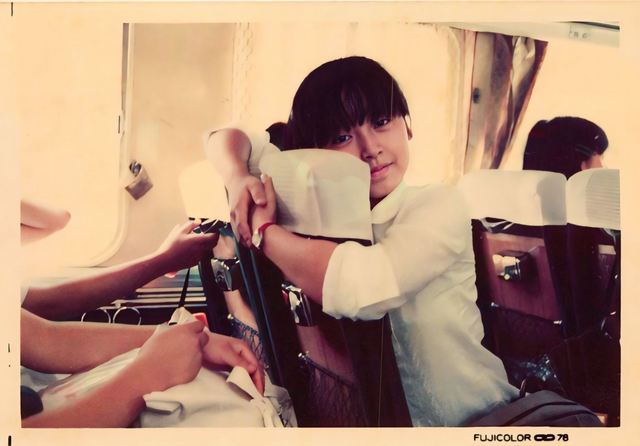

使った写真は、1978年から1987年にかけてフィルムカメラで撮影したもの。子供が生まれてビデオカメラ(ビデオ8mm)を買ったのが1987年なので、それまでは動いている映像がほとんどなかったのです。

例外として、学園祭の劇で主役を演じたものと、特捜最前線でエキストラをやったときのものは残っていますが。

多くの人にとって、1980年代以前の、動きのある映像は残っていないと思います(8mmフィルム愛好家がいる家庭は別)。

残された写真からその人が動いているところを見ることができたなら……。そういった願望を形にしたのが、ハリー・ポッターの両親が動いている様子を見ることができる写真アルバムや、見るものの願望を映し出す「死の鏡」です。

筆者が妻の写真から変換したアニメーションをXに投稿すると、多くの人がハリー・ポッターのあの魔法だとコメントしました。

(▲1978年に撮影された写真をReminiで高精細化)

(▲Luma Dream Machineで動画変換)

このXへの投稿はかなり衝撃的だったようで、40万を超える再生数となっています。

「FUJICOLOR 78」という表記がアナログフィルムであることを表していますが、動いているのが不思議。妻の高校時の同級生がこれを見て懐かしがってくれました。

同じときに撮ったと思われる別の写真も動画変換してみました。プロンプトはどちらも同じで、「a girl is on a train」だけ。しかし、今度はただ拡大するだけで動きは全くありません。

背もたれに抱きついているため形状を把握しにくいからか、動きをつけてくれません。

ここでちょっとプロンプトに工夫をします。友人とおしゃべりしているという設定で、「a girl is talking with her friend on a moving train」と、背景が移動し、なおかつ視線が友人(カメラ)に向いていることを想定したものです。

電車の振動で揺れる本人、移り行く窓の外の、陰影の変化などが反映されています。

実はこの2枚の写真、とても表情が良くて、なんとかもっと見ていたいと思っていたのですが、背もたれに顔が隠れていたり、姿勢が普通ではなかったりと、AIの参照には向いていません。それが、Dream Machineではうまくいったので、とてもうれしかったです。

こちらの動画もよく見てもらっています。

振り返ったり立ち上がったりと大きな動きがついてしまうと、顔自体が本人と変わってしまうことが多いです。これは、学習データが欧米人に偏っているためと思われます。

対処方法としては、視線ができるだけ動かないようにプロンプトの工夫をすることですが、それだと動きが全くないものになりがちという問題はあります。

視線を動かさない方法として筆者は、「~ is looking at me」「~ is staring at the viewer」といったプロンプトを使っています。これに、親しみを込めてというニュアンスを加えて「~ is looking at me affectionately」と加えたりすると、動きが大きくなって別人化したりするので、注意が必要です。

この画像は、つくば博に行ったときのスナップ写真ですが、Dream Machineへのプロンプト「a girl is looking at me」によって自分にずっと目線が向かっているため、非常に一貫性の高い動画が生成されています。再生するたびにドキドキしてしまいます。

一方、どうしても動いてくれない写真もあります。

1984年にカフェで撮影した写真で、カメラをじっと見つめているとても良い写真だと思うのですが、プロンプトを「she is talking」とか「she is closing her eyes」などと変えながら6回生成してみたのですが、どれも拡大していくだけでまったく動きがつきません。「これはこれで完璧なんだから動きなんていらないんだよ」とDream Machineが説教しているような気もします。

こうした試行錯誤をするにしても、数十分以上待たされるのは大変なので、無料アカウントの方は、できるだけプロンプトを工夫するようにして臨んでください。サブスクすると、ほぼ待ちなしで、すぐに生成が始まるので、覚悟を決めて4000円ちょっと投資してみるのも悪くないと思います。

なお、FAQによれば、有償アカウントでないと商用利用はできないそうです。

次に、生成した動画をいくつか集めてミュージックビデオを作ってみました。

■ミュージックビデオを作る

Dream Machineで生成できる動画は5秒のみ。それ以上伸ばすためには最後のフレームをアップロードしてまた生成するといった、たいへん面倒な作業が必要です。比較的簡単にまとまった映像を作るにはミュージックビデオというフォーマットが便利。というわけで、妻の写真を元にしたミュージックビデオを作ってみました。

Dream Machineで生成した動画クリップをトランジションで繋いでいくだけという単純なものですが、音楽にはSunoで「Dream Machine」をテーマに作った新曲を使っています。Sunoに「夢見る機械を夢見る」とだけキーワードを与えてできた曲です。

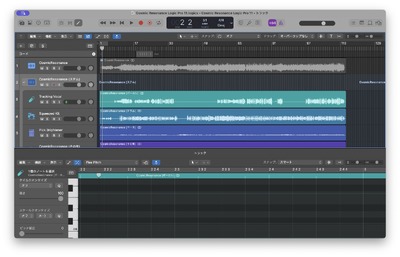

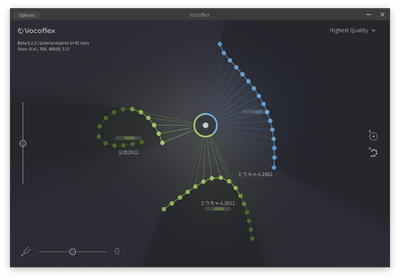

この女性ボーカルを妻の歌声を元にした妻音源とりちゃん[AI]にするため、AIボイスチェンジャーのVocoflexを使用。Logic Pro 11のステム分離機能であるSTEM Splitterを使ってボーカル分離してボイチェンしました。

次に、本物の写真だけでなく、妻の写真を学習させてStable Diffusionで生成したポートレート写真を使い、同様の試みをしました。

生成AI画像だからといってリアルな写真と大きく違いはありませんが、あまりにのっぺりした写真だと、動きをつけにくいという問題は発生するようです。

こちらも同様にミュージックビデオにしました。同じ取り組みですが、Sunoの英語曲です。

もう一つ、ミュージックビデオの完成形を作ってみました。こちらは写真からのものとStable Diffusionからのものを混在させています。かなり楽しい作業でした。

■ Dream Machineを提供するLuma AIという会社

Luma Dream Machineがいきなりできたかのように思う方も多いと思いますが、実はこのサービスを作ったLuma AIという会社は知る人ぞ知る、3D画像の大御所といっていい、シリコンバレーの企業です。

裸眼立体視のクラウドファンディングを成功させたLooking Glass Goの立体視映像は、Luma AIで変換を行っています。2D写真を立体視できるように変換するにはLuma AIのサービスを使うのです。

Text to 3Dを行うGenieというサービスも提供しています。

動かしたときに破綻が少ない(ないわけではないが)のには、こういった技術背景があったというわけです。