動画生成AIで、今回は3つの大きなニュースがあります。そのうち2つは前回お伝えした驚異的なオープンソース動画生成AI「FramePack」に関すること。もう一つは中国製動画生成AI「Vidu」の日本進出です。

■FramePack-eichiは「動画生成の次の課題」に対応してしまった

前回は1分、2分と分単位での生成が可能になったFramePackの登場で、ストーリーボードやマルチフレームでのプロンプト処理が必要になるとだろうとの予想を書きました。

そうしたら、その翌日にはFramePackの拡張として、まさにそうした機能を備えたソフトが公開されたのです。

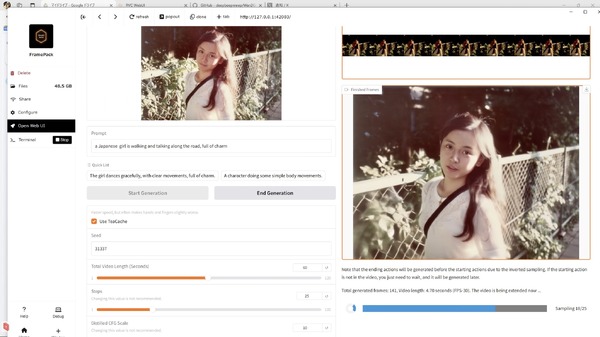

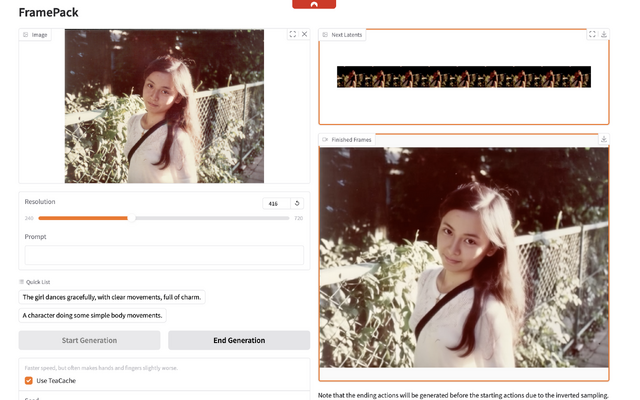

スタンフォード大学のlllyasvielさんによる本家FramePackは、アップロードした1枚の画像から後方に生成していくImage to Videoですが、これにもう1枚の画像をEnd Frameとして追加するブランチをnirvashさんが公開。

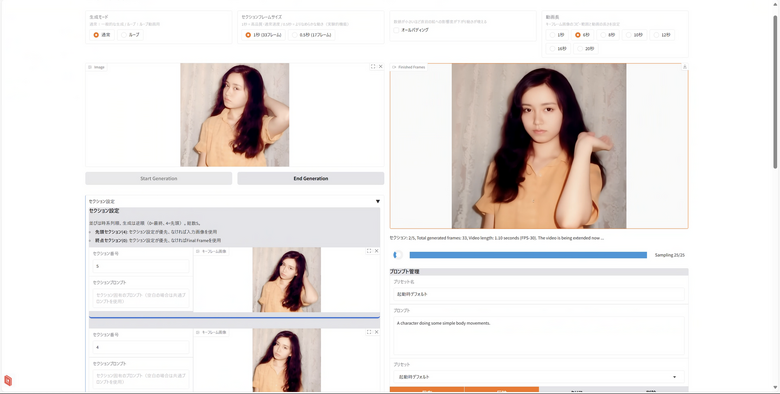

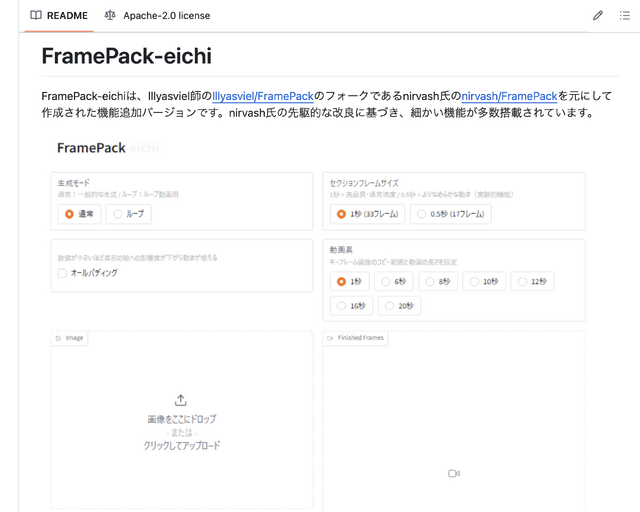

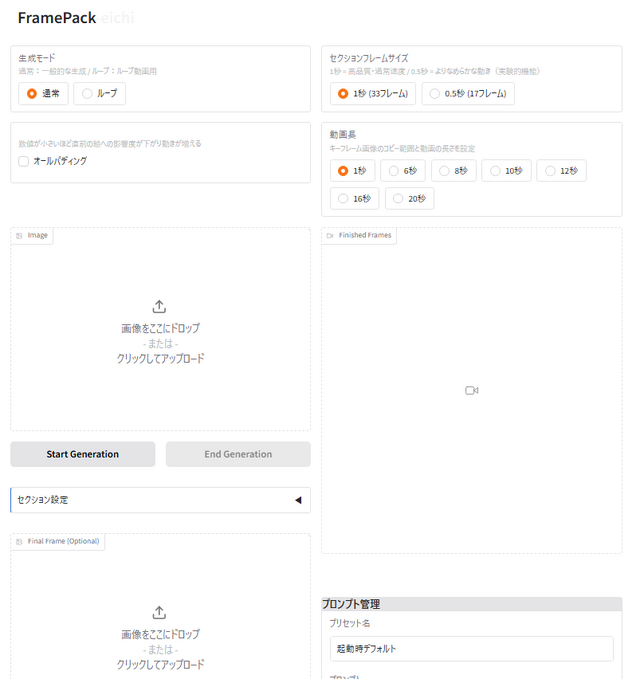

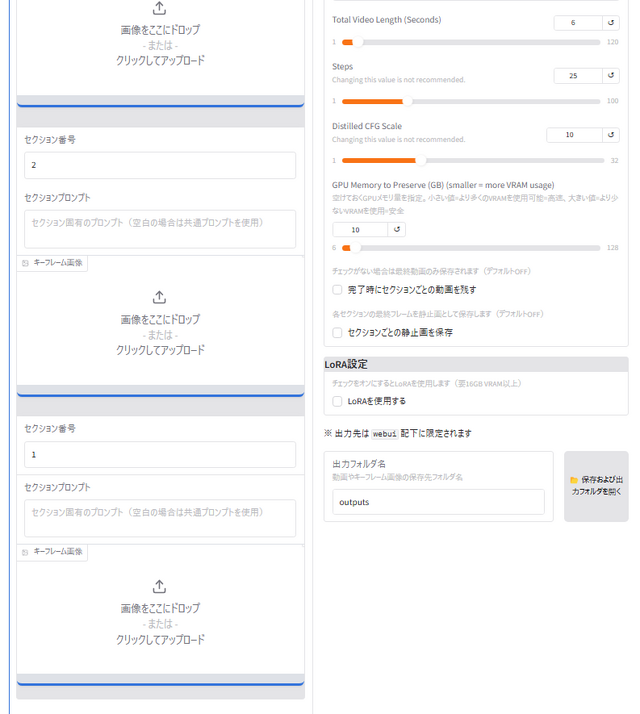

これをベースにさまざまな機能強化を行なった追加ソフトをcodeさんが「FramePack-eichi」(叡智、Endframe Image CHain Interface)として発表しました。これがすごいのです。

この「叡智」の主な機能としては、

高品質な動画生成: 単一画像から自然な動きの動画を生成 ※既存機能

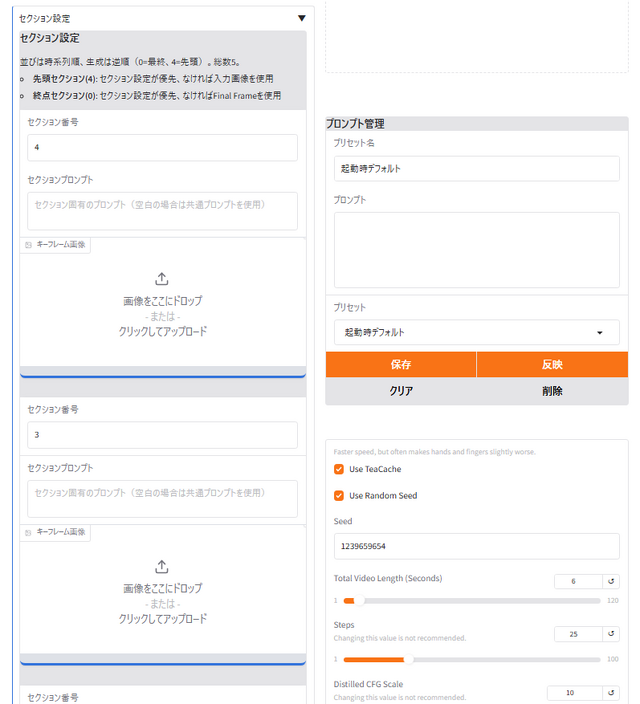

マルチキーフレーム対応: 複数のキーフレーム画像を指定し複雑なアニメーションを実現 ※nirvash氏追加機能

柔軟な動画長設定: 1~4秒の短時間モードと6~20秒の長時間モードに対応 ※独自機能(v1.5.1で1秒モード追加、v1.6.1で2~4秒モード追加)

MP4圧縮設定: 動画のファイルサイズと品質のバランスを調整可能 ※v1.6.2で本家からマージ

【試験実装】オールパディング機能: すべてのセクションで同じパディング値を使用 ※v1.4で追加

【試験実装】フレームサイズ設定: 0.5秒モードと1秒モードを切り替え可能 ※v1.5で追加

【試験実装】セクションごとのプロンプト設定: 各セクションに個別のプロンプトを指定可能※v1.2で追加

【調査中】Hunyuan LoRAサポート: モデルのカスタマイズによる独自の表現を追加 ※v1.3で追加

出力フォルダ管理機能: 出力先フォルダの指定とOSに依存しない開き方をサポート ※v1.2で追加

プロンプト管理機能: プロンプトの保存、編集、再利用が簡単 ※v1.3で追加

ログ機能: 詳細な経過情報や終了時に処理時間を出したりWindowsだと音を出したりします ※独自機能

クロスプラットフォーム対応: Windows以外の環境でも基本機能が使用可能 ※多分

【v1.7新機能】赤枠/青枠によるキーフレーム画像効率的コピー: 2つのキーフレームだけで全セクションをカバー可能に

を挙げています(この部分はGitHubの説明からコピペ)。ちなみに、この記事を書いている途中でv1.7が追加されていることを知りました。毎日のようにアップデートがされています……。

さらに、codeさんによる日本語のプロンプト書き方講座など、手取り足取り超便利なドキュメントは非常に参考になります。

長尺の動画で筆者が必須と感じた、マルチフレームとそれぞれのフレームにおけるプロンプト記述がきちんとサポートされていて、この点では商用サービスに引けを取りません。

本家をインストールした後に、必要ファイルをコピペする変則的な設定方法ですが、それだけの価値は十分にあります。

■FramePackはMacにも対応

本家ではWindows版は1クリックインストーラーがあり、Linuxにはコマンドラインでインストールできますが、Macには記載がありません。

そこへ、brandon929さんによる、Macに対応したフォークが登場しました。Metal Performance Shaders(MPS)によって、Apple Silicon Mac上で動作します。

筆者はChatGPTにステップバイステップのインストール方法を助言してもらいながらセットアップ。Python仮想環境のvenvを使ってすんなり行けました。

とりあえずM4 Max MacBook Pro(128GB Unified Memory)で5秒のImage to Videoを生成し、約22分かかりました。RTX 4090ならば約6分ですから4倍以上の時間がかかることになります。

FramePack-eichiはMac版でも使えそうですが、最大20秒の長尺で使うにはちょっとスピードが足りない感じですね。そういう用途であればNVIDIA GPUでやった方が良さそう。

■Vidu Q1を試す

そして、マルチフレームで動かすためには、それ用の動画をまず生成してみるのがいいのではないかと思います。手っ取り早いのは、よく動いてキャラクター一貫性の高い商用動画生成AIを使うこと。

筆者はRunway、Luma、Sora、Veo 2、KLING、Vidu、Hailuoの7つの動画生成AIをサブスクして、用途によって使い分けています。それぞれ新機能追加と性能向上に励んでおり、新しい生成モデルを頻繁にアップデートしています。そのおかげでAIサブスクの金額は膨れ上がっており、もうすぐ月額20万円に届きそうな状況です(誰か止めてくれ)。

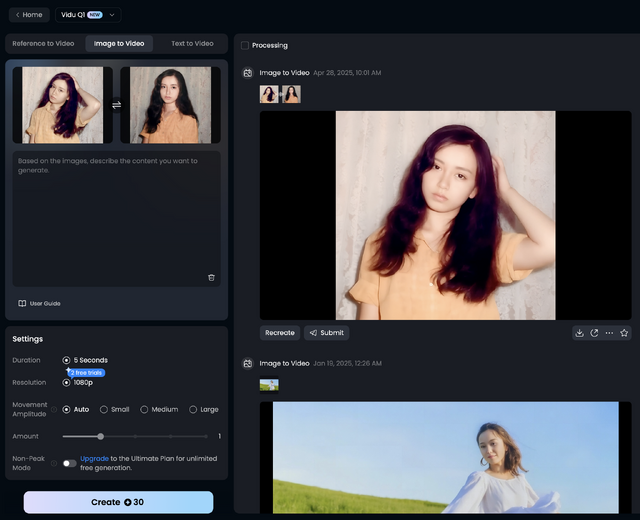

1社が突出すればそれで終わりになって、それ以外のサブスクがやめられる……そんなことにはなっていません。Soraが出てくれば、Veo 2が出てくれば他はいらなくなるなんてことも起きず。そんな中、この中の一つであるViduが新しい「Vidu Q1」というモデルを公開しました。これが相当に良いのです。

KLING、Vidu、Hailuoの3つは中国企業のサービスで、そのおかげで日本人のキャラクター一貫性はどれも高水準。これまでは動きが激しいViduよりも、おとなしめのKLINGを使うことが多かったのですが、FramePackのマルチフレームで切り出す場合にはむしろ動いが大きい方がありがたい。

そこで、Vidu Q1を試してみたのですが、これからはQ1を標準で使おうかなというくらい、キャラクターの一貫性を維持した上での動きが良いのです。そして解像度は1080p。残念なのは長さで、5秒間のみです。

これで生成した動画はどの場面でも人物が本人性を維持して崩れていないので、他のマルチフレームで利用できそう。解像度が高いのも有用ですね。

サウンド機能もベータリリースしました。ただ、これはMMAudioのように動画に自動で音をつけるものではなく、自分で秒単位でサウンドをプロンプトで重ねていくという方式。より細かく設定したい場合には便利です。

Viduは日本市場への浸透も図っていきたいようで、日本語インタフェースの提供、カスタマーサポート体制の構築、クリエイター向けコミュニティ機能の強化などを日本市場向けに展開していくそうです。日本向けのプレスリリースを出すとか、すごく力を入れていますね。特にアニメでの利用を訴求したいようです。

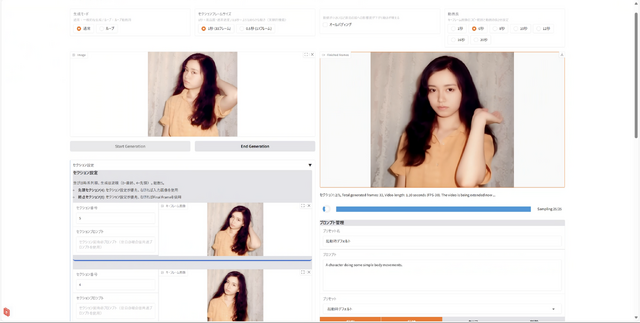

■Vidu Q1とFramePack-eichiを連携させる

Vidu Q1で生成した動画からさらに静止画17枚を切り出し、そのうちの7枚をFramePack-eichiでマルチフレーム再構成してみたところ、うまくつながりました。

欧米の生成AIでは、日本人キャラクターを動かすと、元の美しさが台無しになることも多く、その意味でも安心して使える商用サービスがまた1つ加わった感じです。あとは、せっかく日本語対応もしてくれそうなので、日本語でのプロンプトもお願いしたいところです。

■今さら? Veo 2がGeminiで使えるように

ところで日本語プロンプトでの動画生成では、GoogleのVeo 2がようやくGemini内で生成可能になりました。

今のところText to Videoだけなので自分にとってはほとんど使い道はありませんが、8秒間の高精細動画を追加料金なしで生成できるのは魅力ですね。