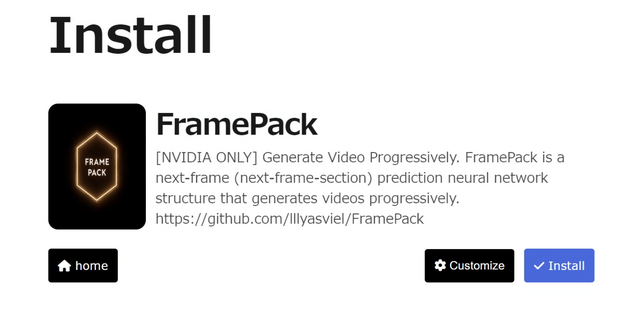

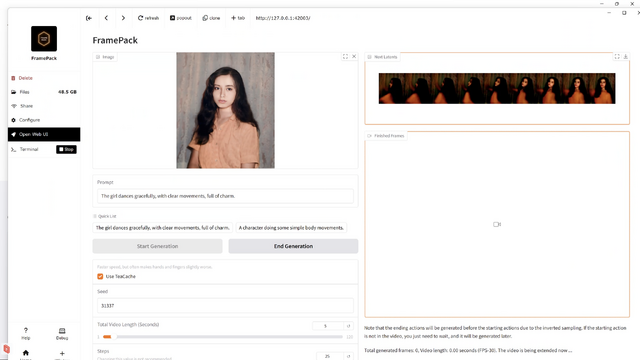

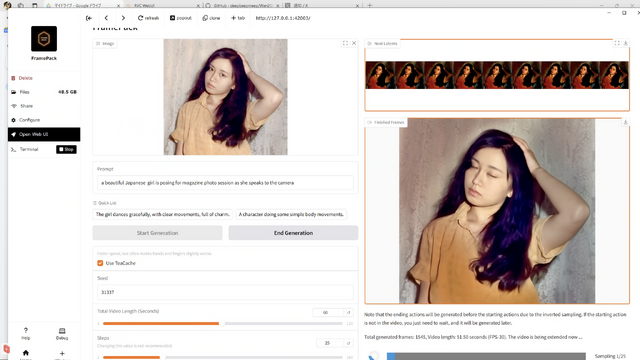

本日2本目のAI記事。ControlNet、WebUI Forge、Fooocusなど、画像生成AIソフトに多大な貢献をしてきたlllyasvielさんが、動画生成AIの新しいオープンソースソフト「FramePack」を公開しました。NVIDIA GPU専用ですが、WindowsとLinuxですぐに使えます。6GB VRAMでも動作するとしています。

筆者は、AI仮想環境のPinokioを使い、RTX 4090を搭載したCore i 7マシンに1クリックインストールしましたが、非常に軽快に動きます。

Image to Videoで動かした場合、1秒当たり1分ちょっとの生成時間。これは爆速と言っていいでしょう。

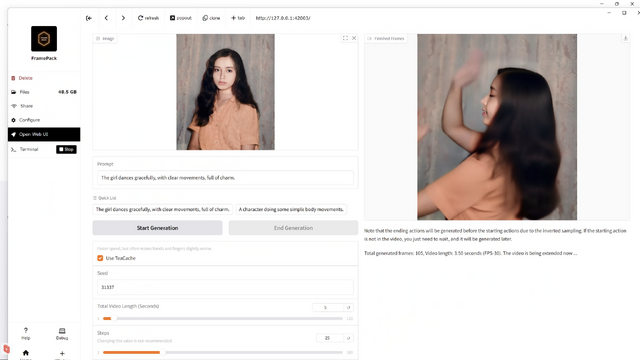

デフォルトの設定で、Image to Video生成してみましたが、高速な上に、破綻は感じ取れません。

複数のフレームがまず画面右上に高速に表示されていきます。これが1秒分溜まると、下のスペースに動画表示。

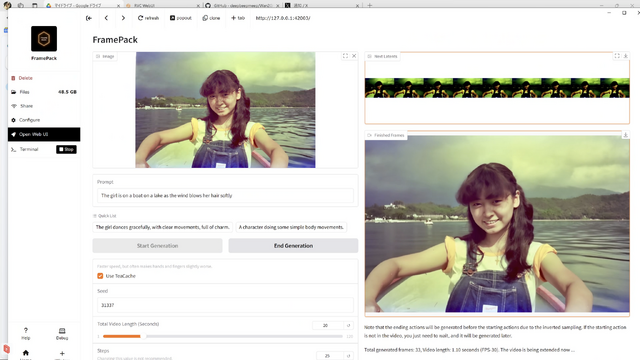

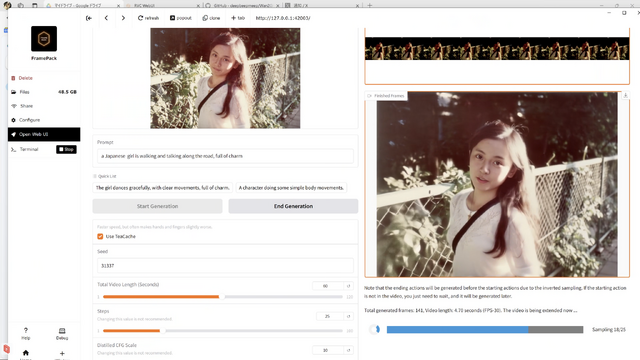

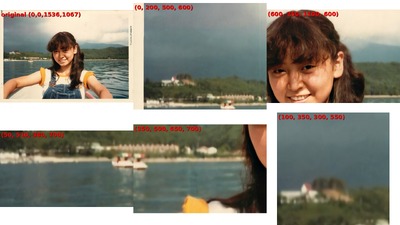

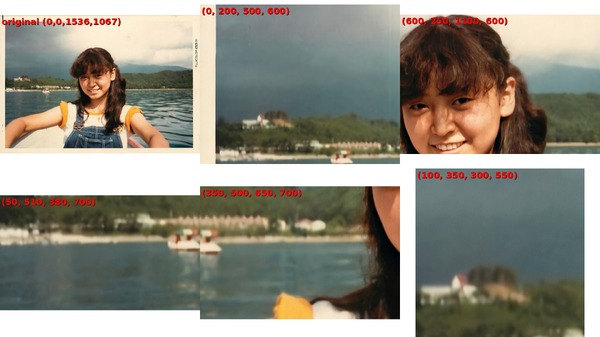

もっと長いものはどうかと、時間を20秒に設定して、ChatGPT o3によって撮影場所が白樺湖だと特定された1981年の写真を動かしてみました。

こちらも問題なく生成できました。商用動画生成AIサービスと比べても遜色ありません。

20秒だと、Soraでも破綻するのに問題なく生成しています。Pikaはマルチフレームを使って25秒が限界。ではその先はどうか?

FramePackでは、GradioのWeb UIを使った場合、生成可能な長さは最大120秒となっています。これは実にすごい。2分間、動き続けさせられるというのです。

20秒の生成に要した時間は21分20秒。これがRTX 5090ならばさらに高速になるはずで、十分に実用範囲と言えるでしょう。

そうそう。筆者のGemini AdvancedにVeo 2はまだロールアウトされてきません。まあ、きてもたかが8秒ですからね……。

高性能な動画生成ならローカルデバイスを選ぶ、そんな時代が来てしまいました。

では、長いやつに挑戦してみましょう。

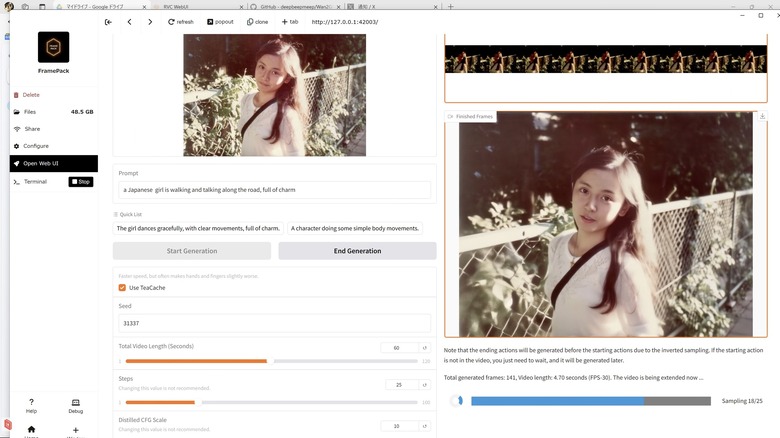

最初の120秒生成は、プロンプトが悪かったのか、色がおかしくなり、動きもないという部分が発生。長い動画で一貫性を維持することの難しさを改めて実感しました。

それでも20秒以上は維持できているので、優秀ではあります。

次に、60秒で試してみました。生成に要した時間は1時間10分。生成は最後のフレームから前の方に向かって行われる仕組みで、最初の方が一番変色しています。このため、髪の毛とシャツの色が不自然なところから始まっています。

ラストの30秒くらいは色の問題が起きていないようなので、人物写真をもとにしたImage to Videoはこの辺りが限界点なのかもしれません。

でも1分生成でいるというのは驚異的です。これまでの限界が25秒だったのですから。

とりあえず、Sunoでこの写真にあった歌詞と音楽スタイルを考えさせ、作曲したものをBGMにつけてみました。

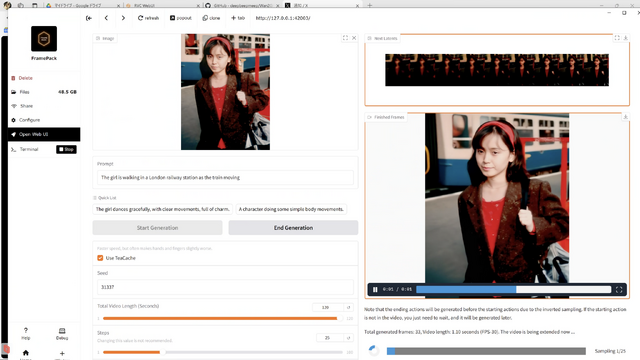

さらに別の写真で試してみます。こちらは色が変になることなく、1分間の動画にできました。処理時間は1時間7分でした。色の劣化は元写真によるのでしょうか。

こちらはChatGPTに動画を読み込ませて歌詞を考えてもらい、少し修正しました(設定が夜になっていたので昼間に変更)。それをSunoで作曲したものを音楽に使っています。

このくらいの長さなら、ローカル処理できるオープンソース作曲AIのYuEでも可能なので、完全にローカルマシンでミュージックビデオを作るということも可能です。

それにしても今週のAI周りの進展はどうしたというのでしょうか?

この記事の掲載を明日にしたらまた明日に大物の発表があるかもしれないし。だから、できたらすぐ検証して記事を書くというスタイルにせざるを得ない感じです。

追記:90秒で問題なく生成できるか、試してみました。

デフォルトプロンプトの一つであるdancing gracefullyを使ったのですが、途中、腕が溶けてたり3本になってたりするところはありますが、全体的には破綻ない感じ。

生成には4090マシンで1時間48分かかりました。

音楽は、元写真をChatGPT o3に読み込ませて作詞したものをSunoで作曲。ボーカルはRVCで妻の歌声に置き換えてあります。腕が3本になったところはカットしましたが、そのほかの不自然なところは、異世界のことなんでそういうものだと思ってご容赦ください。

その後、4分の動画生成にも成功しました。別の記事にしてありますので、そちらもどうぞ。

![生成AIグラビアをグラビアカメラマンが作るとどうなる?第46回:遂にオープンでFLUX.1 [dev]を超える!? HiDream-I1登場(西川和久) 画像](/imgs/p/KS0xA70UphpJ5g7PcXQyhA2bwJXOlZSTkpGQ/24799.jpg)