WWDC23での衝撃の発表から、すっかり謎に包まれたまま、発売までしばらく間があるとあって、ひと段落したVision Pro騒ぎ。しかし、時代を担うデバイスのひとつになることは間違いない。

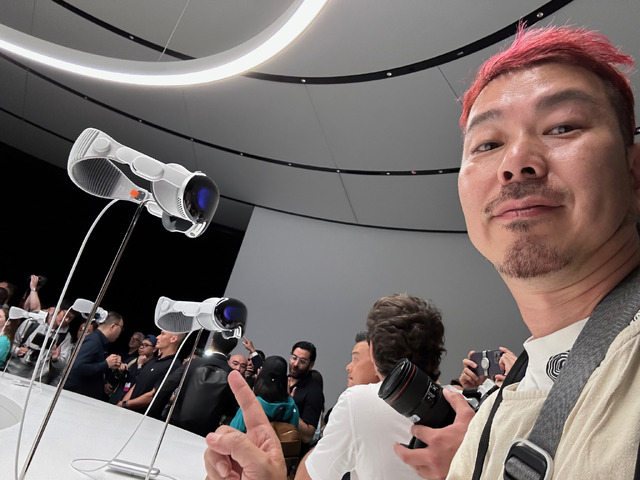

そこで、Apple ParkでVision Proを試用して来た経験に基づいて、前回のレポートに次いでVision Proに対する疑問に答えていきたい。

Q1:いったい何に使うの?

体験して一番最初に感じたのは、『仕事に使いたい!』ということである。

筆者は普段、ディスプレイアームに5Kと4Kのモニターを載せて、それに向かって仕事をしている。大量の文字を読み、大量の文字を書く仕事なので、可能な限り『楽な姿勢で』『目に負担をかけずに』仕事をしようとして、そういう仕事環境を整えたが、それでもチョイチョイとディスプレイの位置を変える。

朝と夜では姿勢が変わるし、目も疲れてくるから、ディスプレイを浮かべたい距離も変わって来るのだ。どうも、ディスプレイの位置に合わせて、姿勢を作らなければならないのが、疲れの原因のような気がする。

Vision Proは好きな位置にディスプレイを浮かべることができるから、この苦労から解放されるのではないかと思う。ソファーに座った状態で目の前にディスプレイを浮かべることもできるし、なんなら寝ころんだ状態で目の前に表示することもできるはずだ(デフォルトのアプリではモニターの角度には制限があった)。

いくつものアプリを中空に浮かべて仕事をするのは快適だろう。Macのモニターも表示できるそうだし、マウスやキーボードも接続できるらしいので(試用時は、その環境はなかった)かなり、快適に仕事ができるように思う。

では、1ポンド(約453g)と言われるVision Proを装着して、一日中仕事ができるかというと、それは疑問だ。試用は40分ほどだったし、興奮して疲れを感じる状態ではなかったので、なんともいえない。

映画も『見たことのない立体感』で楽しめるので、映画などの各種エンターテインメントも期待できる。

マインドフルネスアプリも素晴らしい経験だったので、3D映像や音響を使ったリラクゼーションアプリ関連は、その実際に空間を感じているのに没入していく感覚が新鮮だと感じた。

とはいえ、マインドフルネスのために50万円のデバイスを買う人はいないだろうから、やはり現状では筆者が感じた一番のニーズは『仕事』。

もっとも、iPhoneだって、登場した当初は『主に電話に使う』と思っていたし、YouTubeやTikTokを見たり、写真を撮ってインスタに投稿するためのデバイスになるとは思っていなかったので、実際に市販されてみないとわからない部分はあるが。

Q2:眼鏡利用者は使えないの?

コンタクトレンズの人は使えるが、眼鏡利用者は『光学インサート』と呼ばれる専用のレンズをVision Proに装着して使うことになる。

この光学インサートは、検眼して最適なものを購入することになるので、眼鏡利用者は余分なコストを支払うことになりそうだし、他の人が所有するVision Proをゲストとして使うのも難しそう。

多くのVRゴーグルが眼鏡を許容するのに、Vision Proで使えないのは、Vision Proが視線入力を利用しているからだろう。Vision Proの内側、目の回りに設けられたセンサーが目の動きを捉えるのだが、眼鏡があると、正確な動作が難しいということだ。

しかし、逆に光学インサートさえ合わせれば、視覚を強化することもできるかもしれない。外部に設けられるカメラの性能とアプリ次第だが、iPhoneの望遠設定やマクロ設定のように、遠くのものや小さなものを拡大して表示できるようになると、むしろ人間の能力拡大となるかもしれない。

Q3:FaceTimeでビデオ会議をしている時に、先方からはどう見えてるの?

Keynoteで、Vision Proを使ってFaceTimeをしているシーンが出ていた時、「これ、向こう側にはどう見えてるの?」と疑問だったが、この疑問は『ペルソナ』という仕組みを使って解決することが同じくKeynoteの中で紹介された。

ペルソナはVision Proの外側のセンサーを使って顔をスキャンして、3Dアバターを作り、そこにVision Pro内側のセンサーで表情を読み取って、顔を合成するという強引な手段で解決が図られていた。

筆者はApple Parkでの試用時にベルソナ状態の人と会話した。筆者は、「意外とオッケー」だと思ったのだが、海外のレビューを読んでいると「気味が悪い」と言っている人もいたので、人によって意見が異なりそうだ。登場していたのは面識のない人だったから良かったようなものの知人のベルソナをどう感じるのかは、まだわからない。

では、先方から私はどう見えていたのだろうか? 試用時、私は顔のスキャンはしていないから、私のペルソナはないはずだ。

聞いて見ると、私は「真っ白な、顔のないマネキン」のようなカタチで表示されていたらしい。

相手の方(アップルの)は、試用する我々の「真っ白な、顔のないマネキン」に向かって1日中しゃべっているわけで、それもなかなか大変だな……と思った。

Q4:視野角は十分なの?

私は十分だと感じた。

というのも、視界の端が見えなかったからだ。

上手に出来ているなと思ったのが、視界の端は突然終わるのではなく『ぼんやりと暗くなっている』のだ。

つまり、それが自分の視界の限界なのか、Vision Proの視野角の限界なのか、判断できないようになっているのだ。

高精細さと視野角は相反する要素なので、Vision Proが高精細であればあるほど視野角の限界は低いはずなのだが、そこを『端をぼんやりと暗くする』ことで解決しているアップルは巧妙だと思う。

思えば、『空間再現写真』『空間再現ムービー』の端や、パノラマ写真をのぞき込んだ時の上下端など、ぼかして解決されている部分は数多い。

アップルのソフトウェア側の処理の巧妙な部分だと思う。

Q5:バーチャルキーボードは使いものになるの?

デモスケジュールにはバーチャルキーボードで入力するシーンはなかった。

うがった考え方をすれば、それほど良い体験ではないのかもしれない。

どう考えても、空中に浮かんだバーチャルキーボードが快適なわけがないので、あれはパスワードを入力するとか、検索したい文言を入力したりするのに使う……ぐらいの用途しか想定していないのではないかと思う。

その代わりと言ってはなんだが、使い慣れたBluetoothキーボードを使えるそうなので、長文を書くにはそちらが使えるだろう。

筆者は、すでにVision ProとHappy Hacking Keyboardだけを手に持って出張に出掛けることを夢に見ている。

Q6:VR酔いはする?

筆者は、けっこうVR酔いをする方だが、今回の体験では酔いは感じなかった。

それは、Vision Proが半分ぐらいは現実世界を見せているからだと思う。現実世界は実際い現実と同じように見えるので、私の三半規管は機能を失わずに済んでいるのだ。割と安心して歩き回ることもできた。

また、VRゲームをプレイしたとしても、全体をVR空間にせずに、後ろ半分は現実世界のままにしておけば、激しい酔いには見舞われないのではないかと感じた。

半面、この見えている現実世界の映像を歪ませられたり、ひっくり返したりしたら、急速に酔う。信じているものに裏切られる方が、ショックは大きい。既存のVRヘッドセットでもジェットコースターなどの落差の激しいアプリではVR酔いが一気に来たりする。

VR酔いの原因としてよく挙げられるものには、視覚情報と体感情報の不一致、画面の遅延など、脳や自律神経の混乱がある。高精細で追従性の高いパススルーにより現実世界が見えているVision Proの場合は、従来製品とはかなり違っていそうだ。

Q7:日本の狭い部屋では、大画面を表示するとどうなるのか?

体験をしたのは、非常に大きなリビングルームを模した部屋だった。

目の前にある大きな壁に、巨大な500インチぐらいありそうなディスプレイを表示させて楽しんだが、我が家のように狭い家だとどうなるのだろうか? 狭い家だと狭い家なりのディスプレイしか出現させられないのだろうか?

試用時にしつこく、「日本の家は狭いんだ!」と主張して聞いてみると、大きなディスプレイを表示すると壁の向こう側になってしまうような状況は起こるらしい。

しかし、そういう場合は「Digital Crownを回してEnvironmentを展開して、広いスペースを表示して楽しんでいただければ問題ありません」とのことだったが、せっかくVision Proを使うなら、現実空間にディスプレイを表示させたいというのが人情ではないだろうか?

というわけで、Vision Proを満喫するためには、50万円の予算もさることながら、大きな壁のある広いリビングルームを用意する必要がありそうだ。

これは、日本人にとってはなかなか難しい課題になりそうだ。実は、今から試用記事の写真をどこで撮影したらいいのだろう……と悩んでいる。

最初のレポートでは伝え切れなかった様々な疑問に答えてみた。他に質問があれば、ぜひTechnoEdge編集部のTwitterアカウント@TechnoEdgeJPまでお寄せいただきたい。

テクノエッジ編集部では、6月23日にApple Vision Proを実体験した村上タクタさん、西田宗千佳さんによるWWDC23報告オンラインイベントを開催いたします。まだ申し込み可能ですので、ぜひご参加ください。