1週間分の生成AI関連論文の中から重要なものをピックアップし、解説をする連載です。第18回目は3Dモデルで大きな躍進がありました。画像1枚から3Dモデルを高品質に生成する拡散モデル「Zero123++」をはじめとする、生成AI最新論文の概要5つをお届けします。

生成AI論文ピックアップ

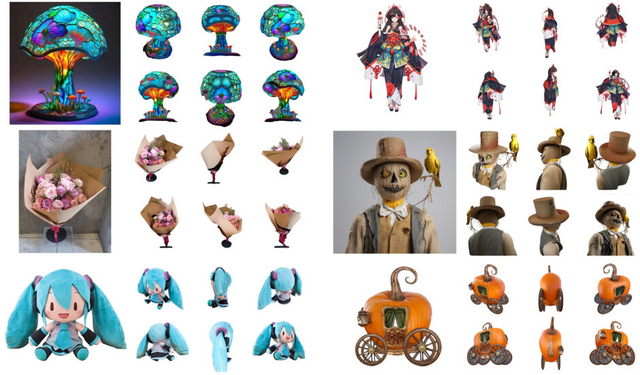

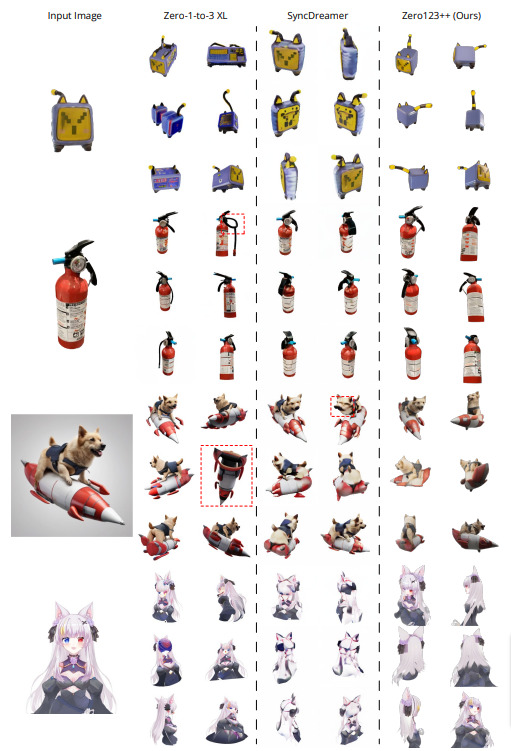

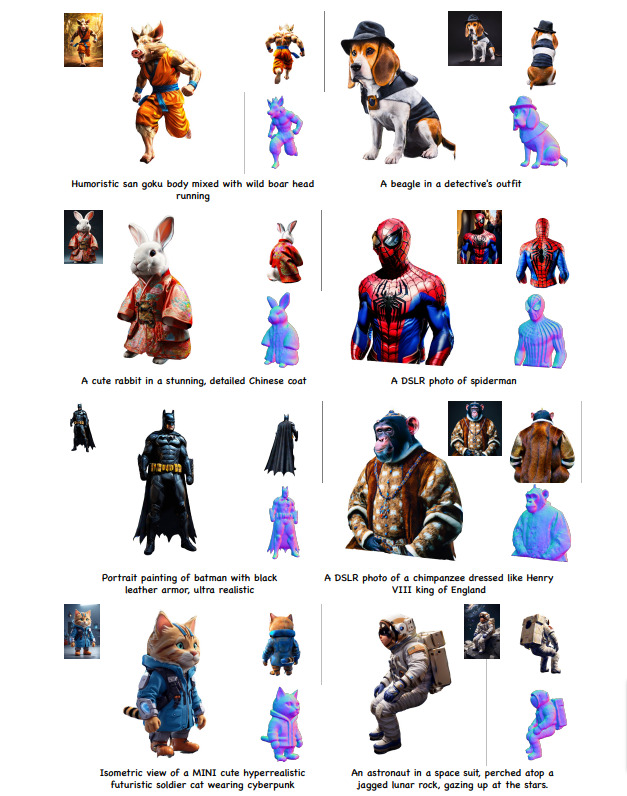

画像1枚から3Dモデルを高品質に生成する拡散モデル「Zero123++」

2023年3月、一枚の画像を3Dに変換する技術「Zero-1-to-3」(Zero123)が公開されました。この技術は高品質な3Dモデルを生成することができますが、生成された画像のジオメトリの不整合性が問題となり、複数の視点の画像と3Dシーンとの間のギャップを埋める課題が残っています。

最近の研究、例えば「One-2-3-45」、「SyncDreamer」、「Consistent123」などは、より3Dに整合性のある結果を得るために「Zero-1-to-3」の上に追加の層を構築しています。さらに、「DreamFusion」、「ProlificDreamer」、「DreamGaussian」などの最適化ベースの方法は、不整合なモデルから3D表現を取得するための技術として提案されています。これらの技術は効果的ですが、一貫性のある複数視点の画像を生成する基盤モデルがあれば、さらに良い結果が期待できます。

この研究では、「Zero-1-to-3」を再評価し、「Zero123++」という新しい画像条件付き拡散モデルを提案。このモデルは、1つの入力画像から3Dの一貫性を持つ複数の視点の画像を生成することを目的としています。

以前のモデル「Zero-1-to-3」は各視点を独立して生成していましたが、これがビュー間の一貫性を欠く原因となりました。そこで、新しいモデル「Zero123++」では、物体を囲む6つの視点を1つの画像に統合する方法を採用。さらに、既存の画像拡散モデル(例:Stable Diffusion)からの微調整の労力を最小限に抑えることで、テクスチャの劣化や形状のズレといった問題を解消しています。

さらに、Zero123++をベースにしたControlNetの訓練により、生成プロセスにおいてさらに高度な制御が可能になっています。

Zero123++: a Single Image to Consistent Multi-view Diffusion Base Model

Ruoxi Shi, Hansheng Chen, Zhuoyang Zhang, Minghua Liu, Chao Xu, Xinyue Wei, Linghao Chen, Chong Zeng, Hao Su

Paper | GitHub | Demo

テキスト入力から高品質な3Dモデルを生成する手法「DreamCraft3D」

2022年9月、Googleをはじめとする研究者たちにより、文章から3Dモデルを生成する手法「DreamFusion」が開発されました。この手法は、3Dモデルの最適化において、ランダムな視点でのレンダリングがテキストに基づいた画像分布と一致するように設計されています。しかしながら、複雑なコンテンツの生成が難しかったり、生成された3Dモデルがぼやけて見えたり、3Dの一貫性に問題があることも確認されました。

本研究では、DreamFusionを基にして進化させた、より高精度なText-to-3Dモデル「DreamCraft3D」を提案します。DreamCraft3Dは、まずテキストプロンプトを基に高品質の2D参照画像を生成し、その後、3Dに変換するという段階的な手法を採用しています。

DreamCraft3Dの特筆すべき特徴の一つは、3DシーンとDreamboothモデルを交互に最適化する点にあります。これにより、3Dシーンが向上するたびにDreamboothモデルも更に精緻になり、その逆も同様に、Dreamboothモデルの向上が3Dシーンのさらなる精度向上に寄与する、という相乗効果が生まれます。

その結果として、DreamCraft3Dは、高い一貫性を持った3Dオブジェクトを生成するだけでなく、そのオブジェクトのテクスチャも大幅に向上させることができます。これにより、テキストから非常にリアルな3Dレンダリングを実現することが可能となりました。

DreamCraft3D: Hierarchical 3D Generation with Bootstrapped Diffusion Prior

Jingxiang Sun, Bo Zhang, Ruizhi Shao, Lizhen Wang, Wen Liu, Zhenda Xie, Yebin Liu

Project Page | Paper | GitHub

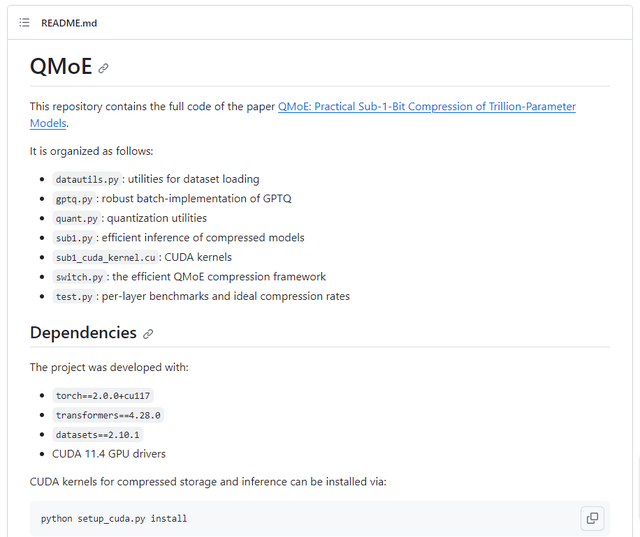

1兆パラメータの大規模言語モデルを一般的なサーバで推論可能にする圧縮フレームワーク「QMoE」

大規模言語モデル(LLM)は、数多くの言語や推論タスクで卓越したパフォーマンスを達成していますが、一方で高い推論コストが課題となっています。

特に注目されているのは、Mixture-of-Experts(MoE)というアーキテクチャです。このアーキテクチャは、モデルの部分を多数複製し、入力データをこれらの部分の一部に効率的にルーティングすることで、処理速度の向上を目指しています。この手法の一例として「SwitchTransformer」が挙げられ、従来のモデルに比べて高いパフォーマンスを誇るものの、モデルのサイズの増大という課題が存在します。

このような背景を踏まえ、本研究では新たなフレームワーク「QMoE」を導入しました。QMoEは、大規模なMoEの効果的な圧縮と、その圧縮されたモデルにおける高速推論を実現することを目的としています。具体的には、非常に大規模なモデルも効率的に圧縮するためのスケーラブルな圧縮アルゴリズムと、特にGPU上での高速デコードを実現するカスタマイズされた圧縮フォーマットを提案しています。

成果としては、QMoEは1.6兆パラメータのSwitchTransformer-c2048モデルを、品質の劣化を最小限に抑えながら、1日以内に単一のGPUで160GB以下(20倍の圧縮率、パラメータあたり0.8ビット)に圧縮することができました。この結果、1兆パラメータのモデルを、NVIDIA A6000を4台、またはNVIDIA 3090を8台搭載した一般的なサーバで、理論上の非圧縮推論に対するランタイムオーバーヘッドが5%未満で運用することが可能となりました。

QMoE: Practical Sub-1-Bit Compression of Trillion-Parameter Models

Elias Frantar, Dan Alistarh

Paper | GitHub

複数のテキスト入力から長めの動画を生成するモデル「FreeNoise」 中国テンセント含む研究者らが発表

動画生成の拡散モデルは、データの次元が増加すると、モデルの容量やデータの要件が大きく増えます。このため、現行のモデルは少数のフレームに基づいて訓練され、動画の長さが増えるにつれて生成される動画の品質が低下する傾向があります。

この問題に対応するための新しい方法として、本研究では「FreeNoise」を提案しています。この方法は、複数のテキスト条件に基づいた高品質の長い動画を生成するためのテキスト駆動型の生成モデルを拡張することを目指しています。

具体的には、動画生成の拡散モデルにおける初期ノイズの影響を分析し、事前に訓練されたモデルの生成能力を強化すると同時に、内容の一貫性を保持する、チューニング不要で時間効率の良い新しい手法を提案しました。

多くの動画生成の拡散モデルは、複数のテキスト条件が与えられても、1つのテキスト条件だけを利用します。これは、訓練データセットが通常1つのテキスト条件しか含まないためです。この制約を解消する新しい手法も提案しており、複数の指示に基づく長い動画生成を実現します。

FreeNoiseは、他の手法に比べて時間の効率が良く、既存の最良の方法が追加で255%の時間を必要としたのに対し、この手法はわずか17%の追加時間しか必要としないという結果を得ました。

FreeNoise: Tuning-Free Longer Video Diffusion Via Noise Rescheduling

Haonan Qiu, Menghan Xia, Yong Zhang, Yingqing He, Xintao Wang, Ying Shan, Ziwei Liu

Project Page | Paper | GitHub

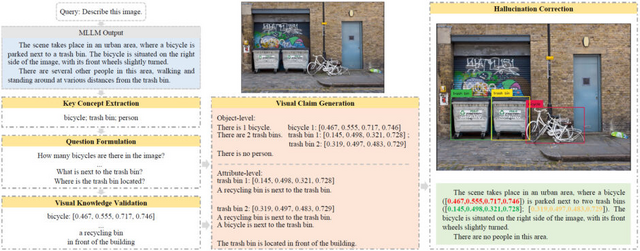

画像認識AIの「幻覚」を見つけて修正する技術 中国テンセント含む研究者らが開発

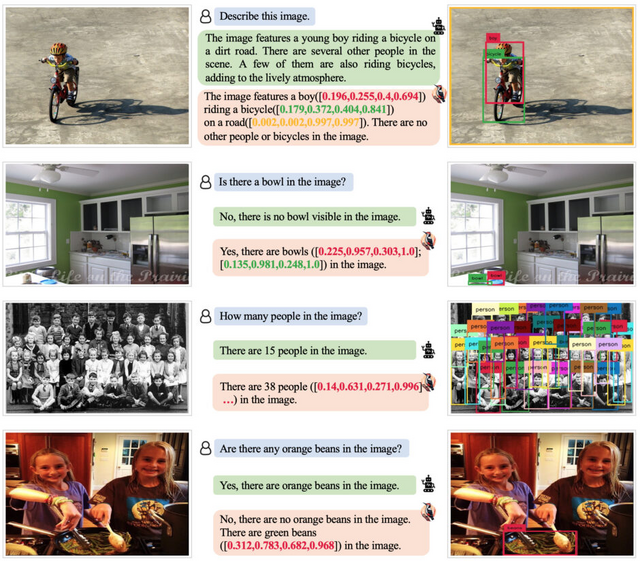

マルチモーダル大規模言語モデル(MLLM)は、言語と視覚などの異なるモダリティを組み合わせることで、例えば画像の内容を詳細に説明するなどの機能を持っています。この技術の進化により、機械が人間のように情報を認識し、詳細に表現することが可能になりました。

しかしながら、現在のMLLMにはまだ課題が残っています。特に「幻覚」(ハルシネーション)と呼ばれる現象が問題となっています。これは、モデルが存在しないオブジェクトを認識したり、オブジェクトの属性を正確に説明できなかったりすることを指します。このような誤りは、MLLMの実用化における大きな障壁となっています。

現在の研究では、特定のデータでモデルを再トレーニングする指示調整の方法を主に採用して、この幻覚を緩和しようとしています。しかし、この方法は多量のデータと計算リソースを必要とし、新しいデータや状況に迅速に対応するのが難しいことが挙げられます。

そのため、新しい対策として「Woodpecker」というトレーニング不要のフレームワークが提案されました。このフレームワークは、MLLMによって生成された誤ったテキストを修正し、それに関連する証拠を提供することで、幻覚を直接的に修正します。

具体的には、5つのステージから成り立っており、それぞれキーコンセプトの抽出、質問の形成、視覚知識の検証、視覚的主張の生成、そして幻覚の修正という手順を踏んでいます。Woodpeckerは後処理の形で実装されており、様々なMLLMに簡単に適用することができます。

Woodpeckerの効果は、POPEベンチマークにおいて基準となるMiniGPT-4/mPLUG-Owlに対し、30.66%および24.33%の精度向上を達成していることで明らかとなっています。

Woodpecker: Hallucination Correction for Multimodal Large Language Models

Shukang Yin, Chaoyou Fu, Sirui Zhao, Tong Xu, Hao Wang, Dianbo Sui, Yunhang Shen, Ke Li, Xing Sun, Enhong Chen

Paper | GitHub | Demo