「It's Glowtime」と題されたAppleイベントが終了しました。恒例となった9月のiPhoneとApple Watch新作発表が行われ、今回はさらにAirPodsシリーズも新製品と旧製品の改装版が出たわけですが、気になるのは、「今回の新製品は、Apple Intelligenceのために必要なものかどうか」です。

Apple新製品発表会・iPhone 16実機ギャラリー(50枚)

iPhoneのApple Intelligence対応について、Appleは製品ページで次のように記載しています。

Apple Intelligenceは、iPhone 16の全モデル、iPhone 15 Pro、iPhone 15 Pro Maxで、iOS 18のアップデートとして年内にベータ版で利用できるようになります。Siriとデバイスの言語を英語(米国)に設定する必要があります。一部の機能の公開と日本語、フランス語、スペイン語などの追加言語への対応は、今後1年にわたり開始される予定です。

発表の中でApple Intelligenceが日本語で使えるのは2025年になると述べていましたが、上の記述と合わせると、2025年の9月あたりまでの間に対応する、ということになります。これら新製品の次のモデルが出るまでに公開される保証はありません。当面、Apple Intelligenceは言語を英語にして使うことになります。

では、個別に見ていきましょう。

■Apple Watch Series 10はオンデバイスSiriが高速に?

Apple WatchはApple Intelligenceのサポートデバイスではありませんが、Apple Intelligenceとのインタフェース部分となるSiriについてはApple Watch Series 10を買うメリットがあるかもしれません。それは新しいS10 SiPの存在。

Series 10は、Ultra 2のS9より1つ進んだバージョンとなっており、「一段と速いオンデバイスSiri」をうたっています。具体的に応答速度がどの程度高速化されているのかは分かりません。「一段と速いオンデバイスSiri」はUltra 2にも記述がありますが、この2モデルに差はあるのか、これも不明です。

Apple WatchはApple Intelligenceのオンデバイス処理ができるわけではありませんが、Siriの応答性で優位であること、そしてスピーカーを改良してポッドキャストや音楽を内蔵スピーカーから聴けることと合わせると、できることの可能性は広がるかもしれません。

▲Apple Watch Series 10のスピーカーは30%小さくなったが音響性能は維持しているという

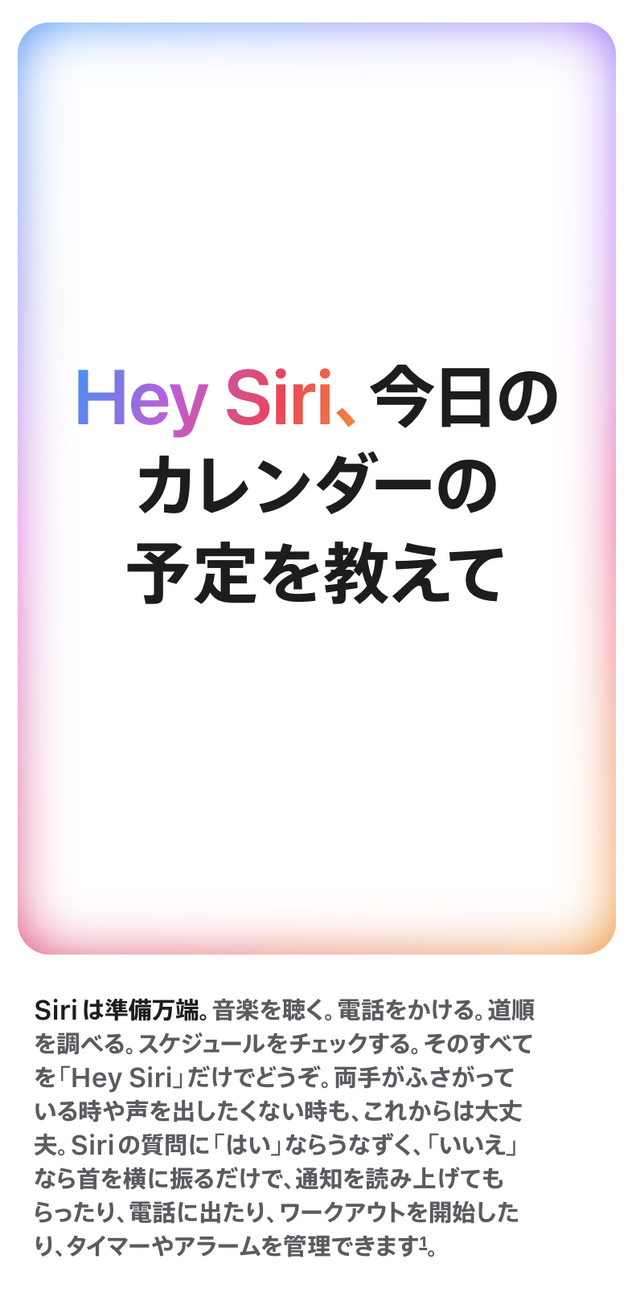

■AirPods 4とAirPods Pro 2は「頭の動きでSiriにYes / No」

AirPodsシリーズで新製品として発表されたのはAirPods 4(ノイキャンありとなし)とUSB-C対応のAirPods Pro Maxですが、Apple Intelligence的に重要なのは、AirPods 4とAirPods Pro 2の「Siriへの応答」機能です。

Siriからの質問に、はい、いいえを答えるときに、音声や画面での応答だけでなく、「うなずく」、「首を横に振る」アクションで指示ができる機能は、AirPods 4とAirPods Pro 2のみの機能です。対応OSは、iOS18、iPadOS18、macOS Sequoia以降。

「Siriを応答」機能を使いたいなら、AirPods 4とAirPods Pro 2を購入しておきましょう。

■A18とA18 ProはApple Intelligenceをどれだけ強化する?

Apple Intelligenceに対応したiPhoneは今日まで、iPhone 15 ProとPro Maxのみでした。というのも、iPhoneの場合、必要なプロセッサとしてM1以上またはA17以上という条件がつけられているからです。

「A17だと使えないけどA18ならこれができるようになります」、「この機能が使えるのはA18 Proだけです」といったことの説明はされていなかったので不明。

プロセッサの性能が問われるのはオンデバイス処理した場合であって、Private Cloud Compute(PCC)に投げられたAIタスクはさほど変わらないと考えられます。

そんな中、A17とA18、A18 Proの性能差を見出すためには、ジョニー・スルージ上級副社長でなく、シュリバラン・サンサナム副社長(シリコン・エンジニアリング・グループ)による解説を手掛かりにするしかなさそうです。

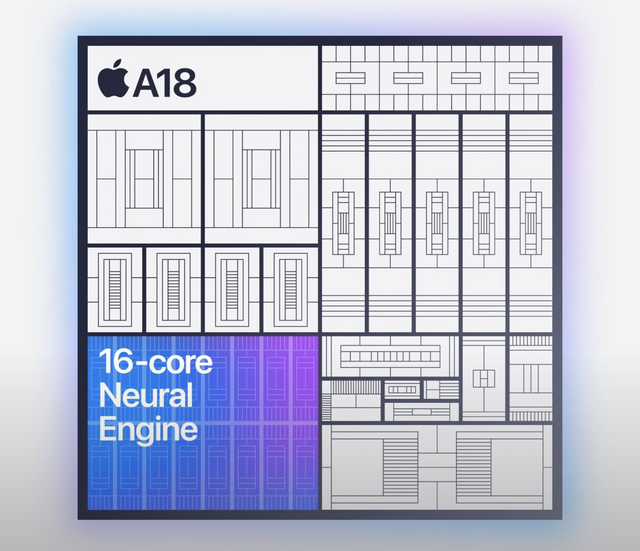

iPhone 16のSoCはA18。iPhone 15がA16 Bionicだったので、前モデルからの性能比は相当高くなっています。Neural Engineは16コアで、「大規模な生成モデルを動かすのに適している」と説明。

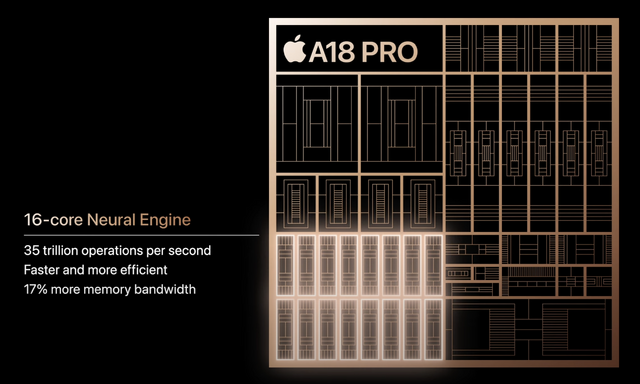

一方、iPhone 16 Proに搭載されたA18 ProのNeural Engineは16コアで、演算性能は35TOPS(Trillion Operations Per Second)。この数字自体はA17と変わっていないようです。

バンド幅は17%向上していて、「Apple Intelligenceと協調することでより高いパフォーマンスを提供します」と説明。ちなみにM4プロセッサのNeural Engineは38TOPSです。

6コアCPUはA17比で15%、6コアのGPUも20%性能アップしています。Apple Intelligenceの推論ではNeural Engineだけでなく、CPU、GPUも使うので、この辺の性能アップが効いてくる可能性もあります。

A18のGPUは5コアなので、A18 Proとはここで差が生まれるかもしれません。

また、A18 ProのCPUには「次世代のMLアクセラレーター」が搭載されており、Apple Intelligenceパワーアップの助けとなるそうなので、iPhone 16との差別化要因とも言えそうです。

とはいえ、現在のApple Intelligenceで提供されているオンデバイスAI機能では、iPhone 15 Proも含めて顕著な性能差が出てくるとは考えにくいです。

iPhone 16 ProとPro Maxそれぞれの前モデルとの仕様比較表はこちらをどうぞ。

■カメラコントロールボタンによるVisual intelligence

画面キャプチャしたり写真を撮影してその内容をAIに判断させるというのは、Microsoft Copilot+ PCやGoogle GeminiでもわかりやすいAIの使い方として提示していますが、Appleはさらに理解しやすいポイントを訴求してきました。

それが、iPhone 16と16 Proで新設されたカメラコントロール(Camera Control)ボタンです。

写真撮影のシャッターボタンなら、カメラ起動中に音量下げボタンを押せば済むし、カメラ起動であればアクションボタンに設定できますが、カメラコントロールボタンは、半押しやパラメータ調整ができるほか、Apple Intelligenceとの連携に役立つことを、クレイグ・フェデリギ上級副社長は、Visual intelligenceとして紹介しています。

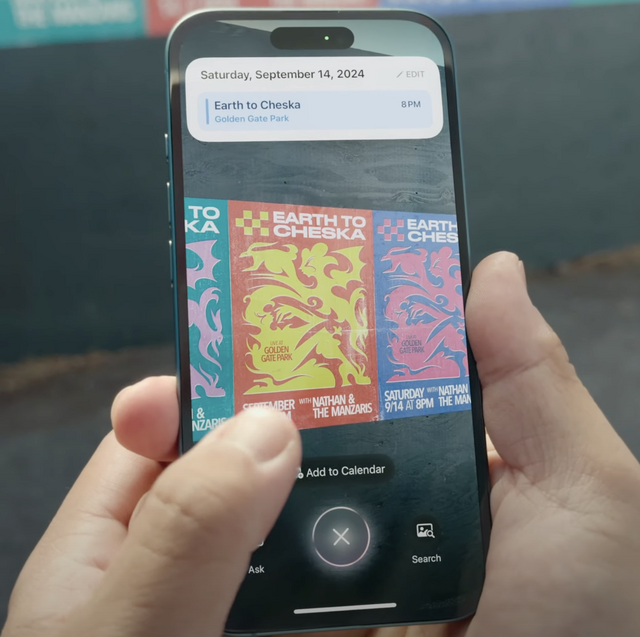

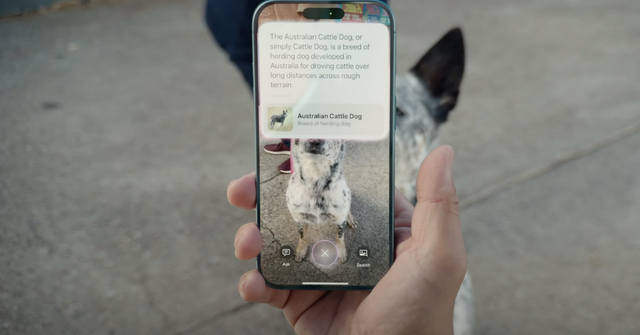

知りたいものにiPhoneの背面カメラを向けてカメラコントロールボタンを押すと、カメラに写った画像をApple Intelligenceが解釈し、必要なアクションを提示します。それがイベントのポスターであれば、イベントのタイトルと日時が入ったイベントをカレンダーに追加することができます。

写っているものをGoogle検索することもできます。アプリのGoogle Lensでも同じようなことができますが、専用ボタンがあることで、そこに到達するためにワンアクションで済むというのがポイントです。

そこに魅力を感じるのであれば、iPhone 15 Proからの乗り換えも正当化できるかもしれません。