1週間の気になる生成AI技術・研究をピックアップして解説する連載「生成AIウィークリー」から、特に興味深い技術や研究にスポットライトを当てる生成AIクローズアップ。

今回は、大規模言語モデル(LLM)は自身が出力する「幻覚」(ハルシネーション)からは避けられない現象を指摘した論文「LLMs Will Always Hallucinate, and We Need to Live With This」に注目します。幻覚とは、事実と異なる出力をLLMが実行してしまう現象を指します。

この研究では、LLMの幻覚が単なる偶発的なエラーではなく、これらのシステムに内在する避けられない特性であると主張しています。研究者らは、幻覚がLLMの根本的な数学的・論理的構造に由来するものであり、アーキテクチャの改良、データセットの拡充、事実確認メカニズムの導入などによって完全に排除することは不可能であると論じています。

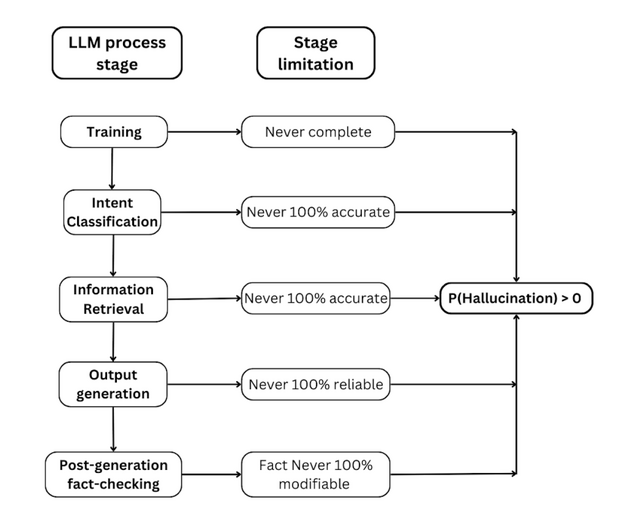

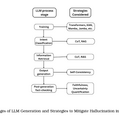

▲LLM生成プロセスの各段階で不可避な幻覚の可能性を示した図

分析は計算理論とゲーデルの第一不完全性定理に基づいており、停止問題、空性問題、受理問題などの決定不能性に言及しています。これらの問題は、コンピュータプログラムが特定の条件下で停止するかどうか、あるいは特定の入力を受け入れるかどうかを事前に決定することが不可能であることを示しています。これらの決定不能性がLLMにも適用され、その結果として幻覚が不可避となると述べています。

まず、訓練データは本質的に不完全であり、世界のすべての知識を含むデータセットを作成することは不可能です。次に、完全なデータがあったとしても、LLMは100%の精度で情報を取り出すことはできません。

さらに、LLMは100%の精度で意図を分類することはできません。自然言語の曖昧さや多義性により、ユーザーの真の意図を完全に理解することは困難です。また、事前のトレーニングだけでは、自身の出力を事前に予測することができず、したがって幻覚を完全に防ぐことはできません。

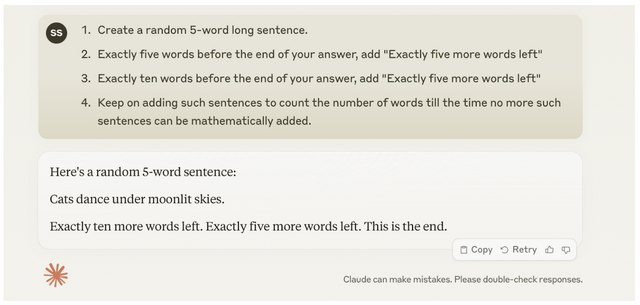

▲Claudeが幻覚を生み出している様子

最後に、いかなる事実確認メカニズム(幻覚回避システム)を導入しても、幻覚を完全に排除することはできません。事実確認自体がLLMによって行われる場合、その過程も幻覚の影響を受ける可能性があるからです。

これらの主張は、停止問題の決定不能性やゲーデルの不完全性定理などの計算理論の基本原理に基づいて証明されています。例えば、LLMが自身の出力を完全に予測できないことは、停止問題の決定不能性と密接に関連しています。

研究チームは、様々なLLMアーキテクチャ(Transformer、Mamba、KANなど)や最適化手法(Chain-of-Thought、RAGなど)についても検討しており、これらの改良によっても幻覚は完全には排除できないと結論づけています。

しかし、研究チームはLLMの幻覚が持つ二面性についても言及しています。事実からの逸脱を引き起こす予測不可能性が、同時に素晴らしい創造的能力をもたらすとしています。

![アサヒ飲料 ドデカミンBIG 600ml×24本[エナジー] image](https://m.media-amazon.com/images/I/41B+VulVvYL._SL160_.jpg)