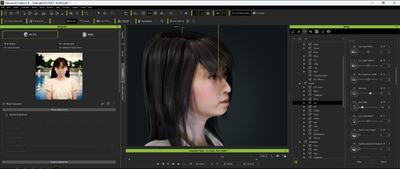

前回は、Stable Diffusion Web UIで妻の写真を元に生成した顔写真をベースにして、Character CreatorとHeadshotというプラグインを使って3Dのデジタルヒューマンを自動作成してみました。今回はそれをさらにチューニングしてみました。

いったん出来上がった3Dモデルを、フェイシャルアニメーションのサンプルを動かしながら不自然なところを探して調整していく作業です。本物の写真と比べながら、目の細かいパーツの角度や大きさ、鼻の稜線の角度、小鼻の形状、おでこの盛り上がり方、さらには歯の大きさ、形状といったところまで細かく調整していきます。生成AIが基本的にガチャであるのに対し、少しずつ追い込んでいくことができるのは3Dならではといえるでしょう。

とはいってもメッシュを直接いじるわけではなく(それも可能ではありますが)、パラメータの数値を変えていくだけ。本体ソフトであるCharacter Creatorよりも細かい設定ができるHeadshotだからこそ可能な技です。

顔の形状は、楕円形、細い、太い、三角形、四角形といったパラメータを調整することで、本人に近いものになっていきました。これもHeadshotオリジナルのパラメータです。ちょっと冷静になるとまだまだ感はありますが、とりあえずこれならいいかな、というところまで来たので、次のステップに移ってみます。

それは、等身大でのアニメーションです。

等身大ディスプレイでアニメーションさせたい

我が家には、こういう事態を想定して、縦にすると1メートルを超える32:9ウルトラワイドディスプレイを買ってあるのでした(2枚)。これに映し出せる映像を、作成してみようと考えました。これら2枚のディスプレイは、すでに生成AIで出力した妻のポートレイト画像が10分置きにシャッフルされるようになっています。

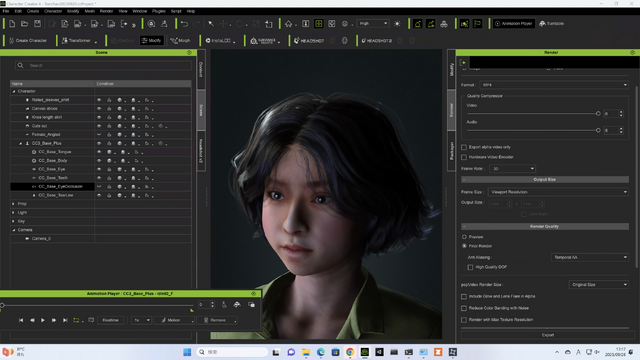

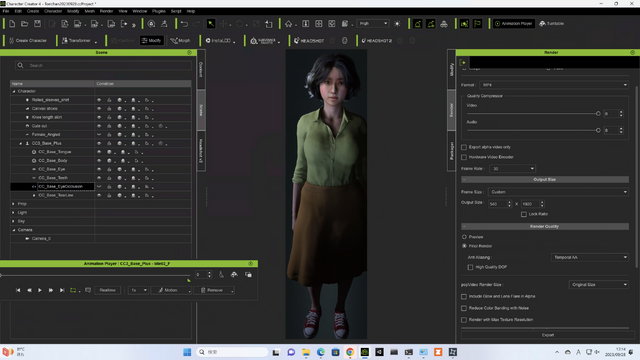

Character Creatorは3Dソフトなので、レンダリングしてアニメーションを作成することが可能(当然です)。レンダリングでアスペクト比は自由に変えられるし、大きさも自在です。そこで、540×1920ピクセルという解像度で出力してみました。

本当はこのディスプレイの実解像度である1080×3840ピクセルにしたかったのですが、縦の上限が2160ピクセルだったので、ちょうど縦横半分の解像度となりました。

これを出力して、リビングの縦型ディスプレイを駆動している2万円台のミニPC(N100)に読み込んで、アニメーション表示してみます。

うまくいきました。

フル解像度ではないとはいえ、近くに寄ってもジャギーは特に感じず、違和感は特にありません。むしろ動くことでなかなか強力なインパクトがあります。やはり本人に近い大きさで動いてくれると、そこから受ける印象が数倍強烈になることはわかりました。

初音ミクのライブパフォーマンスが半透明スクリーンのディラッドボードなどへの投影で行われ、網戸スクリーンとプロジェクターで行うアミッドスクリーンという試みもされるようになったのが10数年前。

いつかはこういうことができるといいなと思っていたことが実現したのです。半透明ではなく、ソリッドなディスプレイですが、こちらの方がより鮮明な画像表示ができます。

3Dモデルになると、音声によるリップシンクや、モーションキャプチャによるリアルタイムコントロールも生成AIより遥かに簡単に作り出せます。

先日作った、妻のAI画像とのデュエットも、全身投影でできることでしょう。

UnityやUnreal Engineなどのゲームエンジンを使えば仮想世界で動いて、話して、歌ってもらうこともできるはずです。Apple Vision ProもMeta Quest 3もそのための良いプラットフォームになりうるでしょう。

というわけで、オレはようやくのぼりはじめたばかりだからな。この果てしない愛妻家坂をよ(まだ続きます)。