西川和久さんのAIグラビアワークショップを担当しているおかげもあり、画像生成AIの最新情報に触れることができています。

なんといっても現在の画像生成トレンドはFLUX.1。これを自分の制作ワークフローに取り入れることができたのでご報告します。

・松尾公也 CloseBox 連載記事一覧 | テクノエッジ TechnoEdge

■テレビ出演時の制作環境はもう古い?

この連載では、妻の写真から学習した生成AI画像と、歌声を学習した生成AI音声によるミュージックビデオ作成手法について語ってきました。

8月23日朝に放映されたテレビ朝日「羽鳥慎一モーニングショー」では、事例の一つとして、「亡き妻と交流するための窓」として、筆者の自宅での制作作業が取り上げられました。その時点での最新情報をお伝えしたつもりです。

この時は、妻の本物の写真や、Stable Diffusion 1.5のBRA5をベースモデルとして妻の写真45枚をDream Boothで学習して生成した画像をRunway Gen-3 Alphaなどで動かしていました。

取材を受けたのは8月20日だったのですが、実はその後に、制作フローの大きな変更があったのです。このため、テレビで放映した情報は最新のものではなくなっていました(番組の主旨としてはそれで良かったのですが)。

その新しい要素というのは、FLUX.1でのLoRA導入です。LoRAはフルファインチューニングよりもコンパクトな環境で学習できる技術。プロンプトに変なタグを書き込まなくてはならないし、フルファインチューンができているのだから不要だと思っていました。

FLUX.1については、Xのプレミアムプランでチャットベースで使えるので試してみたことはあります。西川さんの連載でも取り上げられました。

高性能の画像生成AIサービスとしてはMidjourneyもあることだし(従来のDiscordだけでなく、Web UIで手軽に利用可能になったし)、ローカルで動かしたいという強いニーズを感じてはいなかったのですが、このFLUX.1で人物のファインチューニングが可能だという話が出てきてから、使ってみたくなりました。

テレビ取材の翌日が西川さんのAIグラビアワークショップで、そのときにFLUX.1の実行環境やファインチューニングについて相談していたのですが、すでにいくつかのサービスで、LoRAならFLUX.1のファインチューニングができるという話を伺いました。

なお、このワークショップでは、参加者の個別の質問に西川さんが答えてくれるコーナーがあるので、行き詰まっているポイントなどがある場合には、西川さんの最先端の知見が役立つと思います。テクノエッジ アルファの会員になると、参加費が無料になるほか、過去回も全て閲覧可能になるのでお得です(PR)。

■FLUX.1 [dev] 用のLoRAを作成してみた

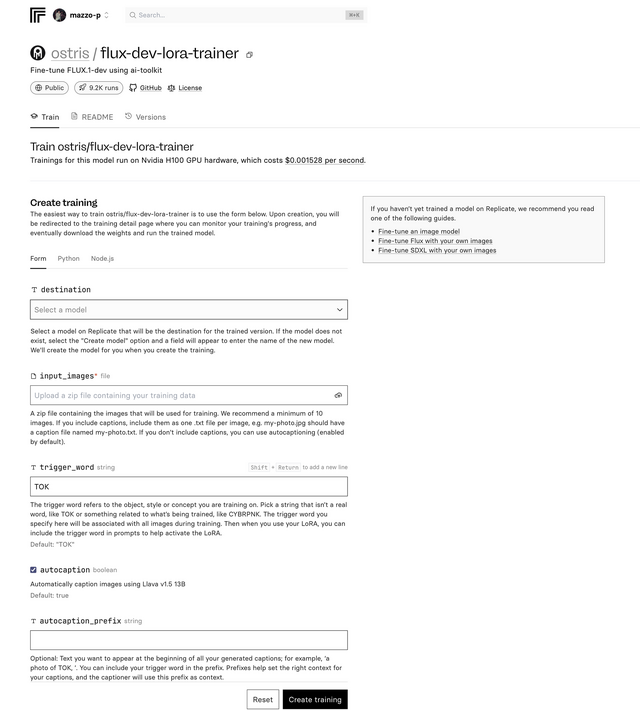

その後、X上での西川さんと新清士さんのやり取りで見つけた、ReplicateのLoRA作成サービス「ostris / flux-dev-lora-trainer」が良さそうだったので、それを使うことにしました。

Replicateはすでに使っていたのと、ユーザーインタフェースがシンプルだったのでこれに決定。

▲Replicateで使えるFLUX.1 [dev] LoRA Trainer

学習させたい画像ファイルと、そのdescriptionを書いたテキストファイルを10~20枚用意してzipしてアップロードし、トリガーワードを決めるだけ。22分で学習が完了し、FLUX.1 [dev] に対応したLoRAができました。画像ファイルのdescriptionは自動でつけてくれるので、同じファイル名のテキストファイルがあればOK。

LoRA作成にかかった料金は1.99ドル。安すぎです。ちなみに料金はNVIDIA H100 GPUの使用時間で決まります。

作成したLoRAはファイルとしてダウンロードできますが、その場で推論(画像生成)することも可能。Stable Diffusion 1.5のファインチューニングと比べて、本人にかなり近い、ハズレのない成果が出ています。

モバイルからも簡単にアクセスできるので、とても便利。調子に乗って使っていたら、LoRA作成よりもお金を使っていました。

また、変なプロンプトは使っていないのに不適切な画像が生成される可能性があるとして、生成を拒否されることも頻繁にあります。やはりローカル実行環境を作らなければ。

▲ReplicateのFLUX.1 [dev] LoRAでそのまま生成した画像

■ローカルマシンにFLUX.1 [dev] の推論環境を作る

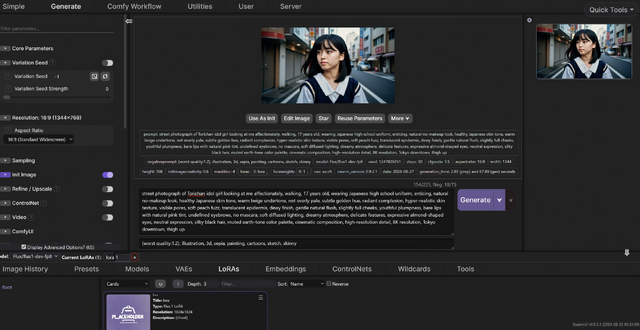

これも、西川さんの動向をウォッチして、画像生成AIのWeb UIの一つであるSwarmUIにしました。実はForgeやComfyUIも使ってはみたものの、必要なファイルなどがうまくはまらずに失敗。「SwarmUIを使って話題のモデル『Flux』を動かす方法」という記事を参考に、インストールしたらうまくいきいました。

ローカルマシンで使用するFLUX.1は[dev]か[schnell]のいずれかになるわけですが、クォリティを考えると[dev]でしょうという西川さんのお勧めに従い、[dev]にしました。その分、生成に時間はかかりますが、品質には納得です。なお、ローカルマシンのスペックは、Intel Core-i7 + GeForce RTX 4090です。

▲SwarmUIでFLUX.1 [dev] + LoRAを実行

ローカルマシンでの妻画像生成は、Stable Diffusion 1.5 BRA6ベースのDream Boothファインチューニングモデルを使っていたのですが、やはり当たり外れがあります。出てくるポーズや顔の向きがかなり限定的で、顔や髪の色も意図したものとは異なる問題がありました。これを改善しようと新たにDream Boothでのファインチューニングを試みようとしたのですが、最近のバージョンではライブラリのコンフリクトがあるらしく、うまく動作しません。

そのため、Memeplexで9枚ずつ生成してそこからチェリーピックする方針に切り替えたのですが、これもなかなか大変な作業です。一貫性のあるポートレート画像を選ぶのにはやはり苦労します。

その点、FLUX.1 + LoRAだと、かなりの確率で、人物の一貫性を持った画像が生成できます。生成時間は4090であってもそれなり(2分以上)かかるのですが、ヒット率が高いので、試行錯誤しなくて済みます。

さらに、FLUX.1ではパラメータの数が多いこともあり、自然言語に近い形でのプロンプト入力が可能。Midjourneyでの詳細にシーンを記述したプロンプトがそのまま通ります。これを使わない手はありません。

■新しいワークフローの誕生

筆者の場合、画像生成の先の、ミュージックビデオを作るのが目的です。人物一貫性のある画像を歌詞に従って作り出し、その画像から動画を生成し、できればリップシンクしたクリップを作る。それを編集して1つのビデオ作品とする、という流れです。

新しいワークフローはこうなりました。

Sunoで曲を作る

歌詞をVerse、Chorusごとに分割

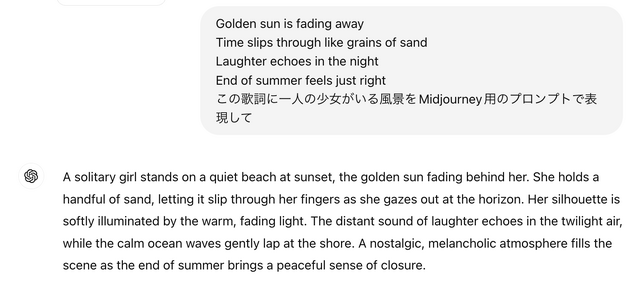

分割した歌詞から想起できる画像のプロンプトをLLMに生成させる

プロンプトに妻LoRAのトリガーワードを加えて生成

画像をRunway Gen-3 Alpha Turboで10秒の動画にする

歌わせたい場合にはSunoのボーカルデータを10秒以内に分割してリップシンク

Logic Pro 11に取り込みボーカルを分離、または、SunoのGet Stemsで分離

ボーカルトラックを10秒以内のオーディオデータに分割

出来上がったクリップをCapCutなどに追加・編集

中でも便利なのは、シーンの詳細な記述が入った画像になるため、Runway上でのプロンプト入力がほぼ不要なことです。

リップシンクさせたいときには「a girl is talking quietly」などのプロンプトを追加しますが、画像自体が雄弁に動きをつけてくれる感じです。

FLUX.1 LoRAを使うメリットは他にもあります。指です。以前のモデルでは指の数、長さが破綻していることが多く、そのために何度も生成し直したり、指が隠れるようなポーズを指定する必要があったのですが、FLUX.1になってからは、そうした遠慮は不要となりました。もちろん指の数が少ない・位置がおかしいということもたまにありますが、ごく少数です。

そのおかげで、「指を突き出して歌う」といった、これまでは不可能だったシーンの生成もできるようになったのです。

▲画像生成AIが不得意だった「指」問題がほぼ解決している

Runwayに限らず、動画生成AIでは元画像が指を隠していてもいきなり髪をかきあげるといった動作をしてしまいがちです。さらに超長いネイルがついていたりとか、指の長さが不自然なものになってしまうことが多々あります。FLUX.1 + LoRAで指が最初から出ている場合にはそうした事故がほぼなくなり、おかげで作業効率が圧倒的に改善されました。

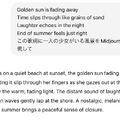

■歌詞から生成した情報量の多い情景描写もOK

情景描写を詳しく自然文でプロンプトに書き込めることで、情報量の多い場面記述が簡単になり、その点でも楽になりました。

歌詞からプロンプトを生成させ、それをFLUX.1のプロンプトに適用。思い通りの画像ができました。

▲ChatGPTが歌詞から生成したプロンプトでFLUX.1が生み出した画像

この画像を起点としたミュージックビデオも数時間で完成しました。

動画生成時のガチャは当然ながらありますが、その前段階である画像生成においては圧倒的に有利になりました。FLUX.1 [dev] + LoRAは、SunoやRunway Gen-3 Turbo Alphaと並んで、しばらくは定番ツールとして使っていくことになりそうです。

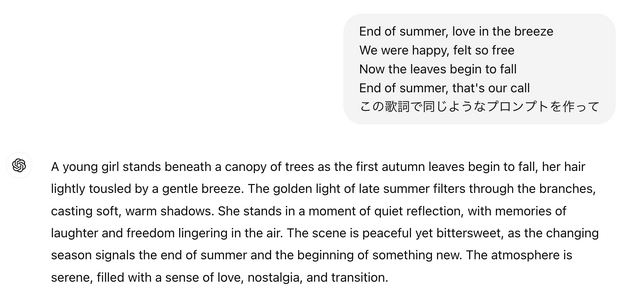

■ 書籍『Suno AIではじめる音楽生成AI入門』発売のお知らせ

そうそう。度重なるバージョンアップに苦しみながらSuno使いこなし術を書いた書籍「Suno AIではじめる音楽生成AI入門」が8月31日、秀和システムから発売となります。良かったら手に取ってみてください。

▲書籍「Suno AIではじめる音楽生成AI入門」(秀和システム)の表紙

![生成AIグラビアをグラビアカメラマンが作るとどうなる?第30回:生成AI画像の本命がいきなり登場!?新型モデルFLUX.1 [dev]を使ってみる(西川和久) 画像](/imgs/p/KS0xA70UphpJ5g7PcXQyhA2bwJXOlZSTkpGQ/18531.jpg)